トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

LLM をゼロからトレーニングする 4 つの段階を明確に説明 (ビジュアル付き):

今日は、LLM をゼロから構築して、実際のユースケースに適用できるようにする 4 つの段階について説明します。

以下について説明します。

- 事前トレーニング

- 命令の微調整

- 設定の微調整

- 推論の微調整

ビジュアルは、これらの手法を要約しています。

飛び込んでみましょう!

0️⃣ ランダムに初期化されたLLM

この時点で、モデルは何も知りません。

「LLMとは何ですか?」と尋ねると、「ピーター・ハンドを試してみてください、こんにちは448Sn」のような意味不明な言葉が返ってきます。

まだデータを見ておらず、ランダムな重みのみを持っています。

これを👇チェックしてください

1️⃣ 事前トレーニング

この段階では、LLM に言語の基礎を教え、次のトークンを予測するために大規模なコーパスで言語をトレーニングします。このようにして、文法や世界の事実などを吸収します。

しかし、プロンプトが出るとテキストを続けるだけなので、会話は苦手です。

これを👇チェックしてください

2️⃣ 命令の微調整

会話型にするために、命令と応答のペアをトレーニングして命令の微調整を行います。これは、プロンプトに従い、返信の書式を設定する方法を学ぶのに役立ちます。

これで、次のことができるようになります。

- 質問に答える

- コンテンツを要約する

- コードを書くなど

これを👇チェックしてください

この時点で、次の可能性があります。

- 生のインターネットアーカイブと知識全体を活用しました。

- 人間がラベル付けした指示応答データの予算。

では、モデルをさらに改善するにはどうすればよいでしょうか?

強化学習(RL)の領域に入ります。

次に👇学びましょう

3️⃣ プリファレンス微調整 (PFT)

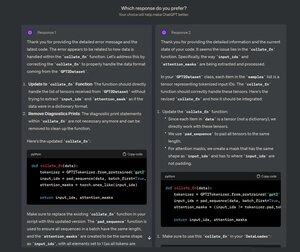

ChatGPT で次の画面を見たことがあるはずです。どの応答が好きですか?

これはフィードバックだけでなく、貴重な人間の好みデータです。

OpenAI はこれを使用して、設定の微調整を使用してモデルを微調整します。

これを👇チェックしてください

PFT の場合:

ユーザーは 2 つの応答から選択して、人間の好みデータを生成します。

次に、報酬モデルが人間の好みを予測するようにトレーニングされ、LLM が RL を使用して更新されます。

これを👇チェックしてください

上記のプロセスはRLHF(Reinforcement Learning with Human Feedback)と呼ばれ、モデルの重みを更新するために使用されるアルゴリズムはPPOと呼ばれます。

これは、「正しい」答えがない場合でも、LLM に人間と足並みを揃えるように教えます。

しかし、LLM をさらに改善することはできます。

次に👇学びましょう

4️⃣推論の微調整

推論タスク (数学、論理など) では、通常、正解は 1 つだけで、答えを得るための一連のステップが定義されています。

したがって、人間の好みは必要なく、正しさをシグナルとして使用できます。

これを推論の微調整👇と呼びます

ステップス:

- モデルはプロンプトに対する回答を生成します。

- 答えは既知の正解と比較されます。

- 正しさに基づいて、報酬を割り当てます。

これは、検証可能な報酬を伴う強化学習と呼ばれます。

DeepSeekのGRPOは人気のある手法です。

これを👇チェックしてください

これらは、LLMをゼロからトレーニングする4つの段階でした。

- ランダムに初期化されたモデルから始めます。

- 大規模なコーパスで事前トレーニングします。

- 命令の微調整を使用して、コマンドに従うようにします。

- 好みと推論の微調整を使用して、応答をシャープにします。

これを👇チェックしてください

洞察力に富んでいると感じた場合は、ネットワークで再共有してください。

→ @_avichawla探して

私は毎日、DS、ML、LLM、RA に関するチュートリアルと洞察を共有しています。

2025年7月21日

LLM をゼロからトレーニングする 4 つの段階を明確に説明 (ビジュアル付き):

@tasiorek27 鉄筋の微調整:

命令の微調整: (これは、命令の微調整データセットを生成することによるトレーニング自体に関するものではありません)

2025年5月6日

Let's generate our own LLM fine-tuning dataset (100% local):

714.03K

トップ

ランキング

お気に入り