Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

cookies (🍪,🍪) | 饼妹

@monad | Gelado Cabal 🍨

cookies (🍪,🍪) | 饼妹 republicou

Curioso sobre quão bem o SFT funciona em relação ao aprendizado em contexto.

O ICL parece mágica negra - o modelo realmente está captando uma série de informações tácitas com eficiência amostral humana.

Se o ajuste fino puder chegar perto disso, talvez você consiga juntar algo que pareça aprendizado contínuo em cima?

Aqui está uma ideia ingênua: Loop interno, fazer SFT em resumos de sessão. Loop externo, RL de longo horizonte onde ele tem que usar habilidades e conhecimentos que precisam passar entre as sessões. O loop externo basicamente trata o SFT como uma chamada de ferramenta, incentivando o modelo a passar o máximo de informações importantes possível.

Estou curioso se algo que junta técnicas existentes assim será suficiente para aprendizado contínuo, ou se precisamos de um novo paradigma completo.

Fiz uma estimativa divertida de Fermi com o ChatGPT para obter alguma intuição em torno dessa questão.

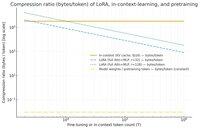

Uma pergunta que você poderia fazer é: quanto o SFT (via LoRA) comprime informações em relação ao aprendizado em contexto? E compará-lo ao pré-treinamento só por diversão.

Se houver uma enorme disparidade (ou seja, se houver muitos mais bytes usados para os caches KV em comparação com os pesos do LoRA), então isso *pode* sugerir que seria muito difícil para o LoRA ser tão rico e eficiente em amostras quanto o ICL.

Novamente, isso é um buraco de coelho de tarde super vago, não uma investigação séria. Só porque usa muito menos memória não significa necessariamente que seja muito mais burro, etc.

Este gráfico é para o Llama 3 70 b (que foi pré-treinado em 15 trilhões de tokens).

Uma vez que chegamos a milhares de tokens de dígitos únicos, o LoRA (cujo tamanho não muda com quantos tokens você está ajustando) começa a ter que comprimir muito mais densamente do que o ICL.

Uma vez que você tem 100k tokens, os tokens passando por um LoRA de rank-32 estão sendo comprimidos 37x mais do que se estivessem sendo atendidos em contexto (via o cache KV).

Nota lateral: os bytes por token de treinamento para pré-treinamento são incrivelmente baixos! (0.009 neste caso).

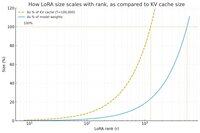

Fiz outro gráfico, desta vez mantendo a contagem de tokens constante em 100k, e variando o rank do LoRA.

Ingenuamente, parece que o rank deve ser pequeno o suficiente para que seja apenas uma pequena fração do total de pesos do modelo (caso contrário, por que se preocupar com um LoRA?), mas também grande o suficiente para conter uma quantidade significativa das informações armazenadas nos caches KV. Assim, você pode ver onde pode estar esse ponto ideal.

De qualquer forma, esses gráficos não são conclusivos sobre nada. E por favor, desculpe quaisquer erros embaraçosos ou mal-entendidos.

Estou ansioso para obter opiniões reais de alto nível sobre quão bem juntar SFT e RL funcionará em termos de fazer o aprendizado contínuo que vemos com o aprendizado em contexto funcionar entre as sessões.

23,26K

Top

Classificação

Favoritos