Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Presentamos `:exacto`, Herramientas de Llamada a Endpoints de Precisión

OpenRouter ahora ofrece un subconjunto seleccionado de proveedores sobre modelos de código abierto con una precisión de llamada a herramientas mediblemente más alta, lo que proporciona un uso de herramientas más confiable.

Lee todos los detalles en nuestra publicación del blog: o continúa leyendo el hilo para el resumen.

Por qué esto es importante:

Incluso cuando los proveedores alojan *los mismos pesos del modelo*, la calidad de la inferencia en el mundo real puede diferir.

Ejecutar miles de millones de solicitudes al mes le da a OpenRouter un punto de vista único para detectar estas variaciones y presentar automáticamente a los proveedores más precisos.

Cómo medimos la calidad del uso de herramientas:

• Validez de JSON

• Coincidencia del nombre de la herramienta y el esquema

• Propensión al uso de herramientas (tendencia a llamar herramientas)

• Preferencias de ignorar/lista negra del usuario

• Referencias externas (τ²-Bench, LiveMCPBench a través de @GroqInc OpenBench)

Estos datos revelan que la precisión en la llamada de herramientas varía mucho más entre proveedores de lo que sugieren los estándares convencionales, incluso para el mismo modelo de peso abierto.

Así que construimos puntos finales que dirigen *solo* a los más fiables.

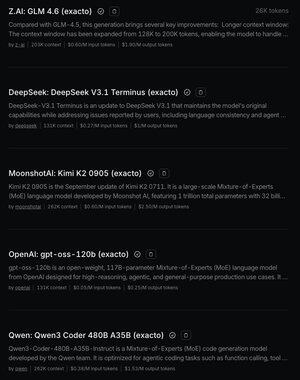

Los modelos de lanzamiento incluyen:

`moonshotai/kimi-k2-0905:exacto`

`deepseek/deepseek-v3.1-terminus:exacto`

`z-ai/glm-4.6:exacto`

`openai/gpt-oss-120b:exacto`

`qwen/qwen3-coder:exacto`

Véelos todos aquí .

Modelos exactos + combinaciones de proveedores:

Kimi K2: @GroqInc y @Kimi_Moonshot

GLM-4.6: @novita_labs, @DeepInfra, y @Zai_org

gpt-oss-120b: Groq, DeepInfra, Novita

Qwen3 Coder: @basetenco, @cerebras, y @GoogleAI

DeepSeek Terminus: @AtlasCloud_AI, DeepInfra, y Novita

Úsalos como cualquier otro modelo, solo añade `:exacto`:

```bash

curl \

-H "Authorization: Bearer $OPENROUTER_API_KEY" \

-d '{"model": "moonshotai/kimi-k2-0905:exacto", "messages":[{"role":"user","content":"¿Cuál es la capital de Francia?"}]}'

```

Los benchmarks y las evaluaciones internas muestran un aumento significativo en las tasas de éxito de llamadas a herramientas en todos los modelos `:exacto`, menos JSONs inválidos, menos desajustes de esquema y mayor fiabilidad en el mundo real. Un agradecimiento a OpenBench de @GroqInc por el arnés de evaluación y el recién añadido LiveMCPBench.

La variante `:exacto` se centra puramente en la precisión de la llamada a la herramienta, no en un ranking general de la calidad del proveedor.

Continuaremos expandiendo estos puntos finales y compartiremos más datos agregados más adelante este año.

139,19K

Parte superior

Clasificación

Favoritos