Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evoluzione del few-shot learning per i moderni LLM di ragionamento utilizzando @NethermindEth AuditAgent come esempio.

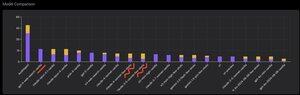

Di seguito puoi vedere un grafico interessante, o meglio, un confronto del numero di vulnerabilità correttamente identificate dal nostro prodotto rispetto a LLM già pronti come @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro o @xai Grok-4.

Certo, la parte ovvia di questo confronto, che ho mostrato molte volte prima e non c'è nulla di nuovo in esso, è che un agente specializzato supererà quasi sempre una soluzione di uso generale. Questa situazione è in realtà spiegata abbastanza facilmente dal fatto che tutte le soluzioni di uso generale fanno parte della nostra soluzione specializzata, sebbene il contributo molto maggiore al risultato derivi da una corretta gestione del contesto o da ciò che @karpathy ha recentemente chiamato "Ingegneria del Contesto."

Oltre a questo, l'uso degli strumenti corretti e la loro selezione - un modello di uso generale avrà sempre problemi perché ci sono miliardi di strumenti e imparare a usarli tutti è una grande abilità a parte, mentre noi insegniamo esplicitamente al nostro modello specializzato questo. Poi c'è l'uso di basi di conoscenza corrette e algoritmi di ricerca adeguati per esse, e così via. Quindi, in un modo o nell'altro, facciamo tutto il possibile, utilizziamo tutti gli strumenti possibili per superare queste soluzioni di uso generale.

Ma il particolare interessante a cui volevo attirare l'attenzione è che se guardi l'immagine che ho pubblicato circa un anno fa, le migliori soluzioni pronte erano i modelli OpenAI o Anthropic con l'etichetta "Few-Shot Learning", mentre ora tutte le migliori sono Vanilla. E questo cambiamento è avvenuto gradualmente con l'emergere del ragionamento come tale nei modelli e con il miglioramento della sua qualità. La conclusione che si può trarre è che gli esempi di soluzioni corrette pronte che il modello riceve da noi come apprendimento in contesto, quando li mostriamo letteralmente nel prompt, smettono di aiutare a risolvere il compito, o più precisamente, senza di essi il modello che può ragionare risolve il problema anche meglio. Cioè, in un certo senso, limitiamo le sue capacità mostrandogli diversi esempi che abbiamo selezionato.

Inoltre, un aspetto interessante è che i modelli con accesso a internet e selezione automatica di questo strumento iniziano anche a superare tutto, il che significa che il modello può andare su internet da solo e formulare il contesto giusto per sé. Sì, certo c'è il rischio che il modello trovi la risposta corretta, ma naturalmente lavoriamo specificamente con questo, facciamo blacklist di siti e così via, quindi cerchiamo di non avere tale fuga nei dati (il benchmarking corretto è fondamentale in generale). Ma la tendenza è interessante - i modelli stanno diventando più intelligenti e assumono sempre più componenti della soluzione da soli, senza richiedere agli sviluppatori di impostare esplicitamente determinate impostazioni nel contesto.

Qual è la tua esperienza con questo?

620

Principali

Ranking

Preferiti