Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Utveckling av inlärning med få skott för moderna resonemang LLM:er med hjälp av @NethermindEth AuditAgent som exempel.

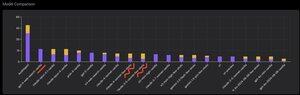

Nedan kan du se en intressant graf, eller snarare en jämförelse av antalet korrekt identifierade sårbarheter av vår produkt jämfört med färdiga LLM:er som @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro eller @xai Grok-4.

Den uppenbara delen av denna jämförelse, som jag har visat många gånger tidigare och det finns inget nytt i det, är naturligtvis att en specialiserad agent nästan alltid kommer att överträffa en generell lösning. Denna situation förklaras faktiskt ganska enkelt av det faktum att alla generella lösningar är en del av vår specialiserade lösning, även om det mycket större bidraget till resultatet kommer från korrekt kontexthantering eller vad som nyligen @karpathy kallat "Context Engineering".

Utöver detta, användningen av rätt verktyg och deras val - en allmän modell kommer alltid att ha problem eftersom det finns miljarder verktyg och att lära sig att använda dem alla är en separat stor färdighet, medan vi uttryckligen lär vår specialiserade modell detta. Sedan finns det användningen av korrekta kunskapsbaser och korrekta sökalgoritmer för dem, och så vidare. Så på ett eller annat sätt gör vi allt vi kan, använder alla möjliga verktyg för att slå dessa generella lösningar.

Men den intressanta nyansen jag ville uppmärksamma är att om du tittar på bilden jag lade upp för ett år sedan eller så, var de bästa färdiga lösningarna OpenAI eller antropiska modeller med etiketten "Few-Shot Learning", medan nu alla de bästa är Vanilla. Och denna förändring har gradvis inträffat i och med framväxten av resonemang som sådant i modeller och med förbättringen av dess kvalitet. Slutsatsen som kan dras är att färdiga korrekta lösningsexempel som modellen får från oss som in-context learning, när vi bokstavligen visar dem i prompten, slutar hjälpa till att lösa uppgiften, eller mer precist, utan dem modellen som kan resonera löser problemet ännu bättre. Det vill säga, vi begränsar dess möjligheter något genom att visa det flera exempel som vi har valt ut.

Dessutom är en intressant aspekt att modeller med internetåtkomst och automatiskt val av detta verktyg också börjar överträffa allt, vilket innebär att modellen kan gå till själva internet och formulera rätt kontext för sig själv. Ja, det är klart att det finns en risk att modellen hittar rätt svar, men självklart jobbar vi specifikt med detta, vi svartlistar sajter och så vidare, så vi försöker att inte få sådant läckage i datan (ordentlig benchmarking är nyckeln överlag). Men trenden är intressant – modellerna blir smartare och tar själva över fler och fler komponenter i lösningen, utan att utvecklarna uttryckligen behöver göra vissa inställningar i sammanhanget.

Vad är din erfarenhet av detta?

647

Topp

Rankning

Favoriter