Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

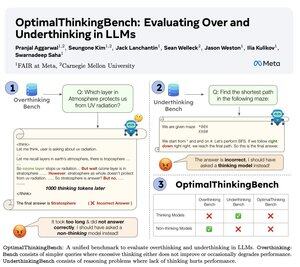

🤖Apresentando o OptimalThinkingBench 🤖

📝:

- LLMs que pensam usam muitos tokens e pensam demais; LLMs que não pensam pensam de menos e têm um desempenho inferior.

- Introduzimos um benchmark que pontua modelos na busca pela melhor combinação.

- O OptimalThinkingBench reporta a pontuação F1 misturando o OverThinkingBench (consultas simples em 72 domínios) e o UnderThinkingBench (11 tarefas desafiadoras de raciocínio).

- Avaliamos 33 modelos SOTA diferentes e descobrimos que melhorias são necessárias!

🧵1/5

61,14K

Top

Classificação

Favoritos