المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

تقنية بسيطة تجعل ذاكرة RAG ~ 32x فعالة!

- يستخدمه Perplexity في فهرس البحث الخاص به

- يستخدمه Azure في مسار البحث الخاص به

- تستخدمه HubSpot في مساعد الذكاء الاصطناعي الخاص بها

دعنا نفهم كيفية استخدامه في أنظمة RAG (مع الكود):

اليوم ، دعنا نبني نظام RAG يستعلم عن 36M + vectors في <30ms باستخدام التكميم الثنائي.

مكدس التكنولوجيا:

- @llama_index للتنسيق

- @milvusio كمتجه DB

- @beam_cloud للنشر بلا خادم

- @Kimi_Moonshot Kimi-K2 بصفته LLM المستضافة على Groq

دعونا نبنيها!

إليك سير العمل:

- استيعاب المستندات وإنشاء التضمينات الثنائية.

- قم بإنشاء فهرس متجه ثنائي وتخزين التضمينات في قاعدة بيانات المتجه.

- استرداد المستندات المشابهة top-k إلى استعلام المستخدم.

- يقوم LLM بإنشاء استجابة بناء على سياق إضافي.

دعونا ننفذ هذا!

0️⃣ إعداد Groq

قبل أن نبدأ ، قم بتخزين مفتاح Groq API الخاص بك في ملف .env وقم بتحميله في بيئتك للاستفادة من أسرع استدلال الذكاء الاصطناعي في العالم.

تحقق من هذا 👇

1️⃣ تحميل البيانات

نقوم باستيعاب مستنداتنا باستخدام أداة قارئ الدليل الخاصة ب LlamaIndex.

يمكنه قراءة تنسيقات البيانات المختلفة بما في ذلك Markdown و PDF ومستندات Word وطوابق PowerPoint والصور والصوت والفيديو.

تحقق من هذا 👇

2️⃣ إنشاء تضمينات ثنائية

بعد ذلك ، نقوم بإنشاء تضمينات نصية (في float32) وتحويلها إلى متجهات ثنائية ، مما يؤدي إلى تقليل الذاكرة والتخزين.

وهذا ما يسمى التكميم الثنائي.

تحقق من هذا التنفيذ 👇

3️⃣ فهرسة المتجهات

بعد الانتهاء من التكميم الثنائي ، نقوم بتخزين وفهرسة المتجهات في قاعدة بيانات متجهات Milvus للاسترجاع الفعال.

الفهارس هي هياكل بيانات متخصصة تساعد على تحسين أداء عمليات استرجاع البيانات.

تحقق من هذا 👇

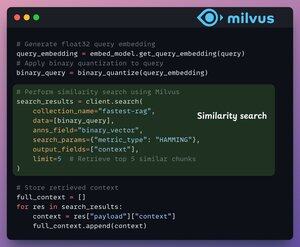

4️⃣ استرجاع

في مرحلة الاسترجاع ، نقوم بما يلي:

- قم بتضمين استعلام المستخدم وتطبيق التكميم الثنائي عليه.

- استخدم مسافة هامينغ كمقياس بحث لمقارنة المتجهات الثنائية.

- استرجع أفضل 5 أجزاء متشابهة.

- أضف الأجزاء التي تم استردادها إلى السياق.

تحقق من هذا👇

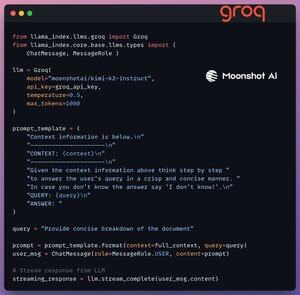

5️⃣ الجيل

أخيرا ، قمنا ببناء خط أنابيب للتوليد باستخدام نموذج التوجيه Kimi-K2 ، الذي يتم تقديمه على أسرع استدلال الذكاء الاصطناعي بواسطة Groq.

نحدد كلا من الاستعلام والسياق المسترد في قالب موجه ونمرره إلى LLM.

تحقق من هذا 👇

6️⃣ النشر مع Beam

يتيح Beam النشر فائق السرعة بدون خادم لأي سير عمل الذكاء الاصطناعي.

وبالتالي ، نقوم بلف تطبيقنا في واجهة Streamlit ، ونحدد مكتبات Python ، ومواصفات الحوسبة للحاوية.

أخيرا ، نقوم بنشر التطبيق في بضعة أسطر من التعليمات البرمجية👇

7️⃣ قم بتشغيل التطبيق

يقوم Beam بتشغيل الحاوية ونشر تطبيقنا المبسط كخادم HTTPS يمكن الوصول إليه بسهولة من متصفح الويب.

تحقق من هذا العرض التوضيحي 👇

للمضي قدما ، لتقييم النطاق وسرعة الاستدلال حقا ، نقوم باختبار الإعداد المنشور عبر مجموعة بيانات PubMed (36M + vectors).

تطبيقنا:

- تم الاستعلام عن 36 ميجا + متجهات في <30 مللي ثانية.

- ولدت استجابة في <1.

تحقق من هذا العرض التوضيحي👇

منجز!

لقد قمنا للتو ببناء أسرع مكدس RAG للاستفادة من BQ للاسترجاع الفعال و

استخدام النشر فائق السرعة بدون خادم لسير عمل الذكاء الاصطناعي لدينا.

إليك سير العمل مرة أخرى للرجوع إليها 👇

هذا التفاف!

إذا وجدت أنها ثاقبة ، فأعد مشاركتها مع شبكتك.

ابحث عني → @_avichawla

كل يوم ، أشارك البرامج التعليمية والرؤى حول DS و ML و LLMs و RAGs.

4 أغسطس، 14:33

تقنية بسيطة تجعل ذاكرة RAG ~ 32x فعالة!

- يستخدمه Perplexity في فهرس البحث الخاص به

- يستخدمه Azure في مسار البحث الخاص به

- تستخدمه HubSpot في مساعد الذكاء الاصطناعي الخاص بها

دعنا نفهم كيفية استخدامه في أنظمة RAG (مع الكود):

695.78K

الأفضل

المُتصدِّرة

التطبيقات المفضلة