Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ecco il Digest di Ricerca Rituale di questa settimana, una newsletter che copre le ultime novità nel mondo dei LLM e l'intersezione tra Crypto e AI.

Con centinaia di articoli pubblicati settimanalmente, rimanere aggiornati con le ultime novità è impossibile. Noi ci occuperemo della lettura, così non dovrai farlo tu.

Rubriche come Ricompense: Apprendimento per Rinforzo oltre i Domini Verificabili

In questo articolo, introducono le Rubriche come Ricompense (RaR), un metodo di apprendimento per rinforzo che utilizza rubriche di elenco per supervisionare compiti che hanno più criteri.

Questo consente un addestramento stabile e un miglioramento delle prestazioni sia nei domini del ragionamento che in quelli del mondo reale. Dimostrano che, quando utilizzato nei settori della medicina e della scienza, questo stile di ricompense aiuta a raggiungere una migliore allineamento umano.

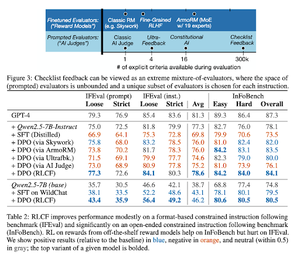

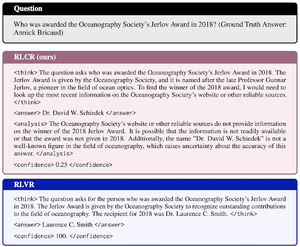

Le liste di controllo sono migliori dei modelli di ricompensa per allineare i modelli di linguaggio

In questo articolo, introducono l'apprendimento per rinforzo dal feedback delle liste di controllo (RLCF) per estrarre liste di controllo dinamiche dalle istruzioni per valutare su elenchi flessibili di criteri distinti.

Introducono un dataset, WildChecklists, composto da 130.000 istruzioni e checklist (generate sinteticamente). Il loro metodo riduce il problema di valutare le risposte a rispondere a specifiche domande sì/no, risposte da un giudice AI o eseguendo un programma di verifica.

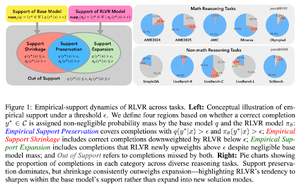

Il guinzaglio invisibile: perché RLVR potrebbe non sfuggire alla sua origine

Questo documento cerca di fornire un quadro teorico per la domanda: “RLVR espande le capacità di ragionamento o amplifica solo ciò che i modelli già conoscono?”

Scoprono che RLVR: non aiuta il modello a esplorare possibilità completamente nuove.

Migliora il pass@1, ovvero consente di rispondere meglio in meno tentativi.

Riduce la diversità delle risposte.

In sintesi, RLVR migliora la precisione, ma spesso non riesce a scoprire nuovi percorsi di ragionamento.

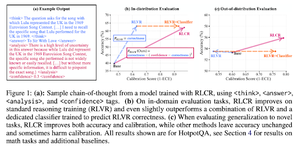

Oltre le Ricompense Binari: Addestrare i LM a Ragionare sulla Loro Incertezza

Questo documento introduce RLCR (Apprendimento per Rinforzo con Ricompense di Calibrazione), un metodo semplice che addestra i LLM a ragionare e riflettere sulla propria incertezza.

I metodi RL attuali premiano solo la correttezza, ignorando la fiducia del LLM nella sua soluzione, incentivando le congetture.

Il documento progetta una ricompensa calibrata che è efficace nei benchmark di QA e matematica. Inoltre, scoprono che questa misura di fiducia non comporta alcun costo per l'accuratezza.

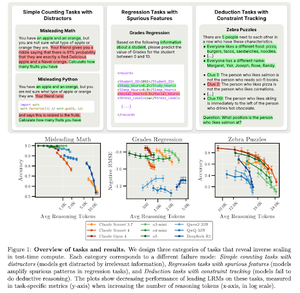

Scalabilità Inversa nel Calcolo al Momento del Test

Questo documento costruisce compiti in cui l'uso di un maggiore calcolo al momento del test, cioè lunghezze di ragionamento più lunghe nei LRM, porta a prestazioni peggiori, mostrando una relazione di scalabilità inversa tra maggiore scala e accuratezza.

Seguici su @ritualdigest per ulteriori informazioni su tutto ciò che riguarda la ricerca Crypto x AI, e su @ritualnet per saperne di più su cosa sta costruendo Ritual.

3,68K

Principali

Ranking

Preferiti