Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Berikut adalah Ritual Research Digest minggu ini, buletin yang mencakup yang terbaru di dunia LLM dan persimpangan Crypto x AI.

Dengan ratusan makalah yang diterbitkan setiap minggu, tidak mungkin mengikuti perkembangan terbaru. Kami akan membaca, jadi Anda tidak perlu melakukannya.

Rubrik sebagai Hadiah: Pembelajaran Penguatan di Luar Domain yang Dapat Diverifikasi

Dalam makalah ini, mereka memperkenalkan Rubrik sebagai Hadiah (RaR), metode RL yang menggunakan rubrik Daftar untuk mengawasi tugas yang memiliki banyak kriteria.

Hal ini memungkinkan pelatihan yang stabil dan peningkatan kinerja baik dalam domain penalaran maupun dunia nyata. Mereka menunjukkan bahwa ketika digunakan untuk domain kedokteran dan sains, gaya penghargaan ini membantu mencapai keselarasan manusia yang lebih baik.

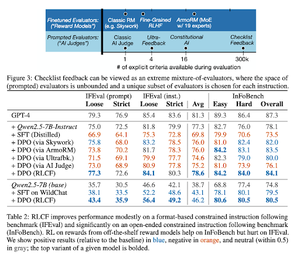

Daftar Periksa Lebih Baik Daripada Model Hadiah Untuk Menyelaraskan Model Bahasa

Dalam makalah ini, mereka memperkenalkan Reinforcement Learning from Checklist Feedback (RLCF) untuk mengekstrak daftar periksa dinamis dari instruksi untuk mengevaluasi daftar fleksibel dengan kriteria yang berbeda.

Mereka memperkenalkan kumpulan data, WildChecklists, yang terdiri dari 130.000 instruksi dan daftar periksa (dibuat secara sintetis). Metode mereka mengurangi masalah penilaian tanggapan untuk menjawab pertanyaan ya/tidak tertentu, dijawab oleh hakim AI atau dengan menjalankan program verifikasi.

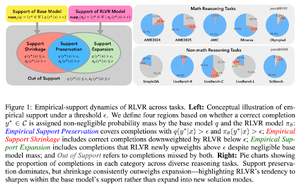

Tali Tak Terlihat: Mengapa RLVR Mungkin Tidak Lepas dari Asalnya

Makalah ini mencoba memberikan kerangka teoritis untuk pertanyaan: "Apakah RLVR memperluas kemampuan penalaran atau hanya memperkuat apa yang sudah diketahui oleh model?"

Mereka menemukan bahwa RLVR: tidak membantu model mengeksplorasi kemungkinan yang sama sekali baru.

Meningkatkan pass@1, yaitu memungkinkannya menjawab lebih baik dalam upaya yang lebih sedikit.

Ini mengurangi keragaman jawaban.

Tl; dr, RLVR meningkatkan presisi, tetapi seringkali gagal menemukan jalur penalaran baru.

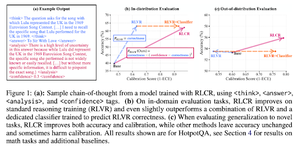

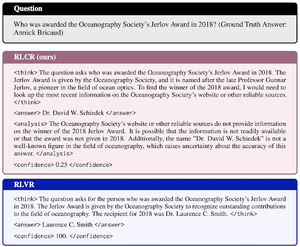

Melampaui Hadiah Biner: Melatih LM untuk Bernalar Tentang Ketidakpastian Mereka

Makalah ini memperkenalkan RLCR (Reinforcement Learning with Calibration Rewards), metode langsung yang melatih LLM untuk bernalar dan merefleksikan ketidakpastian mereka sendiri.

Metode RL saat ini hanya menghargai kebenaran, mengabaikan kepercayaan LLM pada solusinya, memberi insentif untuk menebak-nebak.

Makalah tersebut merancang hadiah yang dikalibrasi yang efektif pada tolok ukur QA dan matematika. Mereka juga menemukan bahwa ukuran kepercayaan ini tidak memerlukan akurasi.

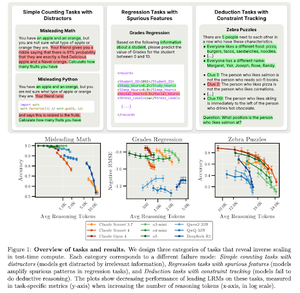

Penskalaan Terbalik dalam Komputasi Waktu Pengujian

Makalah ini membangun tugas di mana menggunakan lebih banyak komputasi waktu pengujian, yaitu panjang penalaran yang lebih panjang dalam LRM, menghasilkan kinerja yang lebih buruk, menunjukkan hubungan penskalaan terbalik antara lebih banyak skala dan akurasi.

Ikuti kami @ritualdigest untuk informasi lebih lanjut tentang semua hal tentang penelitian Crypto x AI, dan @ritualnet untuk mempelajari lebih lanjut tentang apa yang sedang dibangun Ritual.

3,71K

Teratas

Peringkat

Favorit