Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Här är veckans Ritual Research Digest, ett nyhetsbrev som täcker det senaste i LLM-världen och skärningspunkten mellan Crypto x AI.

Med hundratals artiklar som publiceras varje vecka är det omöjligt att hålla sig uppdaterad med det senaste. Vi gör avläsningen, så att du inte behöver göra det.

Kriterier som belöningar: Förstärkningsinlärning bortom verifierbara domäner

I det här dokumentet introducerar de rubriker som belöningar (RaR), en RL-metod som använder listrubriker för att övervaka uppgifter som har flera kriterier.

Detta möjliggör stabil träning och förbättrad prestanda i både resonemang och verkliga domäner. De visar att när den används för medicinska och vetenskapliga domäner, hjälper denna typ av belöningar till att uppnå bättre mänsklig anpassning.

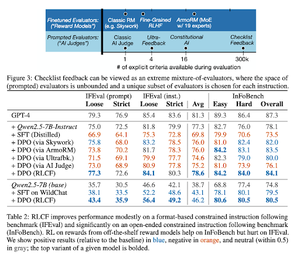

Checklistor är bättre än belöningsmodeller för att anpassa språkmodeller

I det här dokumentet introducerar de Reinforcement Learning from Checklist Feedback (RLCF) för att extrahera dynamiska checklistor från instruktioner för att utvärdera på flexibla listor med distinkta kriterier.

De introducerar ett dataset, WildChecklists, som består av 130 000 instruktioner och checklistor (syntetiskt genererade). Deras metod minskar problemet med att betygsätta svaren till att svara på specifika ja/nej-frågor, besvarade av en AI-domare eller genom att köra ett verifieringsprogram.

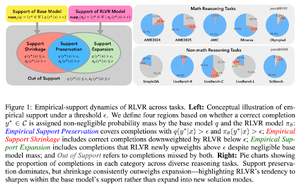

Det osynliga kopplet: Varför RLVR kanske inte kommer undan sitt ursprung

Denna uppsats försöker ge ett teoretiskt ramverk för frågan: "Utökar RLVR resonemangsförmågan eller förstärker den bara det som modellerna redan vet?"

De finner att RLVR: inte hjälper modellen att utforska helt nya möjligheter.

Förbättrar pass@1, d.v.s. gör att den kan svara bättre på färre försök.

Det minskar mångfalden av svar.

Tl; dr förbättrar RLVR precisionen, men misslyckas ofta med att upptäcka nya resonemangsvägar.

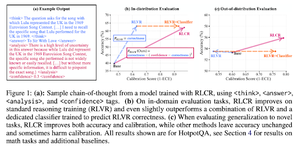

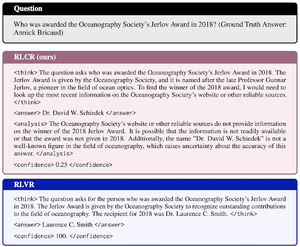

Bortom binära belöningar: Träna LM:er att resonera om sin osäkerhet

Denna uppsats introducerar RLCR (Reinforcement Learning with Calibration Rewards), en enkel metod som tränar LLM:er att resonera och reflektera över sin egen osäkerhet.

Nuvarande RL-metoder belönar endast korrekthet och ignorerar LLM:s förtroende för sin lösning, vilket uppmuntrar till gissningar.

Uppsatsen utformar en kalibrerad belöning som är effektiv på QA och matematiska riktmärken. De finner också att detta konfidensmått inte påverkar noggrannheten.

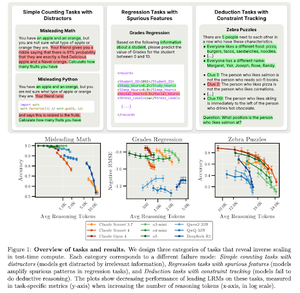

Omvänd skalning i beräkning vid test

Denna uppsats konstruerar uppgifter där användning av mer testtidsberäkning, dvs. längre resonemangslängder i LRM:er, resulterar i sämre prestanda, uppvisar ett omvänt skalningsförhållande mellan mer skala och noggrannhet.

Följ oss @ritualdigest för mer information om allt som rör forskning om Crypto x AI och @ritualnet för att lära dig mer om vad Ritual bygger.

3,72K

Topp

Rankning

Favoriter