Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Scopri le architetture GPU @nvidia 🐰 Hopper vs ⚙️ Blackwell—salti successivi nella potenza di calcolo e nelle interconnessioni per i tuoi carichi di lavoro AI👇

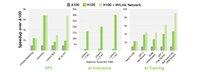

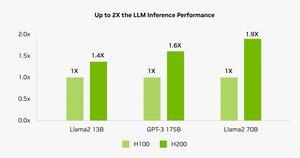

🐰 Hopper (H100 e H200) ha introdotto i Tensor Cores di quarta generazione + un FP8 Transformer Engine, offrendo fino a 9× di velocità di addestramento e 30× di velocità di inferenza rispetto all'A100.

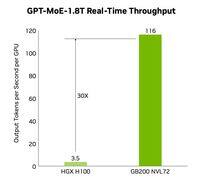

⚙️ Blackwell (B200)—in spedizione a fine 2024—accoppia due chip su un NV-HBI da 10 TB/s, aggiunge FP4 e utilizza NVLink-5 per fino a 30× di inferenza in cluster.

@nvidia 🐰 Specifiche Hopper

Core Tensor: misti FP8/FP16/TF32

Memoria:

- H100 → 80 GB HBM3 @ 3.35 TB/s

- H200 → 141 GB HBM3e @ 4.8 TB/s

NVLink: fino a 900 GB/s per GPU

🐰 @nvidia Hopper in azione

I benchmark mostrano che l'H200 alimenta l'inferenza Llama-2 70B il 45-100% più velocemente rispetto all'H100.

⚠️ Entrambi hanno registrato una crisi dell'offerta nel 2023-25.

💻 Sul cloud di Hyperbolic: VM H100 e cluster bare-metal con Ethernet + InfiniBand a partire da $ 1,49/ora. H200 e B200 tramite quotazione immediata.

⚙️ @nvidia Innovazioni Blackwell

- Design chiplet (TSMC 4NP, transistor 208 B, NVI-BBI da 10 TB/s)

- Motore trasformatore di 2a generazione: FP4 + FP8 migliorato

- NVLink-5: 18 collegamenti @ 1,8 TB/s totali

- Motore di decompressione: CPU↔GPU da 800 GB/s

- RAS completo e calcolo riservato

📊 Confronto delle prestazioni

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, stessi PFLOPS/TFLOPS di calcolo, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7,7 TB/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 TB/s, 1000 W

❓ @nvidia Cos'è un FLOP?

1 operazione a virgola mobile (ADD/MUL)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× un TFLOP

Queste metriche mostrano la velocità con cui le GPU elaborano l'enorme matematica alla base dell'addestramento dell'intelligenza artificiale e dell'HPC.

🔚 @nvidia Conclusione:

🐰 Hopper ha impostato l'asticella con le pipeline asincrone e a precisione mista FP8.

⚙️ Blackwell spinge la next-gen con FP4, più memoria, NVLink-5.

H100 rimane il cavallo di battaglia: l'affitto avviene a $ 1,49 / ora.

H200 e B200 disponibili su richiesta tramite

@nvidia Leggi l'articolo completo su:

7,04K

Principali

Ranking

Preferiti