熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

深入了解 @nvidia 🐰 Hopper 與 ⚙️ Blackwell GPU 架構——在計算能力和互連方面的連續飛躍,為您的 AI 工作負載提供支持👇

🐰 Hopper (H100 和 H200) 引入了第四代 Tensor Cores 和 FP8 Transformer Engine,訓練速度提高至 9 倍,推理速度提高至 30 倍,相較於 A100。

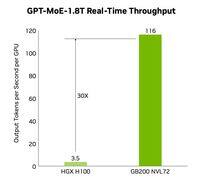

⚙️ Blackwell (B200)—預計於 2024 年底發貨—將兩個晶片配對在 10 TB/s 的 NV-HBI 上,增加了 FP4,並使用 NVLink-5 以實現高達 30 倍的集群推理。

@nvidia 🐰 Hopper 規格

張量核心:混合 FP8/FP16/TF32

記憶體:

- H100 → 80 GB HBM3 @ 3.35 TB/s

- H200 → 141 GB HBM3e @ 4.8 TB/s

NVLink:每個 GPU 高達 900 GB/s

@nvidia 🐰 Hopper 在運作

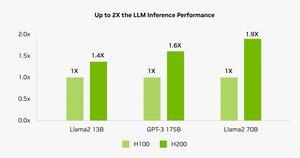

基準測試顯示,H200 為 Llama-2 70B 推理提供動力,比 H100 快 45-100%。

⚠️ 兩者都在 2023-25 年出現供應緊縮。

💻 在 Hyperbolic 的雲上:H100 虛擬機和裸機集群,帶以太網 + InfiniBand 起價為 1.49 美元/小時。H200 和 B200 通過即時報價。

@nvidia ⚙️ Blackwell 創新

- 小晶片設計(台積電 4NP、208 B 電晶體、10 TB/s NV-HBI)

- 第二代變形金剛引擎:FP4 + 增強型 FP8

- NVLink-5:18 個鏈接 @ 總計 1.8 TB/s

- 解壓縮引擎:800 GB/s CPU↔GPU

- 完整的 RAS 和機密計算

📊 性能比較

H100 SXM: 80 GB @ 3.35 TB/s, 3.96 PFLOPS (FP8), 1.98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4.8 TB/s, 相同的計算 PFLOPS/TFLOPS, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7.7 TB/s, 9 PFLOPS (FP8), 4.5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1.8 TB/s, 1000 W

@nvidia ❓ 什麼是翻牌?

1 個浮點運算 (add/mul)

1 TFLOP = 10¹² 操作/秒

1 PFLOP = 10¹⁵ ops/s = 1000×一個 TFLOP

這些指標顯示了 GPU 處理 AI 訓練和 HPC 背後的大量數學運算的速度。

@nvidia 🔚 包起來:

🐰 Hopper 以 FP8 混合精度和非同步管道樹立了標準。

⚙️ Blackwell 通過 FP4、更多內存、NVLink-5 推動下一代產品。

H100 仍然是主力——租金為 1.49 美元/小時。

H200 和 B200 可通過以下方式應要求提供

@nvidia 閱讀完整文章:

7.04K

熱門

排行

收藏