トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

@nvidia 🐰 Hopper と ⚙️ Blackwell の GPU アーキテクチャの詳細 - AI ワークロード👇のコンピューティング能力と相互接続の連続的な飛躍

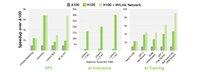

🐰 Hopper (H100 & H200) は、第 4 世代 Tensor コア + FP8 Transformer エンジンを導入し、A100 と比較して最大 9× 高速なトレーニングと 30× 高速な推論を実現しました。

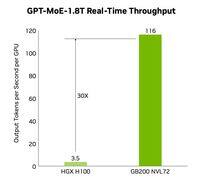

⚙️ Blackwell (B200) (2024 年後半に出荷予定) は、10 TB/秒の NV-HBI 上で 2 つのダイをペアにし、FP4 を追加し、NVLink-5 を使用して最大 30× のクラスター推論を実現します。

@nvidia🐰ホッパーの仕様

テンソルコア:混合FP8 / FP16 / TF32

記憶:

- H100 → 80 GB HBM3 @ 3.35 TB/秒

- H200 → 141 GB HBM3e @ 4.8 TB/秒

NVLink:GPUあたり最大900GB/秒

@nvidia 🐰 ホッパーの動作

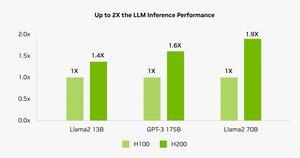

ベンチマークでは、H200 が Llama-2 70B 推論を強化し、H100 と比較して 45-100% 高速であることが示されています。

⚠️ どちらも2023-25年に供給逼迫に見舞われた。

💻 Hyperbolic のクラウドの場合: イーサネット + InfiniBand を備えた H100 VM およびベアメタル クラスターは 1.49 ドル/時間から。H200 および B200 は即時見積もりで。

@nvidia ⚙️ ブラックウェル・イノベーション

- チップレット設計 (TSMC 4NP、208 B トランジスタ、10 TB/s NV-HBI)

- 第2世代トランスフォーマーエンジン:FP4+強化FP8

- NVLink-5: 18 リンク @ 合計 1.8 TB/秒

- 解凍エンジン: 800 GB/s CPU↔GPU

- 完全な RAS と機密コンピューティング

📊 パフォーマンスの比較

H100 SXM:80 GB @ 3.35 TB/秒、3.96 PFLOPS(FP8)、1.98 PFLOPS(FP16)、67 TFLOPS(FP32)、NVLink 900 GB/秒、700 W

H200 SXM:141 GB @ 4.8 TB/秒、同じコンピューティング PFLOPS/TFLOPS、NVLink 900 GB/秒、700 W

HGX B200: 180 GB @ 7.7 TB/秒、9 PFLOPS (FP8)、4.5 PFLOPS (FP16)、75 TFLOPS (FP32)、NVLink 1.8 TB/秒、1000 W

@nvidia ❓ フロップとは何ですか?

1 浮動小数点演算 (add/mul)

1 TFLOP = 10¹² 動作/秒

1 PFLOP = 10¹⁵ ops/s = 1000× TFLOP

これらの指標は、GPU が AI トレーニングと HPC の背後にある膨大な数学をどれだけ速く処理するかを示しています。

@nvidia 🔚 まとめ:

🐰 Hopper は、FP8 混合精度および非同期パイプラインで基準を設定しました。

⚙️ Blackwell は、FP4、より多くのメモリ、NVLink-5 で次世代を推進します。

H100 は依然として主力製品であり、1 時間あたり 1.49 ドルでレンタルできます。

H200 & B200はご要望に応じてご利用いただけます。

@nvidia 記事全文は以下でお読みください。

7.05K

トップ

ランキング

お気に入り