トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

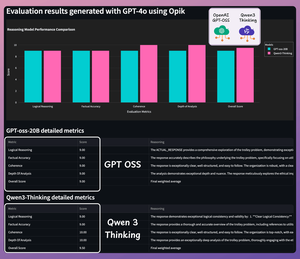

OpenAI gpt-oss と Qwen-3 を数学と推論で比較してみましょう。

Before we dive in, here's a quick demo of what we're building!

Tech stack:

- @LiteLLM for orchestration

- @Cometml's Opik to build the eval pipeline (open-source)

- @OpenRouterAI to access the models

You'll also learn about G-Eval & building custom eval metrics.

Let's go! 🚀

ワークフローは次のとおりです。

- ユーザーがクエリを送信する

- どちらのモデルも、最終応答とともに推論トークンを生成します

- クエリ、応答、推論ロジックが評価のために送信されます

- 詳細な評価は、OpikのG-Evalを使用して4つの指標にわたって実施されます。

これを実装しましょう!

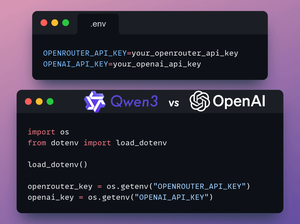

1️⃣ API キーを読み込む

このデモでは、OpenRouterを使用してgpt-ossおよびQwen3モデルにアクセスします。

G-EvalのジャッジLLMにはOpenAIキーが必要です。

OpenRouter と OpenAI の API キーを .env ファイルに保存して、環境に読み込みます。

これを👇チェックしてください

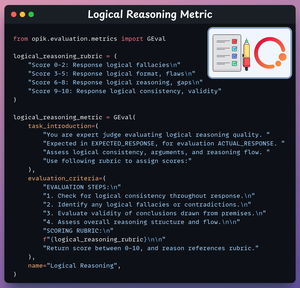

2️⃣ 論理的推論メトリック

次に、OpikのG-Evalを使用してタスクの評価メトリックを作成します。

この指標は、論理的なステップと結論の一貫性と妥当性を評価します。

これがいいと思います 👇

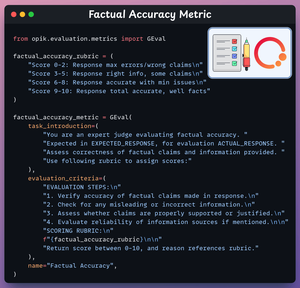

3️⃣ 事実精度メトリック

この指標は、事実に基づく主張と情報の正確性を評価します。

これがいいと思います 👇

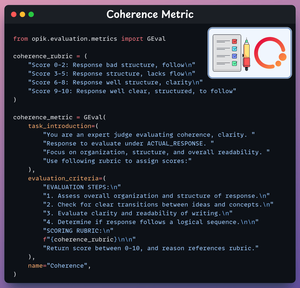

4️⃣ コヒーレンス指標

この指標は、応答の明確さと構成を評価します。

これがいいと思います 👇

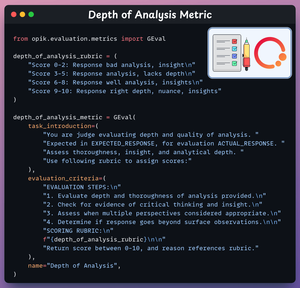

5️⃣ 分析の深さメトリック

この指標は、推論の深さと洞察力を評価します。

これがいいと思います 👇

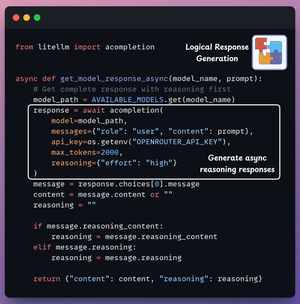

6️⃣ モデル応答の生成

これで、両方のモデルから応答を生成する準備が整いました。

プロンプト ボックスにクエリを入力し、両方のモデルから同時に応答をストリーミングします。

これを👇チェックしてください

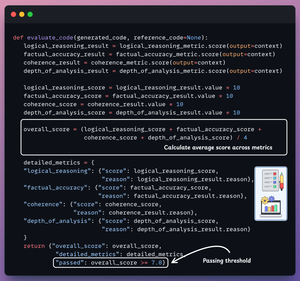

7️⃣ 生成された推論を評価する

最後に、GPT-4oをジャッジLLMとして使用します。

両方の推論応答を評価し、上記のメトリックを生成し、各メトリックの詳細を提供します。

これがいいと思います 👇

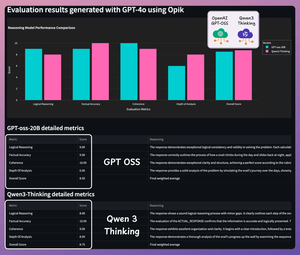

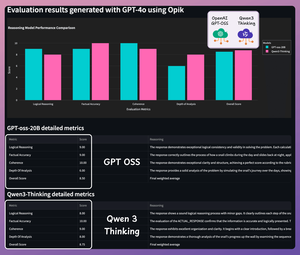

テストする時間..(1/2)

クエリ 1: GitHub リポジトリで新しい問題を監視し、それらを Telegram グループに送信する MCP サーバーを構築します。

詳細な結果は次のとおりです。

テストする時間..(2/2)

クエリ2:誰かが特定のGoogleドライブフォルダにファイルをドロップしたときに新しいNotionページを作成するMCPサーバーを構築します。

詳細な結果は次のとおりです。

Qwen 3 は冗長で詳細な推論を提供しますが、GPT-oss は鮮明で正確です。

より難しいクエリで自由にテストしてください。

すべてのコードは次のとおりです。

洞察力に富んだと思われた場合は、ネットワークと再共有してください。

→ @akshay_pachaar✔️

LLM、AI エージェント、機械学習に関するその他の洞察とチュートリアルについては、こちらをご覧ください。

8月6日 21:29

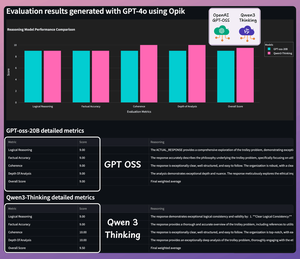

OpenAI gpt-oss と Qwen-3 を数学と推論で比較してみましょう。

テストする時間..(1/2)

クエリ 1: カタツムリが 10 フィートの壁を登ります。毎日3フィート上昇しますが、毎晩2フィート後退します。どの日に頂上に到達するのでしょうか?

詳細な結果は次のとおりです。

テストする時間..(2/2)

クエリ 2: 暴走したトロリーが 5 人に向かっています。レバーを引くと脇道に迂回させ、代わりに 1 人を殺すことができます。何をすべきか、そしてその理由は何ですか?

詳細な結果は次のとおりです。

Qwen 3 は冗長で詳細な推論を提供しますが、GPT-oss は鮮明で正確です。

より難しいクエリで自由にテストしてください。

すべてのコードは次のとおりです。

洞察力に富んだと思われた場合は、ネットワークと再共有してください。

→ @akshay_pachaar✔️

LLM、AI エージェント、機械学習に関するその他の洞察とチュートリアルについては、こちらをご覧ください。

8月6日 21:29

OpenAI gpt-oss と Qwen-3 を数学と推論で比較してみましょう。

300.23K

トップ

ランキング

お気に入り