Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

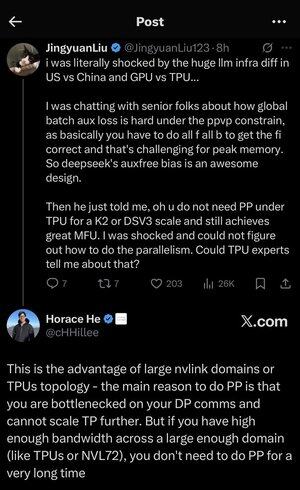

Fiquei um pouco perdido em todos os acrônimos e jargões aqui, então pedi ao Claude para explicar sem usar nenhum acrônimo e agora tudo faz perfeito sentido (resumindo; largura de banda ⟹ simplicidade):

Esta é uma discussão técnica fascinante sobre o treinamento de grandes modelos de linguagem em escala.

A Conversa Principal

Jingyuan Liu expressa surpresa ao descobrir que não é necessário usar certas técnicas de otimização complexas ao usar TPUs (Unidades de Processamento de Tensores - os chips de IA especializados do Google) em comparação com GPUs (Unidades de Processamento Gráfico - tipicamente chips da NVIDIA).

Conceitos Técnicos Chave Explicados:

Tipos de Hardware:

•GPU (Unidade de Processamento Gráfico): Originalmente projetada para gráficos, agora amplamente utilizada para IA. A NVIDIA domina este mercado.

•TPU (Unidade de Processamento de Tensores): Chips projetados sob medida pelo Google especificamente para aprendizado de máquina.

Estratégias de Paralelismo:

Ao treinar modelos de IA massivos, você precisa dividir o trabalho entre muitos chips. Existem várias maneiras de fazer isso:

1) Paralelismo de Dados (DP): Cada chip processa diferentes lotes de dados com a mesma cópia do modelo

2) Paralelismo de Tensores (TP): As operações matemáticas do modelo são divididas entre os chips

3) Paralelismo em Pipeline (PP): Diferentes camadas do modelo são colocadas em diferentes chips, criando um pipeline

O Desafio Técnico Sendo Discutido:

O problema da perda auxiliar: Ao treinar modelos muito grandes, você frequentemente adiciona "perdas auxiliares" (objetivos de treinamento adicionais) em camadas intermediárias para ajudar os gradientes a fluir melhor pela rede. Sob as restrições do PPVP (Paralelismo em Pipeline com Particionamento Variável), isso se torna complexo porque:

•Você precisa fazer "tudo f tudo b" (todas as passagens para frente, depois todas as passagens para trás)

•Isso é desafiador para o uso máximo de memória porque você precisa armazenar resultados intermediários

A inovação da DeepSeek: Eles desenvolveram um design de "viés sem auxiliar" que aparentemente evita a necessidade dessas perdas auxiliares enquanto ainda treina de forma eficaz.

A Revelação Surpreendente:

O especialista sênior disse a Jingyuan que com TPUs em escala K2 ou DSV3 (essas são configurações de cluster com centenas ou milhares de chips), você pode alcançar uma excelente MFU (Utilização de FLOPs do Modelo - basicamente quão eficientemente você está usando o hardware) SEM usar Paralelismo em Pipeline.

Por que isso é surpreendente?

•O Paralelismo em Pipeline é tipicamente considerado essencial para treinamento em larga escala

•É uma técnica complexa que requer otimização cuidadosa

•Ser capaz de evitá-lo simplifica tudo significativamente

A Explicação de Horace He:

Ele explica POR QUE isso é possível com TPUs:

A vantagem da largura de banda: TPUs e clusters NVIDIA de alto desempenho (como NVL72 - a última configuração de 72 GPUs da NVIDIA com interconexões NVLink) têm uma largura de banda tão alta entre os chips que podem lidar com os requisitos de comunicação sem Paralelismo em Pipeline.

A chave insight:

•O Paralelismo em Pipeline é principalmente necessário quando você está "estrangulado nas comunicações de DP" (limitado pela rapidez com que você pode se comunicar durante o treinamento paralelo de dados)

•Se você tiver largura de banda suficiente em um domínio grande o suficiente (cluster interconectado), pode usar apenas estratégias de paralelismo mais simples

•Isso funciona "por um longo tempo" - o que significa que você pode treinar até mesmo modelos muito grandes sem atingir os limites

A Intuição:

Pense nisso como um sistema rodoviário:

•Clusters de GPU tradicionais são como ter estradas estreitas entre cidades, então você precisa de roteamento complexo (Paralelismo em Pipeline) para evitar engarrafamentos

•Clusters de TPU ou GPUs conectadas por NVLink são como ter superestradas enormes - você pode simplesmente enviar tudo diretamente sem roteamento sofisticado

Isso é um grande problema porque o Paralelismo em Pipeline é complexo de implementar, depurar e otimizar. Ser capaz de evitá-lo enquanto ainda alcança alta eficiência torna todo o processo de treinamento muito mais simples e confiável.

A discussão destaca como os avanços na tecnologia de interconexão de hardware (as "estradas" entre os chips) podem mudar fundamentalmente as estratégias de software necessárias para um treinamento de IA eficiente.

24,36K

Top

Classificação

Favoritos