Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eksyin hieman kaikkiin lyhenteisiin ja jargoniin, joten pyysin Claudea selittämään sen ilman lyhenteitä, ja nyt kaikki on täysin järkevää (tldr; kaistanleveys ⟹ yksinkertaisuus):

Tämä on kiehtova tekninen keskustelu suurten kielimallien kouluttamisesta mittakaavassa.

Keskustelun ydin

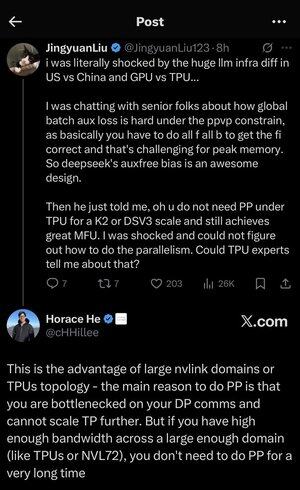

Jingyuan Liu ilmaisee yllätyksensä huomatessaan, että et tarvitse tiettyjä monimutkaisia optimointitekniikoita, kun käytät TPU:ita (Tensor Processing Units - Googlen erikoistuneet AI-sirut) verrattuna GPU:ihin (Graphics Processing Units - tyypillisesti NVIDIAn siruihin).

Keskeiset tekniset käsitteet selitettynä:

Laitteistotyypit:

•GPU (Graphics Processing Unit): Alun perin suunniteltu grafiikkaa varten, nyt käytetään paljon tekoälyssä. NVIDIA hallitsee näitä markkinoita.

•TPU (Tensor Processing Unit): Googlen räätälöidyt sirut erityisesti koneoppimiseen.

Rinnakkaisuusstrategiat:

Kun harjoitat massiivisia tekoälymalleja, sinun on jaettava työ useille siruille. On olemassa useita tapoja tehdä tämä:

1) Tietojen rinnakkaisuus (DP): Jokainen siru käsittelee eri tietoeriä samalla mallikopiolla

2) Tensorin rinnakkaisuus (TP): Mallin matemaattiset operaatiot on jaettu sirujen kesken

3) Putkilinjan rinnakkaisuus (PP): Mallin eri kerrokset sijoitetaan eri siruille, mikä luo putkilinjan

Tekninen haaste, josta keskustellaan:

Apuhäviöongelma: Kun harjoitat erittäin suuria malleja, lisäät usein "apuhäviöitä" (ylimääräisiä harjoitustavoitteita) välikerroksiin, jotta gradientit virtaavat paremmin verkon läpi. PPVP (Pipeline Parallelism with Variable Partitioning) -rajoituksissa tästä tulee monimutkaista, koska:

•Sinun on tehtävä "kaikki f kaikki b" (kaikki syötöt eteen, sitten kaikki taaksepäin)

•Tämä on haastavaa muistin huippukäytön kannalta, koska välitulokset on tallennettava

DeepSeekin innovaatio: He kehittivät "auxfree bias" -mallin, joka ilmeisesti välttää näiden apuhäviöiden tarpeen samalla kun harjoittelee tehokkaasti.

Yllättävä paljastus:

Vanhempi asiantuntija kertoi Jingyuanille, että K2- tai DSV3-mittakaavan TPU:illa (nämä ovat klusterikokoonpanoja, joissa on satoja tai tuhansia siruja) voit saavuttaa erinomaisen MFU:n (Model FLOPs Utilization - periaatteessa kuinka tehokkaasti käytät laitteistoa) ILMAN putkilinjan rinnakkaisuutta.

Miksi tämä on yllättävää?

•Putkilinjan rinnakkaisuutta pidetään yleensä välttämättömänä laajamittaisessa koulutuksessa

•Se on monimutkainen tekniikka, joka vaatii huolellista optimointia

•Sen välttäminen yksinkertaistaa kaikkea merkittävästi

Horace He:n selitys:

Hän selittää, MIKSI tämä on mahdollista TPU:illa:

Kaistanleveyden etu: TPU:illa ja huippuluokan NVIDIA-klustereilla (kuten NVL72 - NVIDIAn uusin 72 GPU:n kokoonpano NVLink-liitännöillä) on niin suuri kaistanleveys sirujen välillä, että ne pystyvät käsittelemään tiedonsiirtovaatimukset ilman putkilinjan rinnakkaisuutta.

Keskeinen oivallus:

•Putken rinnakkaisuutta tarvitaan ensisijaisesti silloin, kun DP-viestintä on pullonkaulassa (sitä rajoittaa se, kuinka nopeasti voit kommunikoida tietojen rinnakkaiskoulutuksen aikana)

•Jos sinulla on tarpeeksi kaistanleveyttä riittävän suurella toimialueella (yhdistetty klusteri), voit käyttää yksinkertaisempia rinnakkaisuusstrategioita

• Tämä toimii "erittäin pitkään" - mikä tarkoittaa, että voit kouluttaa jopa erittäin suuria malleja osumatta rajoihin

Intuitio:

Ajattele sitä kuin moottoritiejärjestelmää:

•Perinteiset GPU-klusterit ovat kuin kapeita teitä kaupunkien välillä, joten tarvitset monimutkaisen reitityksen (putkilinjan rinnakkaisuus) liikenneruuhkien välttämiseksi

• TPU-klusterit tai NVLink-yhdistetyt GPU:t ovat kuin massiivisia valtateitä – voit lähettää kaiken suoraan ilman hienoa reititystä

Tämä on iso juttu, koska Pipeline Parallelism on monimutkainen toteuttaa, korjata ja optimoida. Sen välttäminen ja samalla korkean tehokkuuden saavuttaminen tekee koko koulutusprosessista paljon yksinkertaisemman ja luotettavamman.

Keskustelussa korostetaan, kuinka laitteistojen yhteenliittämistekniikan (sirujen väliset "tiet") kehitys voi muuttaa perusteellisesti tehokkaaseen tekoälykoulutukseen tarvittavia ohjelmistostrategioita.

24,36K

Johtavat

Rankkaus

Suosikit