Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

категорично схвалюється. Наші моделі вчаться сміття, і я думаю, що це не просто фіксований податок на продуктивність – він додає поверхневості, небажане запам'ятовування та «гострі сингулярності», які, ймовірно, зростають із масштабом. Цікаво, як різні методи розрідженості сприяють виникненню проблеми.

7 серп., 22:06

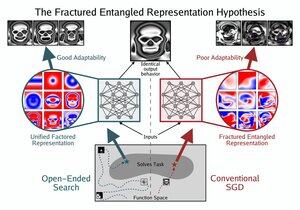

Ті, хто відчуває, що чогось не вистачає в LLM, намагаються визначити розрив за межами неадекватних метафор на кшталт «стохастичний папуга» або «прославлений автоповний». Те, що ви шукаєте, — це переломлене заплутане представлення (FER). У цьому і полягає конкретна суть вашої слизької інтуїції.

Ось чому ці моделі можуть продовжувати вдосконалюватися драматичними та справді нетривіальними способами, але все ще страждати від основної хвороби. Саме тут криються реальні можливості та надії на революційний прогрес,

Уявлення лежить в основі думки, творчості і взагалі самого інтелекту. Можна «знати» незбагненну суму і при цьому все одно представляти її погано.

І цілком можливо, що представництво буде кращим. І це в кінцевому підсумку так чи інакше станеться.

4K

Найкращі

Рейтинг

Вибране