热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

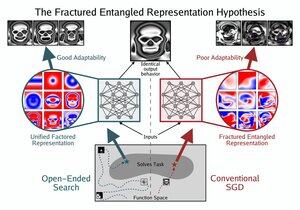

强烈支持。我们的模型正在学习垃圾,我认为这不仅仅是一个平坦的性能税——它增加了表面性、不良的记忆和可能随着规模增加的“尖峰奇点”。我想知道不同的稀疏方法如何对这个问题产生影响。

20 小时前

那些直觉上感觉LLM(大型语言模型)存在缺陷的人,难以准确指出这种缺陷,除了像“随机鹦鹉”或“美化的自动补全”这样的不足隐喻。你们所摸索的,是破碎的纠缠表示(FER)。这正是你们模糊直觉的具体核心。

这就是为什么这些模型能够以戏剧性和真正非平凡的方式不断改进,但仍然遭受潜在的病态。这是革命性进步的真正机会和希望所在。

表示是思想、创造力,甚至是智力本身的核心。即使能够“知道”难以理解的庞大信息,仍然可能表现得很糟糕。

而且,表示是可以更好的。最终,这种情况无论如何都会发生。

3.02K

热门

排行

收藏