Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tim Dettmers

Użytkownik Tim Dettmers udostępnił ponownie

Przedstawiamy DeepConf: Głębokie Myślenie z Pewnością

🚀 Pierwsza metoda osiągnięcia 99,9% na AIME 2025 z modelami open-source! Używając GPT-OSS-120B, nawet bez narzędzi, osiągnęliśmy tę niemal doskonałą dokładność, oszczędzając do 85% generowanych tokenów.

Oferuje również wiele silnych zalet dla myślenia równoległego:

🔥 Wzrost wydajności: ~10% dokładności w różnych modelach i zbiorach danych

⚡ Ultraefektywność: Do 85% mniej generowanych tokenów

🔧 Plug & play: Działa z DOWOLNYM istniejącym modelem - zero szkolenia potrzebne (bez dostrajania hiperparametrów!)

⭐ Łatwe wdrożenie: Tylko ~50 linii kodu w vLLM (zobacz PR poniżej)

📚 Artykuł:

🌐 Projekt:

wspólna praca z: @FuYichao123, xuewei_wang, @tydsh

(zobacz szczegóły w komentarzach poniżej)

408,69K

Użytkownik Tim Dettmers udostępnił ponownie

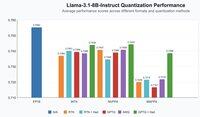

Czy możemy przełamać barierę pamięci dla wnioskowania LLM poprzez rematerializację pamięci podręcznej KV?

🚨 Przedstawiamy XQuant, który wykorzystuje niedostatecznie wykorzystywane jednostki obliczeniowe, aby wyeliminować wąskie gardło pamięci dla wnioskowania LLM!

• 10–12,5x oszczędności pamięci w porównaniu do FP16

• Prawie zerowa utrata dokładności

• Przewyższa najnowocześniejszą kwantyzację KV🔥

Kluczowe spostrzeżenia:

1. Pamięć podręczna KV = wąskie gardło → rośnie liniowo z długością kontekstu + rozmiarem partii.

2. Obliczenia >> pamięć → GPU oferują FLOPy w porównaniu do przepustowości pamięci.

3. Kluczowa idea → nie przechowuj KV, po prostu go przelicz. 🧠

Ponieważ wnioskowanie LLM jest zazwyczaj ograniczone przepustowością pamięci, jednostki obliczeniowe są często bezczynne i niedostatecznie wykorzystywane. Możemy więc wykorzystać te dostępne obliczenia bez żadnych dodatkowych kosztów!

Trendy w sprzęcie GPU pokazują, że możliwości obliczeniowe rozwijają się znacznie szybciej niż przepustowość pamięci. Dlatego zmniejszenie operacji pamięci w zamian za więcej obliczeń może pomóc przyspieszyć wnioskowanie LLM. Pamięć podręczna KV rośnie liniowo z długością sekwencji i rozmiarem partii, generując większość operacji pamięci podczas wnioskowania LLM. Jeśli możemy wymienić dodatkowe obliczenia, aby obejść ładowanie i przechowywanie pamięci podręcznej KV, możemy przyspieszyć wnioskowanie!

XQuant wykorzystuje ten trend sprzętowy: 🧵 [1/7]

Artykuł:

Wspólna praca z: @coleman_hooper1 @mjlee_official z @FuriosaAI @HaochengXiUCB @rish2k1 Wonjun Kang z @FuriosaAI @lucamanolache0 Michael Mahoney @KurtKeutzer @amir__gholami

32,43K

Moim zdaniem, SWE-bench i T-bench to nieliczne benchmarki, które mają dobry sygnał w kwestii postępów, jakie osiągamy z modelami. Ten model działa tak samo dobrze jak Qwen3 Coder i jest tylko o 10% gorszy od GPT-5, będąc jednocześnie modelem ogólnego przeznaczenia, a nie specjalizowanym w kodzie.

Z.ai11 sie, 11:43

Prezentujemy raport techniczny GLM-4.5!👇

Ta praca pokazuje, jak opracowaliśmy modele, które doskonale radzą sobie z rozumowaniem, kodowaniem i zadaniami agentowymi dzięki unikalnemu, wieloetapowemu paradygmatowi szkoleniowemu.

Kluczowe innowacje obejmują iterację modeli eksperckich z samodystylacją w celu zjednoczenia możliwości, hybrydowy tryb rozumowania do dynamicznego rozwiązywania problemów oraz program nauczania oparty na trudności w uczeniu przez wzmocnienie.

28,63K

Wygląda na to, że krajobraz zamkniętego kodu w porównaniu do otwartych wag został wyrównany. GPT-5 jest tylko o 10% lepszy w kodowaniu niż model z otwartymi wagami, który możesz uruchomić na komputerze stacjonarnym dla konsumentów, a wkrótce także na laptopie. Jeśli Anthropic nie będzie w stanie stworzyć dobrego modelu, to prawdopodobnie nie zobaczymy AGI przez jakiś czas.

67,23K

Użytkownik Tim Dettmers udostępnił ponownie

Deszcz myśli: Zamiast zatrzymywać swoje wypłaty z Twittera/𝕏, skieruj je na "PayoutChallenge" według własnego wyboru - cokolwiek chcesz mieć więcej na świecie!

Oto moje na tę rundę, łącząc moje ostatnie 3 wypłaty w wysokości 5478,51 USD:

Niezwykle ważne jest, aby ludzkość nie upadła, podczas gdy AI wznosi się. Ludzkość musi nadal się rozwijać, stawać się lepsza obok. Stwórz coś, co jest specjalnie zaprojektowane, aby wspierać zespół ludzkości. Definicja celowo pozostawiona nieco niejasna, aby zachować pewną entropię w interpretacji ludzi, ale moim zdaniem przykłady obejmują:

- Każdy kawałek oprogramowania, który wspomaga wyjaśnianie, wizualizację, zapamiętywanie, inspirację, zrozumienie, koordynację itp...

- Nie musi być zbyt ambitne, np. może to być konkretny artykuł/wideo edukacyjne wyjaśniające coś, z czego inni mogliby skorzystać lub w czym masz unikalną wiedzę.

- Podpowiedzi/agentów do wyjaśniania, np. w stylu niedawno wydanego trybu nauki ChatGPT.

- Powiązane dzieła sztuki

To wyzwanie będzie trwało przez 2 tygodnie do 17 sierpnia do końca dnia PST. Prześlij swój wkład jako odpowiedź. Musi to być coś, co zostało unikalnie stworzone na to wyzwanie i nie istniałoby w przeciwnym razie. Kryteria obejmują wykonanie, wykorzystanie, nowość, inspirację, estetykę, rozrywkę. Ludzie mogą głosować na zgłoszenia, lubiąc je, ten "wybór ludzi" również będzie czynnikiem. Zdecyduję o zwycięzcy 17 sierpnia i wyślę 5478,51 USD :)

677,06K

Użytkownik Tim Dettmers udostępnił ponownie

Ogłaszamy nasze wczesne prace nad wnioskowaniem w 4PR dla LLM!

- QuTLASS: obsługa jądra o niskiej precyzji dla procesorów graficznych Blackwell

- FP-Quant: elastyczna wiązka do kwantyzacji dla lamy/Qwen

Osiągamy 4-krotne przyspieszenie w stosunku do BF16, z dobrą dokładnością dzięki mikroskalowaniu MXFP4 + stopione obroty Hadamarda.

22,62K

Użytkownik Tim Dettmers udostępnił ponownie

Tokenizacja to po prostu szczególny przypadek "chunkingu" - budowania danych niskopoziomowych w abstrakcje wysokiego poziomu - co z kolei ma fundamentalne znaczenie dla inteligencji.

Nasza nowa architektura, która umożliwia hierarchiczne *dynamiczne fragmentowanie*, jest nie tylko wolna od tokenizatorów, ale po prostu lepiej się skaluje.

194,8K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi