热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Tim Dettmers

Tim Dettmers 已转发

介绍 DeepConf:自信地深思

🚀 首个使用开源模型在 AIME 2025 上实现 99.9% 的方法!即使没有工具,使用 GPT-OSS-120B,我们也达到了几乎完美的准确率,同时节省了多达 85% 的生成令牌。

它还为并行思维提供了许多强大的优势:

🔥 性能提升:模型和数据集的准确率提高约 10%

⚡ 超高效:生成的令牌减少多达 85%

🔧 即插即用:与任何现有模型兼容 - 无需训练(也无需超参数调整!)

⭐ 易于部署:在 vLLM 中只需 ~50 行代码(见下面的 PR)

📚 论文:

🌐 项目:

与以下人员共同合作:@FuYichao123 , xuewei_wang, @tydsh

(请查看下面的评论中的详细信息)

408.69K

Tim Dettmers 已转发

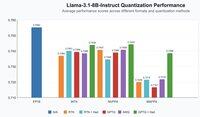

我们能否通过 KV 缓存重计算来打破 LLM 推理的内存壁垒?

🚨 介绍 XQuant,它利用未充分利用的计算单元来消除 LLM 推理的内存瓶颈!

• 与 FP16 相比节省 10–12.5 倍内存

• 几乎没有准确性损失

• 超越最先进的 KV 量化🔥

关键见解:

1. KV 缓存 = 瓶颈 → 随着上下文长度和批量大小线性增长。

2. 计算 >> 内存 → GPU 提供的 FLOPs 速度比内存带宽快几个数量级。

3. 关键思想 → 不存储 KV,只需重新计算它。 🧠

由于 LLM 推理通常受限于内存带宽,计算单元往往处于空闲和未充分利用状态。因此,我们可以在没有任何开销的情况下利用这些可用的计算资源!

GPU 硬件趋势表明,计算能力的增长速度远快于内存带宽。因此,减少内存操作以换取更多计算可以帮助加速 LLM 推理。KV 缓存随着序列长度和批量大小线性增长,在 LLM 推理过程中产生大部分内存操作。如果我们可以通过额外的计算来避免加载和存储 KV 缓存,我们就可以加速推理!

XQuant 利用这一硬件趋势:🧵 [1/7]

论文:

与以下人员共同合作:@coleman_hooper1 @mjlee_official 来自 @FuriosaAI @HaochengXiUCB @rish2k1 Wonjun Kang 来自 @FuriosaAI @lucamanolache0 Michael Mahoney @KurtKeutzer @amir__gholami

32.43K

在我看来,SWE-bench 和 T-bench 是少数几个在我们模型进展方面有良好信号的基准。这款模型的表现与 Qwen3 Coder 相当,仅比 GPT-5 差 10%,同时它还是一款通用的 LLM,而不是专门针对代码的。

Z.ai8月11日 11:43

呈现 GLM-4.5 技术报告!👇

这项工作展示了我们如何通过独特的多阶段训练范式开发出在推理、编码和代理任务方面表现出色的模型。

关键创新包括通过自我蒸馏进行专家模型迭代以统一能力、用于动态问题解决的混合推理模式,以及基于难度的强化学习课程。

28.63K

Tim Dettmers 已转发

思维的洗礼:与其保留你的Twitter/𝕏收入,不如将其用于你选择的“收入挑战”——任何你希望在世界上更多的东西!

这是我这一轮的挑战,结合我最近的3次收入,总计$5478.51:

人类在人工智能崛起的同时,绝不能倒下。人类必须继续崛起,与之共同进步。创造一些专门旨在提升人类团队的东西。定义故意留得有些模糊,以保持人们对其解释的某种熵,但在我看来,例子包括:

- 任何有助于解释、可视化、记忆、启发、理解、协调等的软件。

- 不必太高大上,例如,它可以是某个特定的教育文章/视频,解释一些其他人可能受益的内容,或者你拥有独特知识的内容。

- 用于解释的提示/代理,例如,类似于最近发布的ChatGPT学习模式。

- 相关的艺术作品

这个挑战将持续2周,直到8月17日太平洋标准时间结束。请将你的贡献作为回复提交。它必须是为这个挑战独特创造的东西,否则不会存在。标准包括执行、杠杆、创新、启发、美学、娱乐。人们可以通过点赞来为提交的作品投票,这个“民意选择”也将是一个因素。我将在8月17日决定获胜者,并发送$5478.51 :)

677.06K

热门

排行

收藏