Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Я немного запутался во всех этих акронимах и жаргоне, поэтому я попросил Клода объяснить это без использования акронимов, и теперь все стало совершенно ясным (короче говоря; пропускная способность ⟹ простота):

Это увлекательная техническая дискуссия о тренировке больших языковых моделей в масштабе.

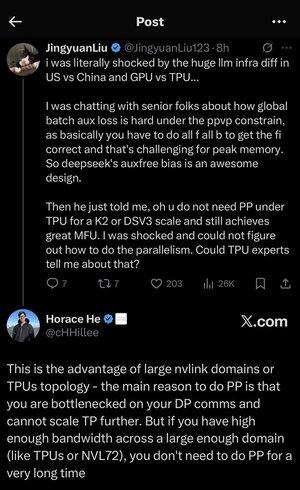

Основной разговор

Цзиньюань Лю выражает удивление тем, что не нужны определенные сложные методы оптимизации при использовании TPU (тензорные процессоры - специализированные чипы ИИ от Google) по сравнению с GPU (графические процессоры - обычно чипы от NVIDIA).

Ключевые технические концепции:

Типы оборудования:

• GPU (графический процессор): Изначально разработан для графики, теперь активно используется для ИИ. NVIDIA доминирует на этом рынке.

• TPU (тензорный процессор): Чипы, специально разработанные Google для машинного обучения.

Стратегии параллелизма:

При обучении огромных ИИ моделей необходимо распределить работу между многими чипами. Существует несколько способов сделать это:

1. Параллелизм данных (DP): Каждый чип обрабатывает разные партии данных с одной и той же копией модели.

2. Тензорный параллелизм (TP): Математические операции модели распределяются между чипами.

3. Параллелизм по конвейеру (PP): Разные слои модели размещаются на разных чипах, создавая конвейер.

Техническая проблема, обсуждаемая в разговоре:

Проблема вспомогательной потери: При обучении очень больших моделей часто добавляют "вспомогательные потери" (дополнительные цели обучения) на промежуточных слоях, чтобы помочь градиентам лучше проходить через сеть. В условиях PPVP (параллелизм по конвейеру с переменным разбиением) это становится сложным, потому что:

• Вам нужно делать "все f все b" (все прямые проходы, затем все обратные проходы).

• Это сложно для пикового использования памяти, потому что нужно хранить промежуточные результаты.

Инновация DeepSeek: Они разработали дизайн "auxfree bias", который, по-видимому, избегает необходимости в этих вспомогательных потерях, при этом эффективно обучая.

Удивительное откровение:

Старший эксперт сказал Цзиньюаню, что с TPU на уровне K2 или DSV3 (это конфигурации кластеров с сотнями или тысячами чипов) можно достичь отличной MFU (использование FLOPs модели - по сути, насколько эффективно вы используете оборудование) БЕЗ использования параллелизма по конвейеру.

Почему это удивительно?

• Параллелизм по конвейеру обычно считается необходимым для обучения в большом масштабе.

• Это сложная техника, требующая тщательной оптимизации.

• Возможность избежать этого значительно упрощает все.

Объяснение Хораса Хи:

Он объясняет, ПОЧЕМУ это возможно с TPU:

Преимущество пропускной способности: TPU и высококлассные кластеры NVIDIA (например, NVL72 - последняя конфигурация NVIDIA с 72 GPU с межсоединениями NVLink) имеют такую высокую пропускную способность между чипами, что могут справляться с требованиями к коммуникации без параллелизма по конвейеру.

Ключевое понимание:

• Параллелизм по конвейеру в основном необходим, когда вы "узкоколейны по DP comms" (ограничены тем, насколько быстро вы можете общаться во время обучения с параллелизмом данных).

• Если у вас достаточно пропускной способности в достаточно большом домене (связанном кластере), вы можете просто использовать более простые стратегии параллелизма.

• Это работает "в течение очень долгого времени" - это означает, что вы можете обучать даже очень большие модели, не достигая пределов.

Интуиция:

Представьте это как систему шоссе:

• Традиционные кластеры GPU похожи на узкие дороги между городами, поэтому вам нужно сложное маршрутизирование (параллелизм по конвейеру), чтобы избежать пробок.

• Кластеры TPU или GPU, соединенные NVLink, похожи на огромные супермагистрали - вы можете просто отправлять все напрямую без сложного маршрутизирования.

Это важно, потому что параллелизм по конвейеру сложно реализовать, отлаживать и оптимизировать. Возможность избежать этого, при этом достигая высокой эффективности, делает весь процесс обучения гораздо проще и надежнее.

Обсуждение подчеркивает, как достижения в технологии межсоединения оборудования ("дороги" между чипами) могут кардинально изменить программные стратегии, необходимые для эффективного обучения ИИ.

3,57K

Топ

Рейтинг

Избранное