Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Una teoría más amplia del diseño de sistemas: qué está mal con la modernidad y la posmodernidad, cómo sobrevivir a la avalancha que se avecina y cómo solucionar los principales problemas que enfrentamos.

Primera parte: Los sistemas son modelos. Pero, ¿qué es un modelo?

Te prometo que esto se pondrá práctico en algún momento, pero primero tenemos que sentar las bases. Si encuentra el trabajo preliminar obvio o está dispuesto a confiar en mi palabra, no dude en omitirlo. Pero en última instancia, sin los antecedentes, ni siquiera se puede entender realmente la propuesta.

Sin pérdida de generalidad, cualquier sistema puede verse como un grafo de parámetros conectado por bordes, donde los nodos sensoriales reciben entradas que impulsan tanto los cambios internos del grafo como las salidas en los nodos activos.

Un modelo es un sistema que actúa para minimizar el error de predicción frente a los anteriores incorporados por su gráfico de parámetros.

Los sistemas son siempre modelos porque los sistemas tienen que seguir persistiendo, y si toman acciones incompatibles con las condiciones de persistencia mueren. Las condiciones cambian. Por lo tanto, los sistemas persistentes deben aprender, lo que les exige modelar la realidad y minimizar la sorpresa.

Ejemplos de modelos: el acero en la fragua de un herrero, el mercado, un bosque, una célula, un árbol, un LLM, la red eléctrica, una corporación, un servicio de redes sociales. Es decir, cualquier cosa que se adapte con el tiempo para anticiparse a nuevas entradas.

Aparte: Estas cosas no son solo modelos. También se pueden ver de otras maneras: un servicio de redes sociales es también una colección de software, perfectamente fijo y determinista, que procesa entradas y salidas. Un ser humano es una bolsa lipídica de agua, y también una persona, y también un modelo.

Los modelos pueden ser vistos como la predicción de una distribución sobre las posibles entradas. Un modelo exitoso predice una distribución que coincide bien con la distribución de sus entradas. Lo que significa que predice con exactitud, precisión, robustez y eficiencia.

(Lo que sigue es una explicación sencilla del procesamiento predictivo y el principio de energía libre y la inferencia activa, en caso de que tenga los antecedentes).

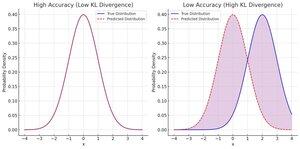

Decimos que la distribución predicha es precisa cuando minimiza la divergencia de la distribución de entrada observada.

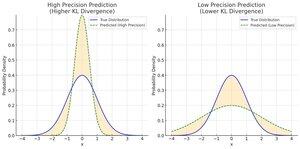

Llamamos precisa a la distribución predicha cuando tiene una varianza baja, lo que significa que hace una predicción muy específica. Un pronóstico más estrecho con una precisión determinada no hace que su estimación promedio se acerque más a la entrada promedio, ¡pero sí lo acerca más en cada suposición!

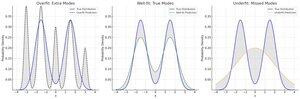

Las predicciones son robustas al ruido si son lo más simples posible. Cuantos menos parámetros e interacciones de parámetros utilice un modelo para una predicción, más se ajustará al aspecto invariable de baja frecuencia de la entrada.

La mayoría de las veces omitiremos la eficiencia aquí, pero la idea principal es que el consumo de energía es básicamente lo mismo que el gasto de bits de precisión o complejidad, solo tiene que traducir de la termo a la teoría de la información.

Es fácil tener una alta precisión realmente robusta: siempre adivina lo mismo. Desafortunadamente, tu precisión será una mierda. Como resultado, generalmente los consideramos juntos, como un error ponderado por precisión.

Se ha descubierto que el camino real hacia la pérdida de peso de baja precisión es la amarga lección: ¿ha probado más parámetros y más datos? Eventualmente, puedes sobreajustar todo el conocimiento humano (LLM) y eso es bastante bueno. Lamentablemente, si el dominio cambia... no es robusto.

Los tres requieren equilibrio. Afortunadamente, puedes puntuarlos todos en bits.

Error ponderado con precisión = -log (divergencia de las entradas, ponderada por precisiones)

Robustez, también conocida como Complejidad = -log (divergencia de las prioridades del modelo de las anteriores uniformes o naturales)

Para cualquier acción o cambio en su modelo, puede puntuar cuánto ayuda sumando el beneficio total en términos de exactitud, precisión y solidez. ¿Vale la pena agregar ese parámetro? Bueno, ¿los 20 bits adicionales de precisión pagan por los 8 bits de complejidad en sus anteriores?

Al considerar un sistema real, el objetivo nominal suele ser algún tipo de precisión. Para la economía, el alto crecimiento del PIB y el bajo desempleo es la "expectativa previa" que el sistema trata de cumplir. Para una corporación, generalmente una expectativa previa de altos ingresos y bajos costos.

Próximamente, parte 2: ¿qué está pasando con nuestros sistemas? ¿Cómo hemos llegado hasta aquí? ¿Por qué todo se está volviendo loco y roto, pero también todo está arriba y hacia la derecha?

38.46K

Populares

Ranking

Favoritas