Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Uma teoria mais abrangente do design de sistemas: o que está errado com a modernidade e a pós-modernidade, como sobreviver à avalanche que se aproxima e como resolver os principais problemas que enfrentamos.

Parte um: Sistemas são Modelos. Mas o que é um Modelo?

Prometo que isto se torna prático em algum momento, mas primeiro temos que estabelecer algumas bases. Se você achar as bases óbvias ou estiver disposto a simplesmente aceitar a minha palavra, sinta-se à vontade para pular. Mas, no final das contas, sem o contexto, você não consegue realmente entender a proposta.

Sem perda de generalidade, qualquer sistema pode ser visto como um grafo de parâmetros conectado por arestas, onde nós sensoriais recebem entradas que impulsionam tanto mudanças internas no grafo quanto produzem saídas em nós ativos.

Um modelo é um sistema que atua para minimizar o erro de previsão em relação aos priors incorporados pelo seu gráfico de parâmetros.

Os sistemas são sempre modelos porque os sistemas têm que continuar a persistir, e se tomarem ações incompatíveis com as condições de persistência, eles morrem. As condições mudam. Portanto, sistemas persistentes devem aprender, o que requer que eles modelem a realidade e minimizem a surpresa.

Exemplos de modelos: aço na forja de um ferreiro, o mercado, uma floresta, uma célula, uma árvore, um LLM, a rede elétrica, uma corporação, um serviço de mídia social. Em outras palavras, qualquer coisa que se adapta ao longo do tempo para antecipar novas entradas.

À parte: Estas coisas não são apenas modelos. Podem também ser vistas de outras maneiras: um serviço de redes sociais é também uma coleção de software, perfeitamente fixo e determinístico, processando entradas e saídas. Um humano é um saco lipídico de maioritariamente água, e também uma pessoa, e também um modelo.

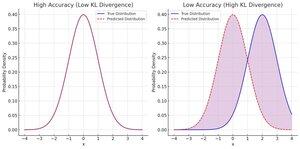

Os modelos podem ser vistos como preditores de uma distribuição sobre possíveis entradas. Um modelo bem-sucedido prevê uma distribuição que corresponde bem à distribuição de suas entradas. Isso significa que ele prevê de forma precisa, exata, robusta e eficiente.

(O que se segue é uma explicação simples do processamento preditivo e do princípio da energia livre e da inferência ativa, caso você tenha o conhecimento prévio).

Dizemos que a distribuição prevista é precisa quando minimiza a divergência da distribuição de entrada observada.

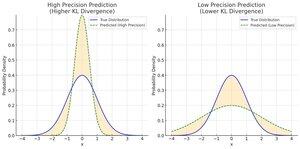

Chamamos a distribuição prevista precisa quando tem baixa variância, o que significa que faz uma previsão muito específica. Uma previsão mais estreita com uma determinada precisão não aproxima a sua média do palpite da média de entrada, mas aproxima-o a cada palpite!

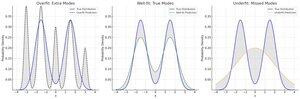

As previsões são robustas ao ruído se forem o mais simples possível. Quanto menos parâmetros e interações de parâmetros um modelo utiliza para uma previsão, mais ele se ajusta ao aspecto inalterado de baixa frequência da entrada.

Vamos principalmente ignorar a eficiência aqui, mas a ideia principal é que o consumo de energia é basicamente o mesmo que gastar bits em precisão ou complexidade, você só precisa traduzir de termodinâmica para teoria da informação.

É fácil ter uma alta precisão de forma realmente robusta: sempre adivinhe a mesma coisa. Infelizmente, sua precisão será uma porcaria. Como resultado, geralmente consideramos isso em conjunto, como erro ponderado pela precisão.

O Caminho Real para a perda ponderada de baixa precisão foi descoberto como a amarga lição: você já tentou mais parâmetros e mais dados? Eventualmente, você pode se ajustar demais a todo o conhecimento humano (LLMs) e isso é bastante bom. Infelizmente, se o domínio mudar... não é robusto.

Todos os três requerem equilíbrio. Felizmente, você pode pontuá-los todos em bits.

Erro ponderado por precisão = -log(divergência das entradas, ponderada por precisões)

Robustez, também conhecida como Complexidade = -log(divergência das priors do modelo em relação à prior uniforme ou natural)

Para qualquer ação ou mudança no seu modelo, você pode avaliar o quanto isso ajuda somando o benefício total em termos de precisão, exatidão e robustez. Vale a pena adicionar esse parâmetro? Bem, os 20 bits extras de precisão compensam os 8 bits de complexidade nos seus priors?

Ao considerar um sistema real, o objetivo nominal é geralmente algum tipo de precisão. Para a economia, um alto crescimento do PIB e baixo desemprego é a "expectativa prévia" que o sistema tenta cumprir. Para uma corporação, geralmente há uma expectativa prévia de alta receita e baixos custos.

Em breve, parte 2: o que está acontecendo com os nossos sistemas? Como chegamos aqui? Por que tudo está insano e quebrado, mas também está tudo subindo e para a direita?

38,47K

Top

Classificação

Favoritos