Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eine umfassendere Theorie des Systemdesigns: Was ist falsch an der Moderne und Postmoderne, wie man die bevorstehende Lawine überlebt und wie man die großen Probleme, mit denen wir konfrontiert sind, beheben kann.

Teil eins: Systeme sind Modelle. Aber was ist ein Modell?

Ich verspreche, dass es irgendwann praktisch wird, aber zuerst müssen wir einige Grundlagen legen. Wenn du die Grundlagen offensichtlich findest oder bereit bist, einfach mein Wort dafür zu nehmen, kannst du sie gerne überspringen. Aber letztendlich kannst du ohne den Hintergrund das Angebot nicht wirklich verstehen.

Ohne Einschränkung der Allgemeinheit kann jedes System als ein Parametergraph betrachtet werden, der durch Kanten verbunden ist, wobei sensorische Knoten Eingaben empfangen, die sowohl interne Graphänderungen antreiben als auch Ausgaben an aktiven Knoten erzeugen.

Ein Modell ist ein System, das darauf abzielt, den Vorhersagefehler im Vergleich zu den in seinem Parametergraphen verkörperten Prioren zu minimieren.

Systeme sind immer Modelle, weil Systeme weiterhin bestehen müssen, und wenn sie Handlungen durchführen, die mit den Bedingungen der Persistenz unvereinbar sind, sterben sie. Die Bedingungen ändern sich. Daher müssen persistente Systeme lernen, was erfordert, dass sie die Realität modellieren und Überraschungen minimieren.

Beispiele für Modelle: Stahl in der Schmiede, der Markt, ein Wald, eine Zelle, ein Baum, ein LLM, das Stromnetz, ein Unternehmen, ein Social-Media-Dienst. Mit anderen Worten, alles, was sich im Laufe der Zeit anpasst, um neue Eingaben vorherzusehen.

Nebenbei: Diese Dinge sind nicht nur Modelle. Sie können auch auf andere Weise betrachtet werden: Ein Social-Media-Dienst ist auch eine Sammlung von Software, perfekt festgelegt und deterministisch, die Eingaben und Ausgaben verarbeitet. Ein Mensch ist ein Lipidbeutel aus überwiegend Wasser, und auch eine Person, und auch ein Modell.

Modelle können als Vorhersage einer Verteilung über mögliche Eingaben betrachtet werden. Ein erfolgreiches Modell sagt eine Verteilung voraus, die gut mit der Verteilung seiner Eingaben übereinstimmt. Das bedeutet, dass es genau, präzise, robust und effizient vorhersagt.

(Was folgt, ist eine einfache Erklärung des prädiktiven Prozesses sowie des Prinzips der freien Energie und der aktiven Inferenz, falls Sie den Hintergrund haben).

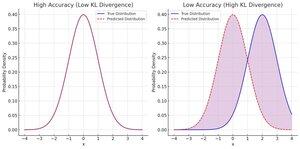

Wir sagen, dass die vorhergesagte Verteilung genau ist, wenn sie die Divergenz von der beobachteten Eingangsverteilung minimiert.

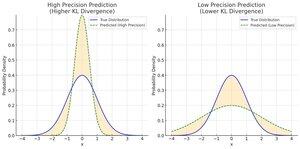

Wir nennen die vorhergesagte Verteilung präzise, wenn sie eine niedrige Varianz aufweist, was bedeutet, dass sie eine sehr spezifische Vorhersage trifft. Eine engere Prognose bei einer bestimmten Genauigkeit bringt deine durchschnittliche Schätzung nicht näher an den Durchschnittswert der Eingaben, aber sie bringt dich bei jeder Schätzung näher!

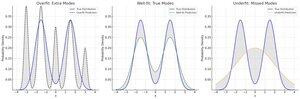

Vorhersagen sind robust gegenüber Rauschen, wenn sie so einfach wie möglich sind. Je weniger Parameter und Parameterinteraktionen ein Modell für eine Vorhersage verwendet, desto mehr passt es zu dem unveränderten Aspekt der Eingabe mit niedriger Frequenz.

Wir werden hier größtenteils die Effizienz überspringen, aber die Hauptidee ist, dass der Energieverbrauch im Grunde genommen dasselbe ist wie die Genauigkeit oder Komplexität der Bit-Ausgaben; man muss nur von Thermodynamik zur Informationstheorie übersetzen.

Es ist einfach, eine hohe Präzision wirklich robust zu haben: immer dasselbe zu raten. Leider wird deine Genauigkeit schlecht sein. Daher betrachten wir sie im Allgemeinen zusammen, als präzisionsgewichteten Fehler.

Der königliche Weg zu einem verlustgewichteten Verlust mit niedriger Präzision hat sich als bittere Lektion herausgestellt: Hast du mehr Parameter und mehr Daten ausprobiert? Letztendlich kannst du auf dem gesamten menschlichen Wissen (LLMs) überanpassen, und das ist ziemlich gut. Leider, wenn sich das Gebiet ändert... nicht robust.

Alle drei erfordern ein Gleichgewicht. Glücklicherweise können Sie sie alle in Bits erfassen.

Präzisionsgewichteter Fehler = -log(Divergenz von Eingaben, gewichtet nach Präzisionen)

Robustheit, auch bekannt als Komplexität = -log(Divergenz der Modellprioren von uniformen oder natürlichen Priors)

Für jede Aktion oder Änderung an Ihrem Modell können Sie bewerten, wie sehr es hilft, indem Sie den gesamten Nutzen in Bezug auf Genauigkeit, Präzision und Robustheit summieren. Ist es wert, diesen Parameter hinzuzufügen? Nun, zahlen die zusätzlichen 20 Bits Genauigkeit für die 8 Bits Komplexität in Ihren Priorisierungen?

Wenn man ein reales System betrachtet, ist das nominale Ziel normalerweise eine Art von Genauigkeit. Für die Wirtschaft sind ein hohes BIP-Wachstum und eine niedrige Arbeitslosigkeit die "vorrangige Erwartung", die das System zu erfüllen versucht. Für ein Unternehmen ist es normalerweise eine vorrangige Erwartung von hohen Einnahmen und niedrigen Kosten.

Bald verfügbar, Teil 2: Was ist mit unseren Systemen los? Wie sind wir hierher gekommen? Warum läuft alles verrückt und ist kaputt, aber gleichzeitig geht alles nach oben und nach rechts?

38,46K

Top

Ranking

Favoriten