Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

¡Las grandes empresas tecnológicas utilizan RAG multimodal todos los días en producción!

- Spotify lo utiliza para responder consultas sobre música

- YouTube lo utiliza para convertir indicaciones en pistas

- Amazon Music lo utiliza para crear listas de reproducción a partir de indicaciones

Aprendamos a construir un RAG Agente Multimodal (con código):

Hoy, construiremos un RAG Agente multimodal que pueda consultar documentos y archivos de audio utilizando el habla del usuario.

Tecnología:

- @AssemblyAI para la transcripción.

- @milvusio como la base de datos vectorial.

- @beam_cloud para el despliegue.

- @crewAIInc Flows para la orquestación.

¡Construyámoslo!

Aquí está el flujo de trabajo:

- El usuario ingresa datos (audio + documentos).

- AssemblyAI transcribe los archivos de audio.

- El texto transcrito y los documentos se integran en la base de datos vectorial Milvus.

- El Agente de Investigación recupera información de la consulta del usuario.

- El Agente de Respuesta la utiliza para elaborar una respuesta.

Revisa esto👇

1️⃣ Ingesta de Datos

Para comenzar, el usuario proporciona los datos de texto y audio en el directorio de datos.

CrewAI Flow implementa la lógica para descubrir los archivos y prepararlos para un procesamiento posterior.

Revisa esto👇

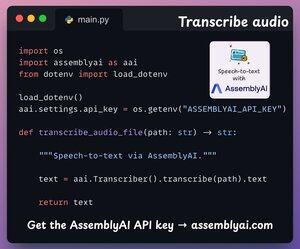

2️⃣ Transcribir audio

A continuación, transcribimos la entrada de audio del usuario utilizando la plataforma de conversión de voz a texto de AssemblyAI.

AssemblyAI no es de código abierto, pero ofrece suficientes créditos gratuitos para utilizar sus modelos de transcripción de última generación, que son más que suficientes para esta demostración.

Revisa esto👇

3️⃣ Incrustar datos de entrada

Continuando, los datos de entrada transcritos del paso anterior y los datos de texto de entrada se incrustan y se almacenan en la base de datos vectorial Milvus.

Así es como lo hacemos 👇

4️⃣ Consulta del usuario

La ingestión ha terminado.

¡Ahora pasamos a la fase de inferencia!

A continuación, el usuario ingresa una consulta de voz, que es transcrita por AssemblyAI.

Revisa esto👇

5️⃣ Recuperar contexto

A continuación, generamos un embedding para la consulta y extraemos los fragmentos más relevantes de la base de datos vectorial Milvus.

Así es como lo hacemos 👇

6️⃣ Generar una respuesta

Una vez que tengamos el contexto relevante, nuestro equipo es convocado para generar una respuesta clara y citada para el usuario.

Revisa esto 👇

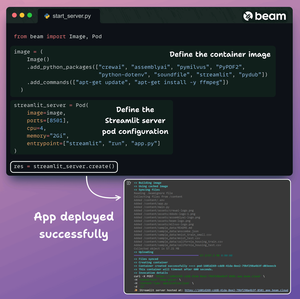

Finalmente, agrupamos todo en una interfaz limpia de Streamlit y desplegamos la aplicación en un contenedor sin servidor utilizando Beam.

Importamos las dependencias necesarias de Python y especificamos las especificaciones de cómputo para el contenedor.

Y luego desplegamos la aplicación en unas pocas líneas de código👇

Una vez desplegado, obtenemos un despliegue 100% privado para el flujo de trabajo Agente Multimodal RAG que acabamos de construir.

Mira esta demostración 👇

Aquí está el flujo de trabajo que implementamos:

- El usuario proporcionó datos (audio + documentos)

- AssemblyAI transcribió los archivos de audio

- Los datos transcritos se incrustaron en la base de datos vectorial

- El Agente de Investigación recuperó información de la consulta del usuario

- El Agente de Respuesta lo utilizó para elaborar una respuesta

Revisa esto👇

Si te ha resultado interesante, vuelve a compartirlo con tu red.

Encuéntrame → @akshay_pachaar ✔️

Para obtener más información y tutoriales sobre LLM, agentes de IA y aprendizaje automático.

5 ago, 20:30

¡Las grandes empresas tecnológicas utilizan RAG multimodal todos los días en producción!

- Spotify lo utiliza para responder consultas sobre música

- YouTube lo utiliza para convertir indicaciones en pistas

- Amazon Music lo utiliza para crear listas de reproducción a partir de indicaciones

Aprendamos a construir un RAG Agente Multimodal (con código):

106.52K

Populares

Ranking

Favoritas