Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Os gigantes da tecnologia usam o RAG multimodal todos os dias na produção!

- O Spotify o usa para responder a consultas de música

- O YouTube o usa para transformar prompts em faixas

- O Amazon Music o usa para criar uma lista de reprodução a partir do prompt

Vamos aprender a construir um RAG agêntico multimodal (com código):

Hoje, criaremos um RAG Agentic multimodal que pode consultar documentos e arquivos de áudio usando a fala do usuário.

Pilha de tecnologia:

- @AssemblyAI para transcrição.

- @milvusio como o vetor DB.

- @beam_cloud para implantação.

- @crewAIInc Fluxos para orquestração.

Vamos construí-lo!

Aqui está o fluxo de trabalho:

- Dados de entrada do usuário (áudio + documentos).

- O AssemblyAI transcreve os arquivos de áudio.

- O texto e os documentos transcritos são incorporados no banco de dados vetorial Milvus.

- O Agente de Pesquisa recupera informações da consulta do usuário.

- O Agente de Resposta o usa para criar uma resposta.

Verifique isso👇

1️⃣ Ingestão de dados

Para começar, o usuário fornece os dados de entrada de texto e áudio no diretório de dados.

O CrewAI Flow implementa a lógica para descobrir os arquivos e prepará-los para processamento posterior.

Verifique isso👇

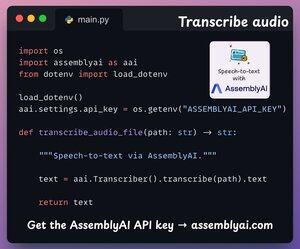

2️⃣ Transcrever áudio

Em seguida, transcrevemos a entrada de áudio do usuário usando a plataforma Speech-to-text da AssemblyAI.

O AssemblyAI não é de código aberto, mas oferece amplos créditos gratuitos para usar seus modelos de transcrição SOTA, que são mais do que suficientes para esta demonstração.

Verifique isso👇

3️⃣ Incorporar dados de entrada

Seguindo em frente, os dados de entrada transcritos da etapa acima e os dados de texto de entrada são incorporados e armazenados no banco de dados vetorial Milvus.

Veja como fazemos isso 👇

4️⃣ Consulta do usuário

A ingestão acabou.

Agora passamos para a fase de inferência!

Em seguida, o usuário insere uma consulta de voz, que é transcrita pelo AssemblyAI.

Verifique isso👇

5️⃣ Recuperar contexto

Em seguida, geramos uma incorporação para a consulta e extraímos as partes mais relevantes do banco de dados vetorial Milvus.

É assim que 👇 fazemos

6️⃣ Gere uma resposta

Assim que tivermos o contexto relevante, nossa equipe é invocada para gerar uma resposta clara e citada para o usuário.

Verifique isso 👇

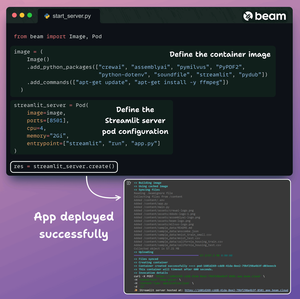

Por fim, reunimos tudo em uma interface Streamlit limpa e implantamos o aplicativo em um contêiner sem servidor usando o Beam.

Importamos as dependências necessárias do Python e especificamos as especificações de computação para o contêiner.

E então implantamos o aplicativo em algumas linhas de código👇

Uma vez implantado, obtemos uma implantação 100% privada para o fluxo de trabalho multimodal RAG Agentic que acabamos de criar.

Confira esta demonstração 👇

Aqui está o fluxo de trabalho que implementamos:

- Dados fornecidos pelo usuário (áudio + documentos)

- AssemblyAI transcreveu os arquivos de áudio

- Os dados transcritos são incorporados no banco de dados vetorial

- O Agente de Pesquisa recuperou informações da consulta do usuário

- O Agente de Resposta o usou para criar uma resposta

Verifique isso👇

Se você achou perspicaz, compartilhe novamente com sua rede.

Encontre-me → @akshay_pachaar ✔️

Para obter mais insights e tutoriais sobre LLMs, agentes de IA e aprendizado de máquina!

5 de ago., 20:30

Os gigantes da tecnologia usam o RAG multimodal todos os dias na produção!

- O Spotify o usa para responder a consultas de música

- O YouTube o usa para transformar prompts em faixas

- O Amazon Music o usa para criar uma lista de reprodução a partir do prompt

Vamos aprender a construir um RAG agêntico multimodal (com código):

106,57K

Melhores

Classificação

Favoritos