Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Các gã khổng lồ công nghệ sử dụng Multimodal RAG hàng ngày trong sản xuất!

- Spotify sử dụng nó để trả lời các câu hỏi về âm nhạc

- YouTube sử dụng nó để biến các gợi ý thành các bản nhạc

- Amazon Music sử dụng nó để tạo danh sách phát từ gợi ý

Hãy cùng học cách xây dựng một Multimodal Agentic RAG (với mã):

Hôm nay, chúng ta sẽ xây dựng một RAG Agentic đa phương thức có thể truy vấn tài liệu và tệp âm thanh bằng giọng nói của người dùng.

Công nghệ sử dụng:

- @AssemblyAI cho việc chuyển đổi văn bản.

- @milvusio làm cơ sở dữ liệu vector.

- @beam_cloud cho việc triển khai.

- @crewAIInc Flows cho việc điều phối.

Hãy cùng xây dựng nó!

Dưới đây là quy trình làm việc:

- Người dùng nhập dữ liệu (âm thanh + tài liệu).

- AssemblyAI chuyển đổi các tệp âm thanh thành văn bản.

- Văn bản đã chuyển đổi & tài liệu được nhúng vào cơ sở dữ liệu vector Milvus.

- Đại lý nghiên cứu lấy thông tin từ truy vấn của người dùng.

- Đại lý phản hồi sử dụng thông tin đó để tạo ra một phản hồi.

Kiểm tra cái này👇

1️⃣ Nhập Dữ Liệu

Để bắt đầu, người dùng cung cấp dữ liệu đầu vào văn bản và âm thanh trong thư mục dữ liệu.

CrewAI Flow thực hiện logic để phát hiện các tệp và chuẩn bị chúng cho quá trình xử lý tiếp theo.

Kiểm tra điều này👇

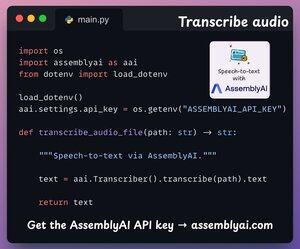

2️⃣ Chuyển đổi âm thanh thành văn bản

Tiếp theo, chúng tôi chuyển đổi đầu vào âm thanh của người dùng bằng nền tảng Chuyển giọng nói thành văn bản của AssemblyAI.

AssemblyAI không phải là mã nguồn mở, nhưng nó cung cấp nhiều tín dụng miễn phí để sử dụng các mô hình chuyển đổi văn bản SOTA của họ, điều này là đủ cho bản demo này.

Kiểm tra cái này👇

3️⃣ Nhúng dữ liệu đầu vào

Tiếp theo, dữ liệu đầu vào đã được phiên âm từ bước trên và dữ liệu văn bản đầu vào được nhúng và lưu trữ trong cơ sở dữ liệu vector Milvus.

Dưới đây là cách chúng tôi thực hiện 👇

4️⃣ Yêu cầu của người dùng

Quá trình thu thập dữ liệu đã hoàn tất.

Bây giờ chúng ta chuyển sang giai đoạn suy diễn!

Tiếp theo, người dùng nhập một truy vấn bằng giọng nói, được chuyển đổi thành văn bản bởi AssemblyAI.

Kiểm tra điều này👇

5️⃣ Lấy ngữ cảnh

Tiếp theo, chúng tôi tạo một embedding cho truy vấn và lấy những đoạn liên quan nhất từ cơ sở dữ liệu vector Milvus.

Đây là cách chúng tôi thực hiện 👇

6️⃣ Tạo một câu trả lời

Khi chúng tôi có bối cảnh liên quan, Nhóm của chúng tôi sẽ được triệu tập để tạo ra một phản hồi rõ ràng và có trích dẫn cho người dùng.

Kiểm tra điều này 👇

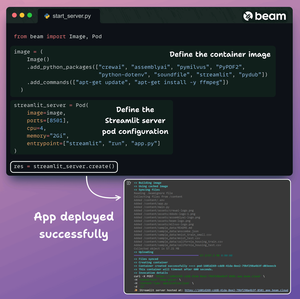

Cuối cùng, chúng ta gói gọn mọi thứ vào một giao diện Streamlit sạch sẽ và triển khai ứng dụng vào một container không máy chủ bằng cách sử dụng Beam.

Chúng ta nhập các phụ thuộc Python cần thiết và chỉ định các thông số tính toán cho container.

Và sau đó, chúng ta triển khai ứng dụng chỉ với vài dòng mã👇

Khi được triển khai, chúng tôi có một triển khai hoàn toàn riêng tư 100% cho quy trình làm việc Multimodal RAG Agentic mà chúng tôi vừa xây dựng.

Xem bản demo này 👇

Dưới đây là quy trình chúng tôi đã triển khai:

- Người dùng cung cấp dữ liệu (âm thanh + tài liệu)

- AssemblyAI đã chuyển đổi các tệp âm thanh thành văn bản

- Dữ liệu đã chuyển đổi được nhúng vào cơ sở dữ liệu vector

- Đại lý nghiên cứu đã truy xuất thông tin từ truy vấn của người dùng

- Đại lý phản hồi đã sử dụng nó để tạo ra một phản hồi

Kiểm tra điều này👇

Nếu bạn thấy nội dung này hữu ích, hãy chia sẻ lại với mạng lưới của bạn.

Tìm tôi → @akshay_pachaar ✔️

Để biết thêm thông tin chi tiết và hướng dẫn về LLMs, AI Agents, và Machine Learning!

20:30 5 thg 8

Các gã khổng lồ công nghệ sử dụng Multimodal RAG hàng ngày trong sản xuất!

- Spotify sử dụng nó để trả lời các câu hỏi về âm nhạc

- YouTube sử dụng nó để biến các gợi ý thành các bản nhạc

- Amazon Music sử dụng nó để tạo danh sách phát từ gợi ý

Hãy cùng học cách xây dựng một Multimodal Agentic RAG (với mã):

106,52K

Hàng đầu

Thứ hạng

Yêu thích