Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-OSS käyttää MXFP4-kvantisointia (jota MLX nyt tukee).

Tällä hetkellä on liikkeellä kaksi FP4-muotoa: MXFP4 ja NVFP4 (NV Nvidialle).

Kun tarkastellaan, kuinka GPT-OSS käyttää MXFP4:ää, se on jonkin verran epäoptimaalinen. Luulen, että NVFP4 on yleisimmin käytetty formaatti tulevaisuudessa.

Lisätietoja alla:

Molemmat muodot kvantisoivat painot 4-bittiseen liukulukuun (e2 m1) ainutlaatuisella ryhmäkohtaisella asteikolla.

Ero on ryhmän koossa ja kunkin ryhmän asteikon koodauksessa.

- MXFP4 käyttää e8m0-asteikkoa (kiinteä piste, 8-bittinen), jonka ryhmäkoko on 32. Se nostetaan potenssiin 2 ennen painon moninkertaistamista.

- NVFP4 käyttää e4m3 (fp8) -asteikkoa, jonka ryhmäkoko on 16. Se kerrotaan painolla suoraan

MXFP4:n asteikkokoodaus on melko epäoptimaalinen, koska siinä ei ole esityksiä monille arvoille tarvitsemallamme alueella.

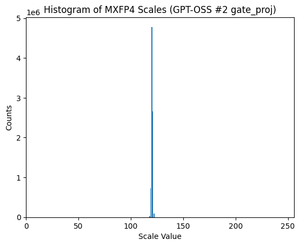

Itse asiassa, jos tarkastellaan GPT-OSS:n asteikkojakaumaa, se on erittäin keskittynyt vain parin arvon ympärille. Esimerkiksi toiselle MoE-kerrokselle, jota tarkastelen, käytetään jopa 8/256 mahdollista arvoa. (Katso juoni).

17,83K

Johtavat

Rankkaus

Suosikit