Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

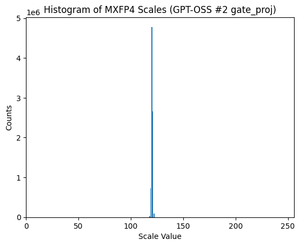

GPT-OSS folosește cuantificarea MXFP4 (pe care MLX o acceptă acum).

Există două formate FP4 care circulă în acest moment: MXFP4 și NVFP4 (NV pentru Nvidia).

Uitându-ne la modul în care GPT-OSS folosește MXFP4, este oarecum suboptim. Cred că NVFP4 va fi cel mai frecvent utilizat format în viitor.

Mai multe detalii mai jos:

Ambele formate cuantifică greutățile în virgulă mobilă de 4 biți (e2 m1) cu o scară unică pe grup.

Diferența este dimensiunea grupului și modul în care este codificată scala pentru fiecare grup.

- MXFP4 folosește o scară e8m0 (punct fix, 8 biți) cu o dimensiune de grup de 32. Se ridică la puterea 2 înainte de a înmulți greutatea.

- NVFP4 folosește o scară e4m3 (fp8) cu o dimensiune de grup de 16. Se înmulțește direct cu greutatea

Codificarea scalei în MXFP4 este destul de suboptimă, deoarece nu are reprezentări pentru o mulțime de valori în intervalul de care avem nevoie.

De fapt, dacă te uiți la distribuția scalelor pentru GPT-OSS, aceasta este extrem de concentrată în jurul a doar câteva valori. De exemplu, pentru al doilea strat MoE mă uit la doar 8/256 de valori posibile sunt chiar utilizate. (Vezi graficul).

17,83K

Limită superioară

Clasament

Favorite