Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Хто-небудь пробував цей агентичний мислитель довгого контексту LLM від ByteDance? 👀

Або ажіотаж навколо китайських моделей з відкритим вихідним кодом спав?

36B Instruct і Based моделі (навіть база без синтетичних даних) з чудовими (SOTA?) лавками 🤔

Про завтрашній день ми розповімо про @thursdai_pod

21 серп., 04:02

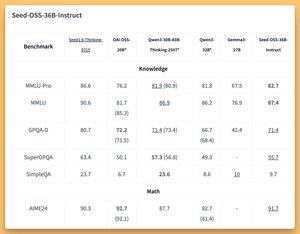

ByteDance випускає Seed-OSS (Apache-2.0): відкрита серія LLM (12T токенів), оптимізована для 512K ctx, міркування, завдань агента, i18n (міжнародне використання). Реліз включає в себе Seed-OSS-36B-Base (без синтетичних даних) і Seed-OSS-36B-Instruct

- Arch: 36B params, 64L, hidden 5120, vocab 155K, GQA (80/8/8, голова 128), SwiGLU, RMSNorm, RoPE base 1e7

- Бюджет мислення: Контрольна довжина міркувань (кратна 512), саморефлексія CoT, 0 = прямі відповіді, за замовчуванням = необмежена

36B-Base (з / без син.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84,9 / 84,8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- ВВН 87,7 / 87,2 | AGIEval-en 70.7 / 70.1

- GSM8K 90,8 / 90,3 | МАТЕМАТИКА 81.7 СОТА / 61.3

- МБПП 80,6 / 74,6 | HumanEval 76.8 / 75.6

36Б-Інструктаж

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 СОТА | AIME25 84,7 | За межами AIME 65

- ArcAGI V2 40.6 | КОРБенч 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Роздрібна 70.4 SOTA | ТАУ1-Авіакомпанія 46

- SWE-Bench Перевірено 56 SOTA | Лавка Multi-SWE-Bench 17

- MMMLU 78.4 | ЛІНІЙКА (128K) 94,6 СОТА | ЛАВКА ПОВІТРЯНА 75.6

Висновок: Transformers, vLLM (≥0.10.0), FlashAttention2, 4/8-бітове квантування

3K

Найкращі

Рейтинг

Вибране