熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

有人嘗試過字節跳動的這個代理長文本思考者 LLM 嗎?👀

還是說關於開源中文模型的熱度已經下降了?

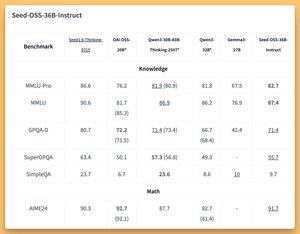

36B 指令和基礎模型(即使是沒有合成數據的基礎模型)在一些很棒的(SOTA?)基準上表現出色 🤔

我們明天將在 @thursdai_pod 進行討論。

8月21日 04:02

字節跳動發布 Seed-OSS (Apache-2.0):開放 LLM 系列(12T 令牌),針對 512K 上下文、推理、代理任務、國際化(國際使用)進行了優化。此次發布包括 Seed-OSS-36B-Base(有/無合成數據)和 Seed-OSS-36B-Instruct

- 架構:36B 參數,64 層,隱藏層 5120,詞彙表 155K,GQA (80/8/8,頭 128),SwiGLU,RMSNorm,RoPE 基礎 1e7

- 思維預算:控制推理長度(512 的倍數),CoT 自我反思,0 = 直接答案,默認 = 無限

36B-Base(有合成數據 vs 無合成數據)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Verified 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

推理:Transformers,vLLM (≥0.10.0),FlashAttention2,4/8 位量化

3.01K

熱門

排行

收藏