Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Có ai đã thử mô hình LLM tư duy dài hạn từ ByteDance này chưa? 👀

Hay là sự phấn khích xung quanh các mô hình mã nguồn mở của Trung Quốc đã giảm?

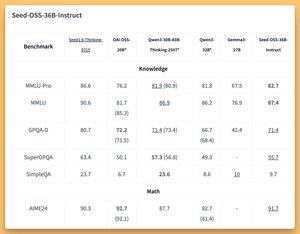

Mô hình 36B Instruct và Based (thậm chí là cơ bản mà không có dữ liệu tổng hợp) với một số điểm chuẩn tuyệt vời (SOTA?) 🤔

Chúng tôi sẽ đề cập đến điều này vào ngày mai trên @thursdai_pod

04:02 21 thg 8

ByteDance phát hành Seed-OSS (Apache-2.0): chuỗi LLM mở (12T token) tối ưu hóa cho 512K ctx, lý luận, nhiệm vụ tác nhân, i18n (sử dụng quốc tế). Phiên bản này bao gồm Seed-OSS-36B-Base (có và không có dữ liệu tổng hợp) và Seed-OSS-36B-Instruct

- Kiến trúc: 36B tham số, 64L, ẩn 5120, từ vựng 155K, GQA (80/8/8, đầu 128), SwiGLU, RMSNorm, RoPE cơ sở 1e7

- Ngân sách tư duy: Kiểm soát độ dài lý luận (bội số của 512), tự phản ánh CoT, 0 = câu trả lời trực tiếp, mặc định = không giới hạn

36B-Base (có so với không có tổng hợp)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Verified 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Suy diễn: Transformers, vLLM (≥0.10.0), FlashAttention2, định lượng 4/8-bit

3K

Hàng đầu

Thứ hạng

Yêu thích