Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aujourd’hui marque une très grande réalisation pour Nous, mais aussi potentiellement pour le paysage de l’IA.

Nous avons commencé une exécution de pré-entraînement décentralisée de ce qui est essentiellement un Deepseek dense - 40 milliards de paramètres, plus de 20 jetons T, avec MLA pour une efficacité contextuelle longue.

Tous les points de contrôle, non recuits, recuits, l’ensemble de données, tout sera opensource en direct au fur et à mesure de la formation.

Consultez le blog @DillonRolnick lequel l’équipe Psyche dirige, @theemozilla et Ari ont écrit dans le tweet de citation pour en savoir *beaucoup* plus sur l’infrastructure.

15 mai 2025

Annonce du lancement de Psyché

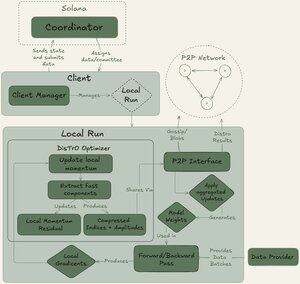

Nous Research démocratise le développement de l’Intelligence Artificielle. Aujourd’hui, nous nous lançons dans notre plus grand effort à ce jour pour faire de cette mission une réalité : le réseau Psyche

Psyche est un réseau de formation décentralisé qui permet de rassembler les calculateurs du monde entier pour former une IA puissante, donnant aux individus et aux petites communautés l’accès aux ressources nécessaires pour créer de nouveaux modèles à grande échelle intéressants et uniques.

Nous lançons aujourd’hui notre testnet avec le pré-entraînement d’un LLM à 40B paramètres, un modèle suffisamment puissant pour servir de base aux futures recherches en science ouverte. Cette exécution représente la plus grande exécution de pré-entraînement effectuée sur Internet à ce jour, surpassant les itérations précédentes qui entraînaient des modèles plus petits sur beaucoup moins de jetons de données.

63,35K

Meilleurs

Classement

Favoris