Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

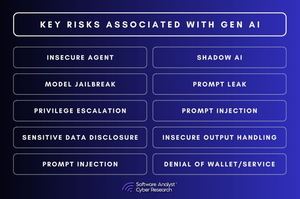

I 3 gap di sicurezza dell'AI che stanno lasciando le imprese esposte!

La conversazione sulla sicurezza dell'AI sta avanzando rapidamente.

Ma ci sono gap fondamentali che le imprese non hanno ancora affrontato.

Per il nostro rapporto, abbiamo analizzato i rischi di sicurezza dell'AI in vari settori e abbiamo scoperto che la maggior parte delle imprese sta commettendo gli stessi 3 errori. E questi gap non sono piccoli: stanno ridefinendo come deve apparire la cybersecurity in un mondo guidato dall'AI.

1. La governance dell'AI è assente

La maggior parte delle organizzazioni non ha visibilità su come l'AI viene utilizzata all'interno della propria impresa.

▪️I dipendenti stanno integrando strumenti di AI senza l'approvazione dell'IT.

▪️I team di sicurezza non possono tracciare quali modelli di AI stanno elaborando.

▪️I copiloti dell'AI hanno accesso ai dati aziendali maggiore di quanto dovrebbero.

Questo non è solo un problema di conformità: è un fallimento della sicurezza.

Se nessuno si occupa della sicurezza dell'AI, chi è responsabile quando una decisione generata dall'AI va male?

2. I modelli di AI possono essere hackerati silenziosamente

La sicurezza dell'AI non funziona come la sicurezza del software tradizionale.

▪️Invece di sfruttare il codice, gli attaccanti manipolano i dati.

▪️Iniettano dati di addestramento dannosi creando backdoor silenziose all'interno dei modelli di AI.

▪️Affinano i modelli per comportarsi normalmente fino a quando non vengono attivati.

▪️Usano l'ingegneria dei prompt per estrarre dati sensibili dalle risposte dell'AI.

I team di sicurezza non possono scansionare un modello di AI per malware.

E una volta che un modello di AI è compromesso, non lo saprai nemmeno.

3. La sicurezza in esecuzione dell'AI è inesistente

I team di sicurezza trascorrono mesi a mettere in sicurezza l'AI prima del deployment, ma poi smettono di monitorarla.

Questo è un problema.

▪️Perché le minacce dell'AI non si fermano al lancio.

▪️Gli attaccanti stanno manipolando le risposte generate dall'AI in tempo reale.

▪️Stanno iniettando prompt per bypassare i meccanismi di sicurezza.

▪️Stanno estraendo le API dell'AI per rubare le uscite dei modelli.

E in questo momento, la maggior parte dei team di sicurezza ha una visibilità minima su tutto ciò.

Quindi, cosa succede dopo?

#AI #Cybersecurity #AISecurity #CISO #Automation

2,38K

Principali

Ranking

Preferiti