Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

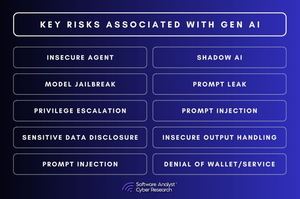

De 3 AI-säkerhetsluckorna som gör företag utsatta!

Samtalet om AI-säkerhet går snabbt.

Men det finns grundläggande luckor som företagen fortfarande inte har åtgärdat.

I vår rapport analyserade vi AI-säkerhetsrisker i olika branscher och fann att de flesta företag gör samma 3 misstag. Och dessa luckor är inte små – de omdefinierar hur cybersäkerhet måste se ut i en AI-driven värld.

1. AI-styrning saknas

De flesta organisationer har ingen insyn i hur AI används i företaget.

▪️Anställda integrerar AI-verktyg utan IT-godkännande.

▪️Säkerhetsteam kan inte spåra vilka AI-modeller som bearbetas.

▪️AI-copiloter har mer tillgång till företagsdata än de borde.

Det här är inte bara ett efterlevnadsproblem – det är ett säkerhetsfel.

Om ingen äger AI-säkerhet, vem är då ansvarig när ett AI-genererat beslut går fel?

2. AI-modeller kan hackas tyst

AI-säkerhet fungerar inte som traditionell programvarusäkerhet.

▪️I stället för att utnyttja kod manipulerar angripare data.

▪️De injicerar skadliga träningsdata och skapar tysta bakdörrar i AI-modeller.

▪️De finjusterar modeller så att de beter sig normalt tills de utlöses.

▪️De använder snabb teknik för att extrahera känsliga data från AI-svar.

Säkerhetsteam kan inte söka igenom en AI-modell efter skadlig kod.

Och när en AI-modell väl har komprometterats kommer du inte ens att märka det.

3. AI-körtidssäkerhet är obefintlig

Säkerhetsteam ägnar månader åt att säkra AI före distributionen – men slutar sedan att övervaka den.

Det är ett problem.

▪️Eftersom AI-hoten inte slutar vid lanseringen.

▪️Angripare manipulerar AI-genererade svar i realtid.

▪️De injicerar uppmaningar för att kringgå säkerhetsmekanismer.

▪️De skrapar AI-API:er för att stjäla modellutdata.

Och just nu har de flesta säkerhetsteam minimal insyn i något av detta.

Så vad händer härnäst?

#AI #Cybersecurity #AISecurity #CISO #Automation

2,37K

Topp

Rankning

Favoriter