Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

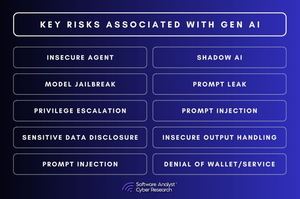

Les 3 lacunes en matière de sécurité de l'IA qui exposent les entreprises !

La conversation sur la sécurité de l'IA évolue rapidement.

Mais il existe des lacunes fondamentales que les entreprises n'ont toujours pas abordées.

Pour notre rapport, nous avons analysé les risques de sécurité liés à l'IA dans divers secteurs et constaté que la plupart des entreprises commettent les mêmes 3 erreurs. Et ces lacunes ne sont pas petites : elles redéfinissent ce à quoi la cybersécurité doit ressembler dans un monde piloté par l'IA.

1. La gouvernance de l'IA fait défaut

La plupart des organisations n'ont aucune visibilité sur la manière dont l'IA est utilisée au sein de leur entreprise.

▪️Les employés intègrent des outils d'IA sans approbation de l'informatique.

▪️Les équipes de sécurité ne peuvent pas suivre ce que les modèles d'IA traitent.

▪️Les copilotes d'IA ont plus d'accès aux données de l'entreprise qu'ils ne devraient.

Ce n'est pas seulement un problème de conformité, c'est un échec en matière de sécurité.

Si personne ne s'occupe de la sécurité de l'IA, qui est responsable lorsqu'une décision générée par l'IA tourne mal ?

2. Les modèles d'IA peuvent être piratés silencieusement

La sécurité de l'IA ne fonctionne pas comme la sécurité des logiciels traditionnels.

▪️Au lieu d'exploiter le code, les attaquants manipulent les données.

▪️Ils injectent des données d'entraînement malveillantes créant des portes dérobées silencieuses à l'intérieur des modèles d'IA.

▪️Ils ajustent les modèles pour qu'ils se comportent normalement jusqu'à ce qu'ils soient déclenchés.

▪️Ils utilisent l'ingénierie des invites pour extraire des données sensibles des réponses de l'IA.

Les équipes de sécurité ne peuvent pas scanner un modèle d'IA à la recherche de logiciels malveillants.

Et une fois qu'un modèle d'IA est compromis, vous ne le saurez même pas.

3. La sécurité d'exécution de l'IA est inexistante

Les équipes de sécurité passent des mois à sécuriser l'IA avant son déploiement, mais ensuite, elles cessent de la surveiller.

C'est un problème.

▪️Parce que les menaces liées à l'IA ne s'arrêtent pas au lancement.

▪️Les attaquants manipulent les réponses générées par l'IA en temps réel.

▪️Ils injectent des invites pour contourner les mécanismes de sécurité.

▪️Ils extraient les API d'IA pour voler les sorties des modèles.

Et en ce moment, la plupart des équipes de sécurité ont une visibilité minimale sur tout cela.

Alors, que se passe-t-il ensuite ?

#IA #Cybersécurité #SécuritéIA #CISO #Automatisation

2,37K

Meilleurs

Classement

Favoris