Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Le imprese costruiscono RAG su centinaia di fonti di dati, non su una sola!

- Microsoft lo integra nei prodotti M365.

- Google lo integra nella sua ricerca Vertex AI.

- AWS lo integra nel suo Amazon Q Business.

Costruiamo un RAG alimentato da MCP su oltre 200 fonti (100% locale):

I dati aziendali sono sparsi su molte fonti.

Oggi costruiremo un server MCP unificato che può interrogare oltre 200 fonti da un'unica interfaccia.

Stack tecnologico:

- @mcpuse per costruire un client MCP locale

- @MindsDB per connettersi alle fonti di dati

- @ollama per servire GPT-oss localmente

Iniziamo!

Ecco il flusso di lavoro:

- L'utente invia una query.

- L'agente si connette al server MindsDB MCP per trovare strumenti.

- Seleziona lo strumento appropriato in base alla query dell'utente e lo invoca.

- Infine, restituisce una risposta contestualmente rilevante.

Ora, immergiamoci nel codice!

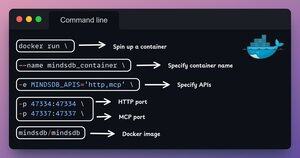

1️⃣ Configurazione di Docker

MindsDB fornisce immagini Docker che possono essere eseguite in contenitori Docker.

Installa MindsDB localmente utilizzando l'immagine Docker eseguendo il comando nel tuo terminale.

Dai un'occhiata a questo 👇

2️⃣ Avvia la GUI di MindsDB

Dopo aver installato l'immagine Docker, vai su localhost porta 47334 nel tuo browser per accedere all'editor di MindsDB.

Attraverso questa interfaccia, puoi connetterti a oltre 200 fonti di dati ed eseguire query SQL su di esse.

Dai un'occhiata a questo 👇

3️⃣ Integrare le fonti di dati

Iniziamo a costruire il nostro motore di query federato collegando le nostre fonti di dati a MindsDB.

Utilizziamo Slack, Gmail, GitHub e Hacker News come nostre fonti di dati federate.

Dai un'occhiata a questo 👇

4️⃣ Configurazione del server MCP

Dopo aver costruito il motore di query federato, uniamo le nostre fonti di dati collegandole al server MCP di MindsDB.

Aggiungi la configurazione del server MCP a un file JSON come mostrato di seguito.

Dai un'occhiata a questo 👇

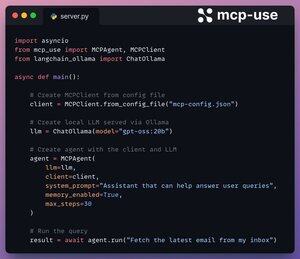

5️⃣ Collega il client al server

Impostiamo il nostro client locale tramite mcp-use e lo colleghiamo al server MCP con solo 4 righe di codice.

1. Inizializza il client MCP da un file di configurazione.

2. Collega il LLM locale tramite Ollama.

3. Crea un Agente utilizzando LLM e Client.

4. Esegui la query.

Controlla questo 👇

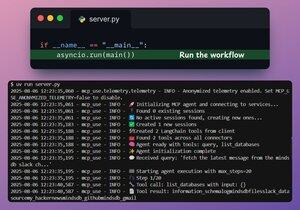

Fatto!

Il nostro server MindsDB MCP è ora connesso a un client locale tramite mcp-use!

Offre due strumenti:

- list_databases: Elenca tutte le fonti di dati connesse a MindsDB.

- query: Risponde alle domande degli utenti sui dati federati.

Controlla questo 👇

Infine, racchiudiamo la nostra configurazione in un'interfaccia Streamlit, dove possiamo modificare dinamicamente la configurazione MCP e chattare direttamente con l'agente.

Guarda questa demo👇

È tutto!

Se lo hai trovato interessante, condividilo con la tua rete.

Trova me → @_avichawla

Ogni giorno, condivido tutorial e approfondimenti su DS, ML, LLM e RAG.

8 ago, 14:33

Le imprese costruiscono RAG su centinaia di fonti di dati, non su una sola!

- Microsoft lo integra nei prodotti M365.

- Google lo integra nella sua ricerca Vertex AI.

- AWS lo integra nel suo Amazon Q Business.

Costruiamo un RAG alimentato da MCP su oltre 200 fonti (100% locale):

104,94K

Principali

Ranking

Preferiti