Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Bedrifter bygger RAG over 100-vis av datakilder, ikke én!

- Microsoft leverer den i M365-produkter.

- Google sender den i sitt Vertex AI Search.

- AWS sender den i sin Amazon Q Business.

La oss bygge en MCP-drevet RAG over 200+ kilder (100 % lokale):

Virksomhetsdata er spredt over mange kilder.

I dag skal vi bygge en enhetlig MCP-server som kan spørre 200+ kilder fra ett grensesnitt.

Teknisk stabel:

- @mcpuse bygge en lokal MCP-klient

- @MindsDB for å koble til datakilder

- @ollama betjene GPT-oss lokalt

La oss begynne!

Her er arbeidsflyten:

- Brukeren sender inn en spørring.

- Agenten kobler seg til MindsDB MCP-serveren for å finne verktøy.

- Velger riktig verktøy basert på brukerens spørring og påkaller den

- Til slutt returnerer den et kontekstuelt relevant svar

La oss nå dykke ned i koden!

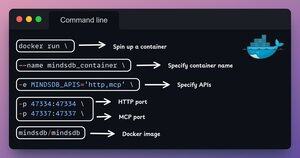

1️⃣ Docker-oppsett

MindsDB gir Docker-bilder som kan kjøres i Docker-containere.

Installer MindsDB lokalt ved å bruke Docker-bildet ved å kjøre kommandoen i terminalen.

Sjekk dette ut 👇

2️⃣ Start MindsDB GUI

Etter å ha installert Docker-bildet, gå til localhost-port 47334 i nettleseren din for å få tilgang til MindsDB-editoren.

Gjennom dette grensesnittet kan du koble til over 200 datakilder og kjøre SQL-spørringer mot dem.

Sjekk dette ut 👇

3️⃣ Integrer datakilder

La oss begynne å bygge vår fødererte spørringsmotor ved å koble datakildene våre til MindsDB.

Vi bruker Slack, Gmail, GitHub og Hacker News som våre samlede datakilder.

Sjekk dette ut 👇

4️⃣ MCP-serverkonfigurasjon

Etter å ha bygget den fødererte spørringsmotoren, la oss forene datakildene våre ved å koble dem til MindsDBs MCP-server.

Legg til MCP-serverkonfigurasjonen i en JSON-fil som vist nedenfor.

Sjekk dette ut 👇

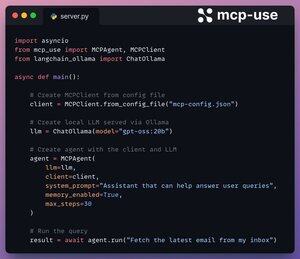

5️⃣ Koble klient til server

Vi setter opp vår lokale klient via mcp-bruk og kobler den til MCP-serveren med bare 4 linjer med kode.

1. Initialiser MCP-klienten fra en konfigurasjonsfil.

2. Koble til lokal LLM via Ollama.

3. Opprett agent ved hjelp av LLM og klient.

4. Kjør spørringen.

Sjekk dette 👇

Gjort!

Vår MindsDB MCP-server er nå koblet til en lokal klient via mcp-bruk!

Den tilbyr to verktøy:

- list_databases: Viser alle datakilder som er koblet til MindsDB.

- spørring: Svarer på brukerspørsmål om de fødererte dataene.

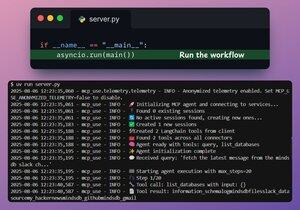

Sjekk dette 👇

Til slutt pakker vi oppsettet vårt inn i et Streamlit-grensesnitt, der vi dynamisk kan endre MCP-konfigurasjonen og chatte direkte med agenten.

Sjekk denne demoen👇

Det er en innpakning!

Hvis du syntes det var innsiktsfullt, kan du dele det på nytt med nettverket ditt.

Finn meg → @_avichawla

Hver dag deler jeg opplæringsprogrammer og innsikt om DS, ML, LLM-er og RAG-er.

8. aug., 14:33

Bedrifter bygger RAG over 100-vis av datakilder, ikke én!

- Microsoft leverer den i M365-produkter.

- Google sender den i sitt Vertex AI Search.

- AWS sender den i sin Amazon Q Business.

La oss bygge en MCP-drevet RAG over 200+ kilder (100 % lokale):

104,93K

Topp

Rangering

Favoritter