Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Przedsiębiorstwa budują RAG na podstawie setek źródeł danych, a nie jednego!

- Microsoft dostarcza to w produktach M365.

- Google dostarcza to w swoim Vertex AI Search.

- AWS dostarcza to w swoim Amazon Q Business.

Zbudujmy RAG zasilany MCP na podstawie 200+ źródeł (100% lokalnie):

Dane przedsiębiorstwa są rozproszone w wielu źródłach.

Dziś zbudujemy zjednoczony serwer MCP, który może zapytywać ponad 200 źródeł z jednego interfejsu.

Stos technologiczny:

- @mcpuse do zbudowania lokalnego klienta MCP

- @MindsDB do łączenia z źródłami danych

- @ollama do lokalnego serwowania GPT-oss

Zacznijmy!

Oto workflow:

- Użytkownik przesyła zapytanie.

- Agent łączy się z serwerem MindsDB MCP, aby znaleźć narzędzia.

- Wybiera odpowiednie narzędzie na podstawie zapytania użytkownika i je uruchamia.

- Na koniec zwraca kontekstowo odpowiednią odpowiedź.

Teraz zanurzmy się w kod!

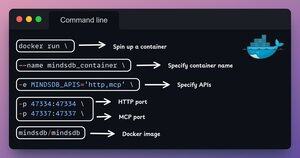

1️⃣ Ustawienie Dockera

MindsDB oferuje obrazy Dockera, które można uruchomić w kontenerach Docker.

Zainstaluj MindsDB lokalnie, używając obrazu Dockera, uruchamiając polecenie w swoim terminalu.

Sprawdź to 👇

2️⃣ Uruchom interfejs graficzny MindsDB

Po zainstalowaniu obrazu Docker, przejdź do portu 47334 na localhost w swojej przeglądarce, aby uzyskać dostęp do edytora MindsDB.

Za pomocą tego interfejsu możesz połączyć się z ponad 200 źródłami danych i wykonywać zapytania SQL przeciwko nim.

Sprawdź to 👇

3️⃣ Zintegruj źródła danych

Zacznijmy budować nasz silnik zapytań federacyjnych, łącząc nasze źródła danych z MindsDB.

Używamy Slacka, Gmaila, GitHuba i Hacker News jako naszych federacyjnych źródeł danych.

Sprawdź to 👇

4️⃣ Konfiguracja serwera MCP

Po zbudowaniu silnika zapytań federacyjnych, połączmy nasze źródła danych z serwerem MCP MindsDB.

Dodaj konfigurację serwera MCP do pliku JSON, jak pokazano poniżej.

Sprawdź to 👇

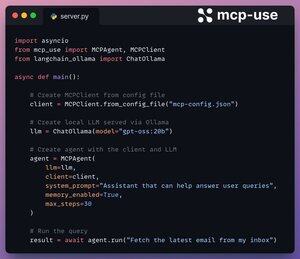

5️⃣ Połącz klienta z serwerem

Konfigurujemy naszego lokalnego klienta za pomocą mcp-use i łączymy go z serwerem MCP w zaledwie 4 linijkach kodu.

1. Zainicjalizuj klienta MCP z pliku konfiguracyjnego.

2. Połącz lokalny LLM za pomocą Ollama.

3. Utwórz Agenta używając LLM i Klienta.

4. Uruchom zapytanie.

Sprawdź to 👇

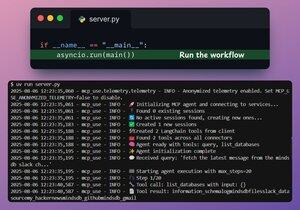

Zrobione!

Nasz serwer MindsDB MCP jest teraz połączony z lokalnym klientem za pomocą mcp-use!

Oferuje dwa narzędzia:

- list_databases: Wyświetla wszystkie źródła danych połączone z MindsDB.

- query: Odpowiada na zapytania użytkowników dotyczące zfederowanych danych.

Sprawdź to 👇

Na koniec opakowujemy naszą konfigurację w interfejs Streamlit, gdzie możemy dynamicznie zmieniać konfigurację MCP i rozmawiać bezpośrednio z agentem.

Sprawdź tę demonstrację👇

To koniec!

Jeśli uznałeś to za pouczające, podziel się tym ze swoją siecią.

Znajdź mnie → @_avichawla

Codziennie dzielę się samouczkami i spostrzeżeniami na temat DS, ML, LLM i RAG.

8 sie, 14:33

Przedsiębiorstwa budują RAG na podstawie setek źródeł danych, a nie jednego!

- Microsoft dostarcza to w produktach M365.

- Google dostarcza to w swoim Vertex AI Search.

- AWS dostarcza to w swoim Amazon Q Business.

Zbudujmy RAG zasilany MCP na podstawie 200+ źródeł (100% lokalnie):

104,97K

Najlepsze

Ranking

Ulubione