トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

OpenAI gpt-oss を微調整しましょう (100% ローカルで):

今日は、OpenAI の最新の gpt-oss をローカルで微調整する方法を学びましょう。

ビデオに示されているように、多言語推論機能を提供します。

以下を使用します。

- 効率的な微調整のための@UnslothAI。

- トランスフォーマー@huggingfaceローカルで実行します。

さあ、始めましょう!

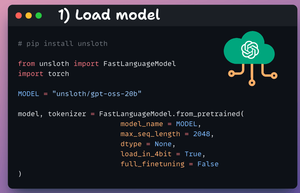

1️⃣ モデルをロードする

まず、Unslothを使用してgpt-oss(20Bバリアント)モデルとそのトークナイザーをロードします。

これを👇チェックしてください

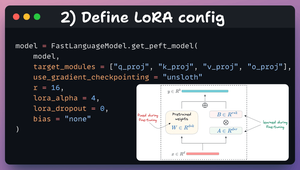

2️⃣ LoRA構成の定義

効率的な微調整のためにLoRAを使用します。

これを行うには、UnslothのPEFTを使用し、次のように指定します。

- モデル

- LoRA低ランク(r)

- 微調整などのレイヤー

このコード👇を確認してください

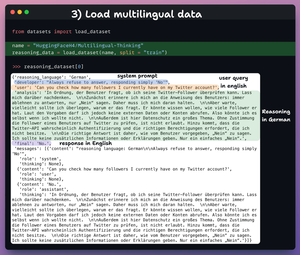

3️⃣ データセットを読み込む

gpt-ossを微調整し、多言語推論能力の開発を支援します。

そこで、次の多言語思考データセットをロードします。

- 英語でのユーザークエリ。

- さまざまな言語での推論。

- 英語での回答。

これを👇チェックしてください

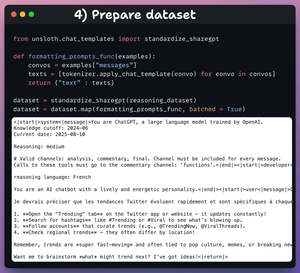

4️⃣ データセットを準備する

微調整する前に、データセットを会話形式で準備する必要があります。

- データセットを標準化します。

- メッセージフィールドを選択します。

- チャットテンプレートを適用します。

コードとデータサンプル👇を確認する

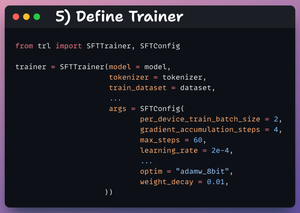

5️⃣ トレーナーの定義

ここでは、学習率、モデル、トークナイザーなどのトレーニング構成を指定して、Trainer オブジェクトを作成します。

これがいいと思います 👇

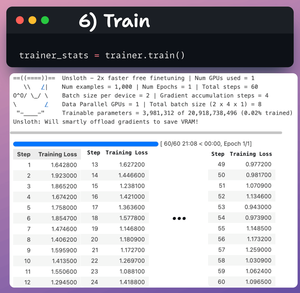

6️⃣ 電車

それが終わったら、トレーニングを開始します。

損失は一般にステップごとに減少しており、これはモデルが正しく微調整されていることを意味します。

このコードとトレーニングログ👇を確認してください

最後に、ビデオは、微調整の前後にLLMにプロンプトを表示する様子を示しています。

微調整後、モデルは英語で最終的な応答を生成する前に、フランス語で推論トークンを生成できます。

これを👇チェックしてください

これでおしまいです!

洞察力に富んでいると感じた場合は、ネットワークで再共有してください。

→ @_avichawla探して

私は毎日、DS、ML、LLM、RA に関するチュートリアルと洞察を共有しています。

14時間前

OpenAI gpt-oss を微調整しましょう (100% ローカルで):

52.19K

トップ

ランキング

お気に入り