Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La oss finjustere OpenAI gpt-oss (100 % lokalt):

I dag, la oss lære hvordan du finjusterer OpenAIs siste gpt-oss lokalt.

Vi vil gi den flerspråklige resonneringsmuligheter som vist i videoen.

Vi bruker:

- @UnslothAI for effektiv finjustering.

- @huggingface transformatorer for å kjøre den lokalt.

La oss begynne!

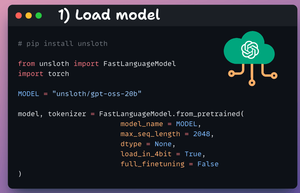

1️⃣ Last inn modellen

Vi starter med å laste inn gpt-oss-modellen (20B-varianten) og dens tokenizer ved hjelp av Unsloth.

Sjekk dette 👇

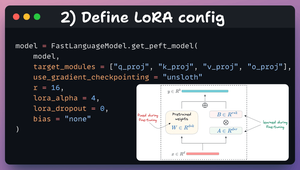

2️⃣ Definer LoRA-konfigurasjon

Vi bruker LoRA for effektiv finjustering.

For å gjøre dette bruker vi Unsloths PEFT og spesifiserer:

- Modellen

- LoRA lav rang (r)

- Lag for finjustering osv.

Sjekk denne koden 👇

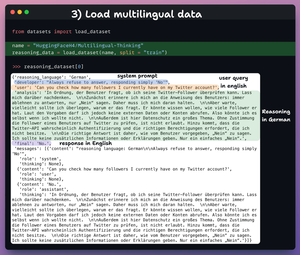

3️⃣ Last inn datasett

Vi finjusterer gpt-oss og hjelper den med å utvikle flerspråklige resonneringsevner.

Så vi laster inn datasettet for flerspråklig tenkning, som har:

- Brukerspørring på engelsk.

- Resonnement på forskjellige språk.

- Svar på engelsk.

Sjekk dette 👇

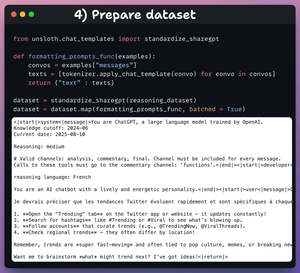

4️⃣ Klargjør datasett

Før vi finjusterer, må vi klargjøre datasettet i et samtaleformat:

- Vi standardiserer datasettet.

- Vi velger meldingsfeltet.

- Vi bruker chat-malen på den.

Sjekk koden og et dataeksempel 👇

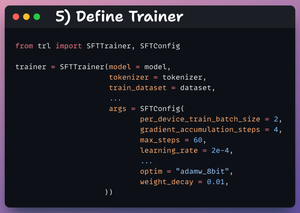

5️⃣ Definer trener

Her oppretter vi et Trainer-objekt ved å spesifisere treningskonfigurasjonen, for eksempel læringshastighet, modell, tokenisering og mer.

Sjekk dette ut 👇

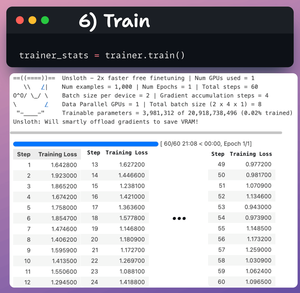

6️⃣ Tog

Når det er gjort, setter vi i gang opplæring.

Tapet avtar generelt med trinn, noe som betyr at modellen blir finjustert riktig.

Sjekk denne koden og treningsloggene 👇

Til slutt viser videoen at du ber LLM før og etter finjustering.

Etter finjustering er modellen i stand til å generere resonnementtokenene på fransk før den genererer det endelige svaret på engelsk.

Sjekk dette 👇

Det er en innpakning!

Hvis du syntes det var innsiktsfullt, kan du dele det på nytt med nettverket ditt.

Finn meg → @_avichawla

Hver dag deler jeg opplæringsprogrammer og innsikt om DS, ML, LLM-er og RAG-er.

13 timer siden

La oss finjustere OpenAI gpt-oss (100 % lokalt):

52,16K

Topp

Rangering

Favoritter