Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dostosujmy OpenAI gpt-oss (100% lokalnie):

Dziś nauczymy się, jak lokalnie dostosować najnowszy model gpt-oss od OpenAI.

Nadamy mu wielojęzyczne zdolności rozumowania, jak pokazano w filmie.

Użyjemy:

- @UnslothAI do efektywnego dostosowywania.

- @huggingface transformers, aby uruchomić go lokalnie.

Zaczynajmy!

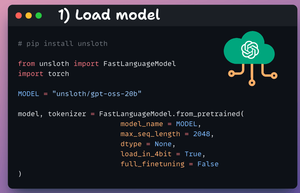

1️⃣ Załaduj model

Zaczynamy od załadowania modelu gpt-oss (wariant 20B) oraz jego tokenizera przy użyciu Unsloth.

Sprawdź to 👇

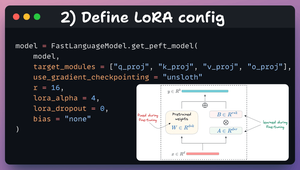

2️⃣ Zdefiniuj konfigurację LoRA

Użyjemy LoRA do efektywnego dostrajania.

Aby to zrobić, korzystamy z PEFT Unsloth i określamy:

- Model

- Niski ranga LoRA (r)

- Warstwy do dostrajania itp.

Sprawdź ten kod 👇

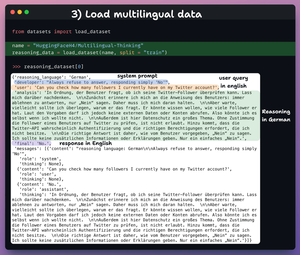

3️⃣ Załaduj zestaw danych

Dostosujemy gpt-oss i pomożemy mu rozwijać zdolności wielojęzycznego rozumowania.

Więc ładujemy zestaw danych do myślenia wielojęzycznego, który zawiera:

- Zapytanie użytkownika w języku angielskim.

- Rozumowanie w różnych językach.

- Odpowiedź w języku angielskim.

Sprawdź to 👇

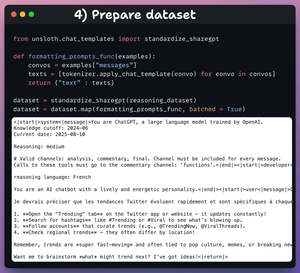

4️⃣ Przygotuj zestaw danych

Przed dostosowaniem musimy przygotować zestaw danych w formacie konwersacyjnym:

- Standaryzujemy zestaw danych.

- Wybieramy pole wiadomości.

- Stosujemy do niego szablon czatu.

Sprawdź kod i próbkę danych 👇

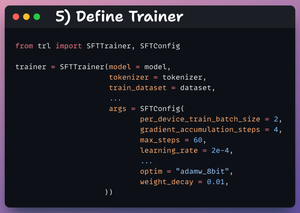

5️⃣ Zdefiniuj Trenera

Tutaj tworzymy obiekt Trenera, określając konfigurację treningu, taką jak współczynnik uczenia, model, tokenizer i inne.

Sprawdź to 👇

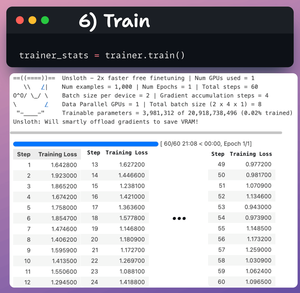

6️⃣ Trening

Po zakończeniu tego etapu rozpoczynamy trening.

Strata generalnie maleje z każdym krokiem, co oznacza, że model jest odpowiednio dostrajany.

Sprawdź ten kod i logi treningowe 👇

Na koniec wideo pokazuje, jak wywołać LLM przed i po dostosowaniu.

Po dostosowaniu model jest w stanie generować tokeny rozumowania po francusku, zanim wygeneruje ostateczną odpowiedź po angielsku.

Sprawdź to 👇

To koniec!

Jeśli uznałeś to za pouczające, podziel się tym ze swoją siecią.

Znajdź mnie → @_avichawla

Codziennie dzielę się samouczkami i spostrzeżeniami na temat DS, ML, LLM i RAG.

16 godz. temu

Dostosujmy OpenAI gpt-oss (100% lokalnie):

52,2K

Najlepsze

Ranking

Ulubione