Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Análise independente de modelos de IA e provedores de hospedagem - escolha o melhor modelo e provedor de API para seu caso de uso

A DeepSeek lança a V3.1, unificando a V3 e a R1 em um modelo híbrido de raciocínio com um aumento incremental na inteligência

Aumento incremental de inteligência: Os resultados iniciais de benchmark para a DeepSeek V3.1 mostram um Índice de Inteligência de Análise Artificial de 60 em modo de raciocínio, acima da pontuação de 59 da R1. Em modo não-raciocínio, a V3.1 alcança uma pontuação de 49, um aumento maior em relação à pontuação anterior da V3 0324 de 44. Isso deixa a V3.1 (raciocínio) atrás do Qwen3 235B 2507 (raciocínio) da Alibaba - a DeepSeek não recuperou a liderança.

Raciocínio híbrido: @deepseek_ai mudou para um modelo híbrido de raciocínio pela primeira vez - suportando tanto modos de raciocínio quanto não-raciocínio. A mudança da DeepSeek para um modelo híbrido unificado imita a abordagem adotada pela OpenAI, Anthropic e Google. É interessante notar, no entanto, que a Alibaba recentemente abandonou a abordagem híbrida que favorecia para o Qwen3 com seus lançamentos separados dos modelos de raciocínio e instrução do Qwen3 2507.

Chamada de função / uso de ferramentas: Embora a DeepSeek afirme ter melhorado a chamada de função para o modelo, a DeepSeek V3.1 não suporta chamada de função quando em modo de raciocínio. Isso provavelmente limitará substancialmente sua capacidade de suportar fluxos de trabalho agentes com requisitos de inteligência, incluindo em agentes de codificação.

Uso de tokens: A DeepSeek V3.1 pontua incrementalmente mais alto em modo de raciocínio do que a DeepSeek R1, e usa ligeiramente menos tokens nos evals que usamos para o Índice de Inteligência de Análise Artificial. Em modo não-raciocínio, usa ligeiramente mais tokens do que a V3 0324 - mas ainda assim várias vezes menos do que em seu próprio modo de raciocínio.

API: A API de primeira parte da DeepSeek agora serve o novo modelo DeepSeek V3.1 em seus endpoints de chat e raciocínio - simplesmente mudando se o token de pensamento final </think> é fornecido ao modelo no template de chat para controlar se o modelo irá raciocinar.

Arquitetura: A DeepSeek V3.1 é arquitetonicamente idêntica aos modelos anteriores V3 e R1, com 671B de parâmetros totais e 37B de parâmetros ativos.

Implicações: Aconselharíamos cautela ao fazer quaisquer suposições sobre o que este lançamento implica sobre o progresso da DeepSeek em direção a um futuro modelo referido em rumores como V4 ou R2. Notamos que a DeepSeek lançou anteriormente o modelo final construído em sua arquitetura V2 em 10 de dezembro de 2024, apenas duas semanas antes de lançar a V3.

71,23K

Anunciando a Análise Artificial de Raciocínio de Longo Contexto (AA-LCR), um novo benchmark para avaliar o desempenho em contextos longos através da testagem das capacidades de raciocínio em múltiplos documentos longos (~100k tokens)

O foco da AA-LCR é replicar o trabalho real de conhecimento e tarefas de raciocínio, testando capacidades críticas para aplicações modernas de IA que abrangem análise de documentos, compreensão de bases de código e fluxos de trabalho complexos de múltiplos passos.

AA-LCR consiste em 100 perguntas difíceis baseadas em texto que requerem raciocínio através de múltiplos documentos do mundo real que representam ~100k tokens de entrada. As perguntas são projetadas de forma que as respostas não possam ser encontradas diretamente, mas devem ser inferidas a partir de múltiplas fontes de informação, com testes humanos verificando que cada pergunta requer uma inferência genuína em vez de recuperação.

Principais conclusões:

➤ Os modelos líderes de hoje alcançam ~70% de precisão: os três primeiros lugares vão para OpenAI o3 (69%), xAI Grok 4 (68%) e Qwen3 235B 2507 Thinking (67%)

➤👀 Também já temos resultados do gpt-oss! 120B apresenta desempenho próximo ao o4-mini (alto), alinhado com as alegações da OpenAI sobre o desempenho do modelo. Em breve, seguiremos com um Índice de Inteligência para os modelos.

➤ 100 perguntas difíceis baseadas em texto abrangendo 7 categorias de documentos (Relatórios de Empresas, Relatórios da Indústria, Consultas Governamentais, Academia, Legal, Materiais de Marketing e Relatórios de Pesquisa)

➤ ~100k tokens de entrada por pergunta, exigindo que os modelos suportem uma janela de contexto mínima de 128K para pontuar neste benchmark

➤ ~3M de tokens de entrada únicos abrangendo ~230 documentos para executar o benchmark (os tokens de saída geralmente variam por modelo)

➤ O link para o conjunto de dados no 🤗 @HuggingFace está abaixo

Estamos adicionando a AA-LCR ao Índice de Inteligência da Análise Artificial, e elevando o número da versão para v2.2. O Índice de Inteligência da Análise Artificial v2.2 agora inclui: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode e AA-LCR.

Todos os números estão atualizados no site agora. Descubra quais modelos estão no Índice de Inteligência da Análise Artificial v2.2 👇

28,96K

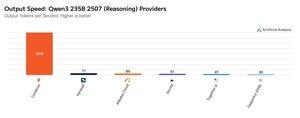

A Cerebras tem demonstrado a sua capacidade de hospedar grandes MoEs a velocidades muito altas esta semana, lançando os endpoints Qwen3 235B 2507 e Qwen3 Coder 480B a >1.500 tokens de saída/s

➤ @CerebrasSystems agora oferece endpoints para ambos Qwen3 235B 2507 Raciocínio & Não-raciocínio. Ambos os modelos têm 235B de parâmetros totais com 22B ativos.

➤ O Qwen 3 235B 2507 Raciocínio oferece inteligência comparável ao o4-mini (alto) & DeepSeek R1 0528. A variante Não-raciocínio oferece inteligência comparável ao Kimi K2 e bem acima do GPT-4.1 e Llama 4 Maverick.

➤ O Qwen3 Coder 480B tem 480B de parâmetros totais com 35B ativos. Este modelo é particularmente forte para codificação agentiva e pode ser usado em uma variedade de ferramentas de agentes de codificação, incluindo o Qwen3-Coder CLI.

Os lançamentos da Cerebras representam a primeira vez que este nível de inteligência tem estado acessível a estas velocidades de saída e têm o potencial de desbloquear novos casos de uso - como usar um modelo de raciocínio para cada passo de um agente sem ter que esperar minutos.

25,38K

Top

Classificação

Favoritos