Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Phân tích độc lập các mô hình AI và nhà cung cấp dịch vụ lưu trữ - chọn mô hình và nhà cung cấp API tốt nhất cho trường hợp sử dụng của bạn

DeepSeek ra mắt V3.1, hợp nhất V3 và R1 thành một mô hình lý luận lai với sự gia tăng trí tuệ theo từng bước

Gia tăng trí tuệ theo từng bước: Kết quả đánh giá ban đầu cho DeepSeek V3.1 cho thấy Chỉ số Trí tuệ Phân tích Nhân tạo là 60 trong chế độ lý luận, tăng từ điểm số 59 của R1. Trong chế độ không lý luận, V3.1 đạt điểm 49, một sự gia tăng lớn hơn so với điểm số 44 của V3 0324 trước đó. Điều này khiến V3.1 (lý luận) tụt lại phía sau Qwen3 235B 2507 (lý luận) mới nhất của Alibaba - DeepSeek vẫn chưa lấy lại vị thế dẫn đầu.

Lý luận lai: @deepseek_ai đã chuyển sang mô hình lý luận lai lần đầu tiên - hỗ trợ cả chế độ lý luận và không lý luận. Việc DeepSeek chuyển sang mô hình lý luận lai thống nhất mô phỏng cách tiếp cận của OpenAI, Anthropic và Google. Tuy nhiên, điều thú vị là Alibaba gần đây đã từ bỏ cách tiếp cận lai mà họ ưa chuộng cho Qwen3 với các phiên bản riêng biệt của các mô hình lý luận và hướng dẫn Qwen3 2507.

Gọi hàm / sử dụng công cụ: Trong khi DeepSeek tuyên bố cải thiện việc gọi hàm cho mô hình, DeepSeek V3.1 không hỗ trợ gọi hàm khi ở chế độ lý luận. Điều này có thể hạn chế đáng kể khả năng hỗ trợ các quy trình làm việc có yêu cầu trí tuệ, bao gồm cả trong các tác nhân lập trình.

Sử dụng token: DeepSeek V3.1 ghi điểm cao hơn một chút trong chế độ lý luận so với DeepSeek R1, và sử dụng ít token hơn một chút trong các đánh giá mà chúng tôi sử dụng cho Chỉ số Trí tuệ Phân tích Nhân tạo. Trong chế độ không lý luận, nó sử dụng nhiều token hơn một chút so với V3 0324 - nhưng vẫn ít hơn nhiều lần so với trong chế độ lý luận của chính nó.

API: API của bên thứ nhất của DeepSeek hiện phục vụ mô hình DeepSeek V3.1 mới trên cả hai điểm cuối trò chuyện và lý luận - chỉ cần thay đổi xem token suy nghĩ cuối cùng </think> có được cung cấp cho mô hình trong mẫu trò chuyện hay không để kiểm soát xem mô hình có lý luận hay không.

Kiến trúc: DeepSeek V3.1 về kiến trúc là giống hệt với các mô hình V3 và R1 trước đó, với tổng số tham số là 671B và 37B tham số hoạt động.

Hệ quả: Chúng tôi khuyên bạn nên thận trọng khi đưa ra bất kỳ giả định nào về những gì bản phát hành này ngụ ý về tiến trình của DeepSeek hướng tới một mô hình tương lai được đề cập trong các tin đồn là V4 hoặc R2. Chúng tôi lưu ý rằng DeepSeek đã phát hành mô hình cuối cùng được xây dựng trên kiến trúc V2 của họ vào ngày 10 tháng 12 năm 2024, chỉ hai tuần trước khi phát hành V3.

71,23K

Thông báo Phân tích Nhân tạo Lý luận Ngữ cảnh Dài (AA-LCR), một tiêu chuẩn mới để đánh giá hiệu suất ngữ cảnh dài thông qua việc kiểm tra khả năng lý luận trên nhiều tài liệu dài (~100k token)

Trọng tâm của AA-LCR là tái hiện công việc kiến thức thực tế và các nhiệm vụ lý luận, kiểm tra khả năng quan trọng đối với các ứng dụng AI hiện đại trải rộng từ phân tích tài liệu, hiểu biết về mã nguồn, đến các quy trình làm việc phức tạp nhiều bước.

AA-LCR bao gồm 100 câu hỏi khó dựa trên văn bản yêu cầu lý luận qua nhiều tài liệu thực tế đại diện cho ~100k token đầu vào. Các câu hỏi được thiết kế sao cho câu trả lời không thể được tìm thấy trực tiếp mà phải được lý luận từ nhiều nguồn thông tin, với việc kiểm tra của con người xác minh rằng mỗi câu hỏi yêu cầu suy luận thực sự thay vì chỉ là truy xuất.

Những điểm chính:

➤ Các mô hình hàng đầu hiện nay đạt ~70% độ chính xác: ba vị trí hàng đầu thuộc về OpenAI o3 (69%), xAI Grok 4 (68%) và Qwen3 235B 2507 Thinking (67%)

➤👀 Chúng tôi cũng đã có kết quả gpt-oss! 120B hoạt động gần với o4-mini (cao), phù hợp với các tuyên bố của OpenAI về hiệu suất mô hình. Chúng tôi sẽ sớm theo dõi với một Chỉ số Trí tuệ cho các mô hình.

➤ 100 câu hỏi khó dựa trên văn bản trải dài 7 loại tài liệu (Báo cáo Công ty, Báo cáo Ngành, Tư vấn Chính phủ, Học thuật, Pháp lý, Tài liệu Tiếp thị và Báo cáo Khảo sát)

➤ ~100k token đầu vào cho mỗi câu hỏi, yêu cầu các mô hình hỗ trợ cửa sổ ngữ cảnh tối thiểu 128K để ghi điểm trên tiêu chuẩn này

➤ ~3M token đầu vào duy nhất trải dài ~230 tài liệu để chạy tiêu chuẩn (token đầu ra thường thay đổi theo mô hình)

➤ Liên kết đến tập dữ liệu trên 🤗 @HuggingFace ở dưới

Chúng tôi đang thêm AA-LCR vào Chỉ số Trí tuệ Phân tích Nhân tạo, và nâng số phiên bản lên v2.2. Chỉ số Trí tuệ Phân tích Nhân tạo v2.2 hiện bao gồm: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode và AA-LCR.

Tất cả các số liệu đã được cập nhật trên trang web. Tìm hiểu xem các mô hình nào có trong Chỉ số Trí tuệ Phân tích Nhân tạo v2.2 👇

28,96K

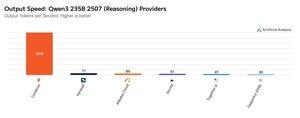

Cerebras đã chứng minh khả năng của mình trong việc lưu trữ các MoE lớn với tốc độ rất cao trong tuần này, ra mắt các điểm cuối Qwen3 235B 2507 và Qwen3 Coder 480B với tốc độ >1.500 token đầu ra/s

➤ @CerebrasSystems hiện cung cấp các điểm cuối cho cả Qwen3 235B 2507 Lý luận & Không lý luận. Cả hai mô hình đều có tổng cộng 235B tham số với 22B đang hoạt động.

➤ Qwen 3 235B 2507 Lý luận cung cấp trí thông minh tương đương với o4-mini (cao) & DeepSeek R1 0528. Biến thể Không lý luận cung cấp trí thông minh tương đương với Kimi K2 và cao hơn nhiều so với GPT-4.1 và Llama 4 Maverick.

➤ Qwen3 Coder 480B có tổng cộng 480B tham số với 35B đang hoạt động. Mô hình này đặc biệt mạnh cho lập trình agentic và có thể được sử dụng trong nhiều công cụ lập trình agent, bao gồm cả Qwen3-Coder CLI.

Các sản phẩm ra mắt của Cerebras đại diện cho lần đầu tiên mức độ trí thông minh này có thể truy cập với tốc độ đầu ra như vậy và có tiềm năng mở khóa các trường hợp sử dụng mới - như việc sử dụng mô hình lý luận cho mỗi bước của một agent mà không cần phải chờ đợi hàng phút.

25,38K

Hàng đầu

Thứ hạng

Yêu thích