Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Unabhängige Analyse von KI-Modellen und Hosting-Providern - wählen Sie das beste Modell und den besten API-Anbieter für Ihren Anwendungsfall

Ankündigung der Artificial Analysis Long Context Reasoning (AA-LCR), einem neuen Benchmark zur Bewertung der Leistung bei langen Kontexten durch Testen der Denkfähigkeiten über mehrere lange Dokumente (~100k Tokens)

Der Fokus von AA-LCR liegt darauf, reale Wissensarbeit und Denkaufgaben zu replizieren, die eine kritische Fähigkeit für moderne KI-Anwendungen umfassen, die Dokumentenanalyse, Codeverständnis und komplexe mehrstufige Arbeitsabläufe umfassen.

AA-LCR besteht aus 100 schwierigen textbasierten Fragen, die ein Denken über mehrere reale Dokumente erfordern, die ~100k Eingabetokens repräsentieren. Die Fragen sind so gestaltet, dass die Antworten nicht direkt gefunden werden können, sondern aus mehreren Informationsquellen abgeleitet werden müssen, wobei menschliche Tests bestätigen, dass jede Frage echte Schlussfolgerungen erfordert und nicht nur das Abrufen von Informationen.

Wichtige Erkenntnisse:

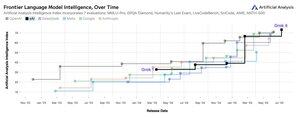

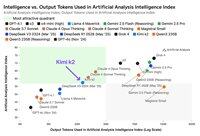

➤ Die führenden Modelle von heute erreichen eine Genauigkeit von ~70 %: Die ersten drei Plätze gehen an OpenAI o3 (69 %), xAI Grok 4 (68 %) und Qwen3 235B 2507 Thinking (67 %)

➤👀 Wir haben auch bereits gpt-oss Ergebnisse! 120B schneidet nahe an o4-mini (hoch) ab, im Einklang mit den Behauptungen von OpenAI bezüglich der Modellleistung. Wir werden in Kürze mit einem Intelligence Index für die Modelle nachlegen.

➤ 100 schwierige textbasierte Fragen, die sich über 7 Kategorien von Dokumenten erstrecken (Unternehmensberichte, Branchenberichte, Regierungsberatungen, Akademia, Recht, Marketingmaterialien und Umfrageberichte)

➤ ~100k Tokens Eingabe pro Frage, was erfordert, dass Modelle ein Mindestmaß von 128K Kontextfenster unterstützen, um in diesem Benchmark zu punkten

➤ ~3M insgesamt einzigartige Eingabetokens, die sich über ~230 Dokumente erstrecken, um den Benchmark durchzuführen (Ausgabetokens variieren typischerweise je nach Modell)

➤ Link zum Datensatz auf 🤗 @HuggingFace ist unten

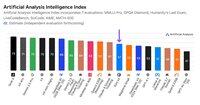

Wir fügen AA-LCR zum Artificial Analysis Intelligence Index hinzu und erhöhen die Versionsnummer auf v2.2. Der Artificial Analysis Intelligence Index v2.2 umfasst jetzt: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode und AA-LCR.

Alle Zahlen sind jetzt auf der Website aktualisiert. Finden Sie heraus, welche Modelle im Artificial Analysis Intelligence Index v2.2 👇

28,56K

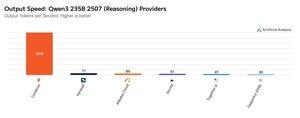

Cerebras hat diese Woche seine Fähigkeit demonstriert, große MoEs mit sehr hohen Geschwindigkeiten zu hosten, indem es die Endpunkte Qwen3 235B 2507 und Qwen3 Coder 480B mit >1.500 Ausgabetokens/s gestartet hat.

➤ @CerebrasSystems bietet jetzt Endpunkte für sowohl Qwen3 235B 2507 Reasoning als auch Non-reasoning an. Beide Modelle haben insgesamt 235B Parameter mit 22B aktiv.

➤ Qwen 3 235B 2507 Reasoning bietet eine Intelligenz, die mit o4-mini (hoch) und DeepSeek R1 0528 vergleichbar ist. Die Non-reasoning-Variante bietet eine Intelligenz, die mit Kimi K2 vergleichbar ist und weit über GPT-4.1 und Llama 4 Maverick liegt.

➤ Qwen3 Coder 480B hat insgesamt 480B Parameter mit 35B aktiv. Dieses Modell ist besonders stark für agentisches Codieren und kann in einer Vielzahl von Codierungsagenten-Tools verwendet werden, einschließlich der Qwen3-Coder CLI.

Die Starts von Cerebras stellen das erste Mal dar, dass dieses Niveau an Intelligenz zu diesen Ausgabegeschwindigkeiten zugänglich ist und das Potenzial hat, neue Anwendungsfälle zu erschließen - wie die Verwendung eines Reasoning-Modells für jeden Schritt eines Agenten, ohne Minuten warten zu müssen.

25,12K

🇰🇷 LG hat kürzlich EXAONE 4.0 32B auf den Markt gebracht - es erzielt 62 im Artificial Analysis Intelligence Index, der höchste Wert für ein 32B-Modell bisher.

@LG_AI_Research's EXAONE 4.0 wird in zwei Varianten veröffentlicht: dem 32B Hybrid-Reasoning-Modell, für das wir hier Benchmark-Ergebnisse berichten, und einem kleineren 1,2B-Modell, das für Anwendungen auf Geräten konzipiert ist und das wir noch nicht getestet haben.

Neben der kürzlichen Veröffentlichung von Upstage's Solar Pro 2 ist es spannend zu sehen, wie koreanische KI-Labore sich an die Spitze der Intelligenz-Charts neben den USA und China gesellen.

Wichtige Ergebnisse:

➤ 🧠 EXAONE 4.0 32B (Reasoning): Im Reasoning-Modus erzielt EXAONE 4.0 62 im Artificial Analysis Intelligence Index. Dies entspricht Claude 4 Opus und dem neuen Llama Nemotron Super 49B v1.5 von NVIDIA und liegt nur 1 Punkt hinter Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (Non-Reasoning): Im Non-Reasoning-Modus erzielt EXAONE 4.0 51 im Artificial Analysis Intelligence Index. Es entspricht Llama 4 Maverick in der Intelligenz, obwohl es nur ~1/4 der Gesamtparameter hat (aber ~2x die aktiven Parameter).

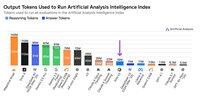

➤ ⚙️ Ausgabetoken und Wortanzahl: Im Reasoning-Modus verwendete EXAONE 4.0 100M Ausgabetoken für den Artificial Analysis Intelligence Index. Dies ist höher als bei einigen anderen Grenzmodellen, stimmt aber mit den aktuellen Trends überein, dass Reasoning-Modelle mehr Ausgabetoken verwenden, um "mehr nachzudenken" - ähnlich wie Llama Nemotron Super 49B v1.5, Grok 4 und Qwen3 235B 2507 Reasoning. Im Non-Reasoning-Modus verwendete EXAONE 4.0 15M Tokens - hoch für einen Non-Reasoner, aber nicht so hoch wie Kimi K2’s 30M.

Wichtige Details:

➤ Hybrid-Reasoning: Das Modell bietet die Möglichkeit zwischen 'Reasoning'-Modus und 'Non-Reasoning'-Modus zu wählen.

➤ Verfügbarkeit: Derzeit von @friendliai gehostet und wettbewerbsfähig bepreist (insbesondere im Vergleich zu proprietären Optionen) von FriendliAI zu $1 pro 1M Eingabe- und Ausgabetokens.

➤ Offene Gewichte: EXAONE 4.0 ist ein Modell mit offenen Gewichten, das unter der EXAONE AI Model License Agreement 1.2 verfügbar ist. Die Lizenz beschränkt die kommerzielle Nutzung.

➤ Multimodalität: Nur Text-Eingabe und -Ausgabe.

➤ Kontextfenster: 131k Tokens.

➤ Parameter: 32B aktive und Gesamtparameter, verfügbar in 16-Bit- und 8-Bit-Präzision (was bedeutet, dass das Modell auf einem einzelnen H100-Chip in voller Präzision betrieben werden kann).

41,45K

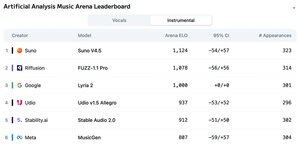

Ankündigung des Leaderboards der Artificial Analysis Music Arena: Mit über 5.000 Stimmen ist Suno v4.5 das führende Musikgenerierungsmodell, gefolgt von Riffusions FUZZ-1.1 Pro.

Googles Lyria 2 belegt den dritten Platz in unserem Instrumental-Leaderboard, und Udios v1.5 Allegro belegt den dritten Platz in unserem Vocals-Leaderboard.

Das Instrumental-Leaderboard sieht wie folgt aus:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

Die Rankings basieren auf Community-Stimmen aus einer Vielzahl von Genres und Aufforderungen. Möchten Sie, dass Ihre Aufforderung vorgestellt wird? Sie können heute Aufforderungen in der Arena einreichen.

👇 Siehe unten für das Vocals-Leaderboard und den Link zur Teilnahme!

22,07K

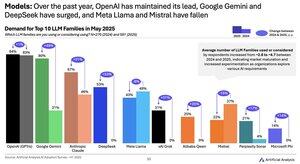

Modellnachfrageänderung 2024 bis 2025: Google (+49 Punkte), DeepSeek (+53 Punkte) und xAI (+31 Punkte) haben im vergangenen Jahr massive Gewinne im Nachfrageanteil erzielt.

@Google hat sich von einem KI-Nachzügler zu einem KI-Führer entwickelt, mit einem Anstieg von ~2,5x im Anteil der Befragten, die das Gemini-Modellserie nutzen oder in Betracht ziehen. Ein wichtiger Treiber dafür war, dass Google signifikante Fortschritte in der Intelligenz gemacht hat: Gemini 2.5 Pro steht jetzt auf Platz #3 in unserem Artificial Analysis Intelligence Index, im Vergleich zu einem erheblichen Rückstand hinter OpenAI und Anthropic Anfang 2024.

@deepseek_ai hatte im ersten Halbjahr 2024 nur DeepSeek 67B veröffentlicht, ein Modell, das eine begrenzte Akzeptanz erfuhr und hinter Llama 3 70B zurückblieb. DeepSeek erlebte erstmals Ende 2024 mit der Veröffentlichung ihres V2-Modells eine gewisse Akzeptanz und sah dann Anfang 2025 mit ihren V3- und R1-Modellen, die sie an die Spitze der offenen Gewichtsmodelle führten, eine rasche Akzeptanz.

@xai veröffentlichte sein erstes Modell Grok-1 Mitte des ersten Halbjahres 2024 und hat seitdem schnell die Führungsposition in der Intelligenz über alle Modelle hinweg mit aufeinanderfolgenden Veröffentlichungen erklommen, die in der Einführung von Grok 4 in der letzten Woche gipfelten.

Quelle: Artificial Analysis AI Adoption Survey H1 2025 (Bericht auf der Website von Artificial Analysis verfügbar)

388,95K

Kimi K2 Anbieter: Groq liefert Kimi K2 mit >400 Ausgabetokens/s, 40X schneller als die First-Party-API von Moonshot.

Herzlichen Glückwunsch an eine Reihe von Anbietern, die schnell APIs für Kimi K2 gestartet haben, darunter @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra und natürlich @Kimi_Moonshot. Das ist beeindruckend, wenn man die Größe des Modells mit insgesamt 1 Billion Parametern betrachtet.

Groq sticht durch seine blitzschnelle Geschwindigkeit hervor. DeepInfra, Novita und Baseten zeichnen sich durch ihre Preisgestaltung aus, da sie die einzigen Anbieter sind, die ähnlich oder günstiger als die First-Party-API von Moonshot anbieten.

Siehe unten für weitere Vergleiche zwischen den Anbietern. Wir erwarten schnelle Geschwindigkeitssteigerungen bei einigen Anbietern, während die Teams für das K2-Modell optimieren - unsere Zahlen unten zeigen die Medianwerte der Geschwindigkeiten der letzten 72 Stunden, aber wir sehen bereits, dass DeepInfra heute auf 62 Tokens/s gestiegen ist.

52,18K

Während Kimi k2 von Moonshot AI das führende Open-Weights-Modell ohne Schlussfolgerungen im Artificial Analysis Intelligence Index ist, gibt es ~3x mehr Tokens aus als andere Modelle ohne Schlussfolgerungen, wodurch die Grenzen zwischen Schlussfolgerung und Nicht-Schlussfolgerung verschwommen werden.

Kimi k2 ist das größte bedeutende Open-Weights-Modell bisher - 1T Gesamtparameter mit 32B aktiv (dies erfordert massive 1TB Speicher im nativen FP8, um die Gewichte zu halten). Wir haben k2 auf Platz 57 im Artificial Analysis Intelligence Index, eine beeindruckende Punktzahl, die es über Modelle wie GPT-4.1 und DeepSeek V3 hebt, aber hinter führenden Schlussfolgerungsmodellen zurückbleibt.

Bis jetzt gab es eine klare Unterscheidung zwischen Schlussfolgerungsmodellen und Modellen ohne Schlussfolgerungen in unseren Bewertungen - definiert nicht nur durch die Verwendung von <reasoning>-Tags, sondern hauptsächlich durch die Token-Nutzung. Die mediane Anzahl der Tokens, die zur Beantwortung aller Bewertungen im Artificial Analysis Intelligence Index verwendet werden, ist für Schlussfolgerungsmodelle ~10x höher als für Modelle ohne Schlussfolgerungen.

@Kimi_Moonshot's Kimi k2 verwendet ~3x die Anzahl der Tokens, die das mediane Modell ohne Schlussfolgerungen verwendet. Seine Token-Nutzung ist nur bis zu 30% niedriger als die von Claude 4 Sonnet und Opus, wenn sie im maximalen Budget-Modus für erweitertes Denken betrieben werden, und ist fast dreimal so hoch wie die Token-Nutzung von sowohl Claude 4 Sonnet als auch Opus, wenn die Schlussfolgerungen deaktiviert sind.

Daher empfehlen wir, dass Kimi k2 mit Claude 4 Sonnet und Opus in ihren maximalen Budget-Modi für erweitertes Denken verglichen wird, nicht mit den Nicht-Schlussfolgerungswerten für die Claude 4-Modelle.

Kimi k2 ist über die First-Party-API von @Kimi_Moonshot sowie über @FireworksAI_HQ, @togethercompute, @novita_labs und @parasail_io verfügbar.

Siehe unten und auf Artificial Analysis für weitere Analysen 👇

60,5K

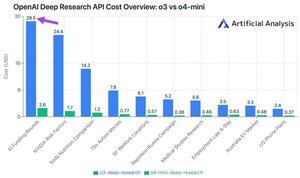

Die neue Deep Research API von OpenAI kostet bis zu ~$30 pro API-Aufruf! Diese neuen Deep Research API-Endpunkte könnten der neue schnellste Weg sein, Geld auszugeben.

Bei unseren 10 Deep Research-Testabfragen haben wir $100 für o3 und $9,18 für o4-mini ausgegeben. Wie können die Kosten so hoch werden? Hohe Preise und Millionen von Tokens.

Diese Endpunkte sind Versionen von o3 und o4-mini, die für Deep Research-Aufgaben RL’d wurden. Die Verfügbarkeit über die API ermöglicht die Nutzung sowohl mit OpenAIs Websuchtool als auch mit benutzerdefinierten Datenquellen über entfernte MCP-Server.

o4-mini-deep-research-Preise sind 5x niedriger als die Preise für o3-deep-research. In unseren Testabfragen scheint o4-mini auch weniger Tokens zu verwenden - es war insgesamt über 10x günstiger in unseren 10 Testabfragen.

Preise:

➤ o3-deep-research kostet $10 /M Eingabe ($2,50 zwischengespeicherte Eingabe), $40 /M Ausgabe

➤ o4-mini-deep-research kostet $2 /M Eingabe ($0,5 zwischengespeicherte Eingabe), $8 /M Ausgabe

Diese Endpunkte sind beide erheblich teurer als OpenAIs Standard-o3- und o4-mini-Endpunkte - diese liegen bei:

➤ o3: $2 /M ($0,5 zwischengespeichert) Eingabe, $8 /M Ausgabe für o3

➤ o4-mini: $1,1 /M (0,275 zwischengespeichert) Eingabe, $4,4 /M Ausgabe

37,21K

Black Forest Labs wird eine Flut neuer Startups mit ihrem heute veröffentlichten offenen Gewichts-Bildbearbeitungsmodell schaffen.

- Virtuelles Anprobieren wird 10X besser, aber das ist nur der Anfang. Wir werden auch neue Erfahrungen sehen, während die Menschen kreativ mit diesen Modellen umgehen (viel umfangreicher als Snapchat- und Instagram-Filter).

- Das Modell hat nur 12B und kann auf Verbraucherhardware feinabgestimmt werden.

- Plattformen wie @FAL bieten vollständige LoRA-Trainingsunterstützung.

Danke an @FAL für das Bild unten, sie haben einen großartigen Artikel über ihr Feinabstimmungsangebot (Link unten).

34,26K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten