Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Capa de ejecución para operadores de IA y robótica en @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Los VLAs todavía son muy nuevos y muchas personas encuentran difícil entender la diferencia entre los VLAs y los LLMs.

Aquí hay un análisis profundo de cómo estos sistemas de IA difieren en razonamiento, percepción y acción. Parte 1.

Desglosemos las principales distinciones y cómo los agentes de IA envueltos en un LLM difieren de los agentes operativos que utilizan modelos VLA:

1. Percepción: Cómo perciben el mundo

Agente (LLM): Procesa texto o datos estructurados, por ejemplo, JSON, APIs y a veces imágenes. Es como un cerebro que trabaja con entradas limpias y abstractas. Piensa en leer un manual o analizar una hoja de cálculo. Genial para entornos estructurados, pero limitado por lo que se le alimenta.

Operador (VLA): Ve píxeles en bruto y en tiempo real de cámaras, además de datos de sensores (por ejemplo, tacto, posición) y propriocepción (autoconciencia del movimiento). Es como navegar por el mundo con ojos y sentidos, prosperando en entornos dinámicos y desordenados como interfaces de usuario o espacios físicos.

2. Actuar: Cómo interactúan

Agente: Actúa llamando funciones, herramientas o APIs. Imagínalo como un gerente que envía instrucciones precisas como “reserva un vuelo a través de la API de Expedia.” Es deliberado pero depende de herramientas preconstruidas e interfaces claras.

Operador: Ejecuta acciones continuas y de bajo nivel, como mover un cursor de ratón, escribir o controlar las articulaciones de un robot. Es como un trabajador hábil manipulando directamente el entorno, ideal para tareas que requieren precisión en tiempo real.

3. Control: Cómo toman decisiones

Agente: Sigue un ciclo lento y reflexivo: planificar, llamar a una herramienta, evaluar el resultado, repetir. Está limitado por tokens (limitado por el procesamiento de texto) y por la red (esperando respuestas de la API). Esto lo hace metódico pero lento para tareas en tiempo real.

Operador: Opera, tomando decisiones paso a paso en un ciclo de retroalimentación ajustado. Piensa en un jugador reaccionando instantáneamente a lo que hay en la pantalla. Esta velocidad permite una interacción fluida pero exige un procesamiento robusto en tiempo real.

4. Datos para aprender: Qué alimenta su entrenamiento

Agente: Entrenado en vastos corpus de texto, instrucciones, documentación o conjuntos de datos RAG (Generación Aumentada por Recuperación). Aprende de libros, código o preguntas frecuentes, destacándose en el razonamiento sobre conocimiento estructurado.

Operador: Aprende de demostraciones (por ejemplo, videos de humanos realizando tareas), registros de teleoperación o señales de recompensa. Es como aprender observando y practicando, perfecto para tareas donde las instrucciones explícitas son escasas.

5. Modos de fallo: Dónde se rompen

Agente: Propenso a la alucinación (inventar respuestas) o a planes de largo plazo frágiles que se desmoronan si un paso falla. Es como un estratega que sobrepiensa o malinterpreta la situación.

Operador: Enfrenta un cambio de covariables (cuando los datos de entrenamiento no coinciden con las condiciones del mundo real) o errores acumulativos en el control (pequeños errores que se agravan). Es como un conductor perdiendo el control en una carretera desconocida.

6. Infraestructura: La tecnología detrás de ellos

Agente: Depende de un prompt/router para decidir qué herramientas llamar, un registro de herramientas para funciones disponibles y memoria/RAG para contexto. Es una configuración modular, como un centro de comando orquestando tareas.

Operador: Necesita tuberías de ingestión de video, un servidor de acciones para control en tiempo real, un escudo de seguridad para prevenir acciones dañinas y un búfer de reproducción para almacenar experiencias. Es un sistema de alto rendimiento construido para entornos dinámicos.

7. Dónde brilla cada uno: Sus puntos fuertes

Agente: Domina en flujos de trabajo con APIs limpias (por ejemplo, automatización de procesos empresariales), razonamiento sobre documentos (por ejemplo, resumiendo informes) o generación de código. Es tu opción preferida para tareas estructuradas y de alto nivel.

Operador: Destaca en entornos desordenados y sin APIs, como navegar por interfaces de usuario torpes, controlar robots o abordar tareas similares a juegos. Si implica interacción en tiempo real con sistemas impredecibles, el VLA es el rey.

8. Modelo mental: Planificador + Ejecutante

Piensa en el Agente LLM como el planificador: descompone tareas complejas en objetivos claros y lógicos.

El Operador VLA es el ejecutante, llevando a cabo esos objetivos interactuando directamente con píxeles o sistemas físicos. Un verificador (otro sistema o agente) monitorea los resultados para asegurar el éxito.

$CODEC

21,71K

Codecflow Optr ofrece un enfoque unificado para construir agentes que ven, razonan y actúan en entornos digitales y físicos. Ya sea automatizando flujos de trabajo de escritorio, controlando brazos robóticos o realizando pruebas en simulación, utiliza el mismo modelo mental y primitivas.

Louround 🥂21 ago, 04:10

Las caídas en un mercado alcista están destinadas a ser compradas, especialmente en proyectos con grandes catalizadores.

Todos sabemos que la IA es la narrativa de este ciclo, iniciada por ai16z y Virtuals el año pasado.

Mi apuesta es que el mercado se centrará en tecnologías más complejas y sofisticadas como los VLAs, y déjame decirte por qué.

Los LLMs (Modelos de Lenguaje Grande) principalmente leen y escriben texto: son excelentes para explicar, planificar y generar instrucciones, pero no controlan motores ni interactúan con el mundo físico por sí mismos (como puedes haber experimentado con chatgpt).

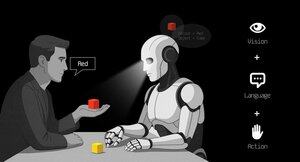

Los VLAs (Modelos de Lenguaje Visual y Acción) difieren de los LLMs ya que son sistemas multimodales que observan cosas (visión), entienden instrucciones (lenguaje) y producen acciones directamente. Es como decirle a un robot que recoja una taza roja y luego mover su brazo para hacerlo.

Los VLAs se entrenan con ejemplos que emparejan imágenes/video + instrucciones + trazas de acción reales (cómo se movió realmente un robot), y deben funcionar rápido y de manera segura en tiempo real. Los LLMs, por su parte, se entrenan en enormes colecciones de texto y se centran en tareas de razonamiento y lenguaje.

Resumen: los LLMs piensan y hablan mientras que los VLAs ven, razonan y actúan.

Como puedes ver, los VLAs son una gran adición a los LLMs y permitirán notablemente la próxima innovación de 0 a 1 en la economía en general, que será la robótica. La mayoría de los fondos de inversión están asignando una gran parte de sus inversiones a este sector, visto como la próxima evolución lógica en la industria de la IA.

Ya hice una publicación hace un tiempo sobre el actual líder en el mercado de criptomonedas, @codecopenflow, que no recaudó capital (lanzamiento justo) pero está entregando productos de vanguardia y actualmente tiene un FDV de $23M.

Para información, otros competidores de criptomonedas recaudaron $20m (@openmind_agi) en lo que probablemente es un FDV de $200M a $300M ++ mientras que no se ha construido ni enviado ningún producto o comunidad aún.

Lo que hace que Codec sea un proyecto líder en el sector es que abordan un cuello de botella crucial en la robótica y la IA, que es la dificultad de hacer que todas las herramientas de IA interactúen entre sí. Déjame explicar.

Su último lanzamiento, OPTR (operador), es un kit de herramientas que ayuda a construir operadores capaces de interactuar en múltiples plataformas como robots, escritorios, navegadores o simulaciones. El objetivo de un operador es ver, razonar y actuar (VLA) en mundos tanto digitales (computadoras) como físicos (robots).

Este kit de herramientas sirve como infraestructura central para equipos robóticos que buscan probar su producto y mejorar el proceso general al proporcionar una experiencia unificada en lugar de separadas para navegadores web, simulaciones o robots. Esto esencialmente hace que el operador sea adaptativo y autónomo independientemente de su entorno.

Así que lo entiendes, ahorrará mucho tiempo para las empresas y desarrolladores que anteriormente tenían que pasar por cada paso manualmente y donde puedes ahorrar tiempo, puedes ahorrar dinero.

También permitirá a Codec construir sus propios proyectos de operadores y lanzar nuevas capacidades relativamente rápido en el mercado, notablemente a través de su mercado.

Resumen: Probablemente has visto videos de robots doblando pañuelos, clasificando cajas o saltando sobre varios elementos. Todos han sido entrenados para este caso de uso muy específico, y desafortunadamente, una habilidad no puede ser reutilizada en otro entorno como un humano podría hacerlo. OPTR de Codec resuelve esto haciendo que las habilidades sean transferibles entre entornos y situaciones, haciendo que el entrenamiento y desarrollo sean mucho más rápidos y baratos para las empresas.

Por eso Codec es tan interesante al unificar el mundo digital con el mundo físico.

$CODEC, Coded.

2,59K

La firma de investigación @epochbiz (de @ZoomerOracle) publicó un detallado informe de investigación sobre CodecFlow.

No te lo pierdas.

$CODEC

epoch_19 ago, 21:07

$CODEC se está preparando para ser la mejor opción como juego en cadena para la Robótica

El artículo de investigación sobre @codecopenflow ya está disponible en 🤖

3,64K

Estamos viendo un aumento en cuentas falsas que afirman representar a CodecFlow.

Las únicas cuentas oficiales en X/Twitter son @codecopenflow y @RoboMove.

Todos los demás canales verificados están listados en nuestro sitio web.

Solo hay un token, $CODEC.

Mantente alerta y reporta cualquier cuenta sospechosa.

Por favor, vuelve a publicar y comparte para ayudar a difundir la información.

3,33K

RoboMove es un escaparate impulsado completamente por la infraestructura de CodecFlow.

No hay un token separado. $CODEC es el único token dentro del ecosistema.

@RoboMove es solo un ejemplo de lo que es posible con los operadores de CodecFlow.

Pronto, los desarrolladores podrán construir sus propios sistemas avanzados en CodecFlow utilizando nuestro SDK y herramientas.

La plataforma es intencionalmente abierta y extensible, lo que permite un sinfín de casos de uso, desde el control robótico hasta la automatización de GUI.

⚠️ No caigas en fichas falsas o imitadores. Siempre verifique de fuentes oficiales.

3,85K

Estamos contentos de ver a la comunidad china notando CodecFlow y amando lo que estamos construyendo.

欢迎你们. Apenas estamos comenzando. Mucho más por venir.

0xFunky13 jul 2025

La venta pública de PUMP terminó, originalmente también tenía una gran cantidad en Bybit, solo se colocó la mitad en la cadena y, al final, solo la cadena tuvo éxito, pero afortunadamente no hubo cobertura por adelantado ...

Hablando de eso, muchas personas en la comunidad de IA han estado discutiendo VLA (Visión-Lenguaje-Acción) recientemente.

Investigué específicamente si alguien estaba trabajando en proyectos relacionados con VLA en la cadena, vi este proyecto de CodecFlow @Codecopenflow y compré un poco.

== ¿Qué está haciendo CodecFlow? ==

Una breve introducción a VLA, VLA es una arquitectura modelo que permite a la IA no solo "hablar" sino "hacer".

Los LLM tradicionales (como GPT) solo pueden entender el lenguaje y proporcionar sugerencias, pero no realizan operaciones prácticas, no hacen clic en pantallas ni agarran objetos.

El modelo VLA significa que integra tres capacidades principales:

1. Visión: comprenda las pantallas, las capturas de pantalla, las entradas de la cámara o los datos de los sensores

2. Lenguaje: Comprender las instrucciones del lenguaje natural humano

3. Acción: Genere comandos ejecutables como clics del mouse, entradas de teclado y brazos robóticos de control

CodecFlow está haciendo VLA en la cadena, y todos los procesos de operación también se pueden cargar en la cadena, que se puede auditar, verificar y liquidar.

En pocas palabras, es la infraestructura de los "bots de IA".

== ¿Por qué presté especial atención a este proyecto? ==

¡Descubrí que sus desarrolladores son contribuyentes principales de LeRobot, el proyecto de código abierto más popular en el espacio VLA!

LeRobot es la base principal para construir modelos VLA en el mundo de código abierto, incluidos VLA livianos como SmolVLA que pueden ejecutarse en computadoras portátiles.

Significa que este equipo realmente entiende la arquitectura VlA y entiende el robot.

Veo que también continúan construyendo, y el precio de la moneda también está aumentando constantemente, soy muy optimista sobre la pista de VLA, y por la tendencia general, VLA y los robots son de hecho el futuro en el mercado.

• Los gigantes de Web2 (Google, Meta, Tesla) están actualmente totalmente comprometidos con la formación de VLA y bots;

• Los proyectos Web3 rara vez tienen aplicaciones VLA que puedan realizar tareas, y todavía son muy escasas

• Los VLA tienen la oportunidad de desempeñar un gran valor en escenarios como DePIN, automatización web, ejecución de agentes de IA en cadena, etc.

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Siempre DYOR。

4,11K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado