Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Warstwa wykonawcza dla operatorów AI i robotyki na @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLAs są wciąż bardzo nowe i wiele osób ma trudności zrozumieć różnicę między VLA a LLM.

Oto głęboka analiza, jak te systemy AI różnią się w zakresie rozumowania, percepcji i działania. Część 1.

Rozłóżmy kluczowe różnice i jak agenci AI opakowani wokół LLM różnią się od agentów operatorów, którzy używają modeli VLA:

1. Percepcja: Jak postrzegają świat

Agent (LLM): Przetwarza tekst lub dane strukturalne, np. JSON, API, a czasami obrazy. To jak mózg pracujący z czystymi, abstrakcyjnymi danymi. Pomyśl o czytaniu instrukcji lub analizowaniu arkusza kalkulacyjnego. Świetnie sprawdza się w uporządkowanych środowiskach, ale jest ograniczony przez to, co mu dostarczono.

Operator (VLA): Widzi surowe, rzeczywiste piksele z kamer, plus dane z czujników (np. dotyk, pozycja) i propriocepcję (samoświadomość ruchu). To jak nawigowanie po świecie za pomocą oczu i zmysłów, doskonale radzi sobie w dynamicznych, chaotycznych warunkach, takich jak interfejsy użytkownika czy przestrzenie fizyczne.

2. Działanie: Jak wchodzą w interakcje

Agent: Działa, wywołując funkcje, narzędzia lub API. Wyobraź sobie to jako menedżera wysyłającego precyzyjne instrukcje, takie jak „zarezerwuj lot przez API Expedia”. To jest zamierzone, ale polega na wstępnie zbudowanych narzędziach i jasnych interfejsach.

Operator: Wykonuje ciągłe, niskopoziomowe działania, takie jak poruszanie kursorem myszy, pisanie lub kontrolowanie stawów robota. To jak wykwalifikowany pracownik bezpośrednio manipulujący otoczeniem, idealny do zadań wymagających precyzji w czasie rzeczywistym.

3. Kontrola: Jak podejmują decyzje

Agent: Podąża za wolną, refleksyjną pętlą: planuj, wywołaj narzędzie, oceń wynik, powtórz. Jest ograniczony przez tokeny (ograniczony przez przetwarzanie tekstu) i sieć (czekając na odpowiedzi API). To sprawia, że jest metodyczny, ale powolny w zadaniach w czasie rzeczywistym.

Operator: Działa, podejmując decyzje krok po kroku w ciasnej pętli sprzężenia zwrotnego. Pomyśl o tym jak o graczu reagującym natychmiast na to, co jest na ekranie. Ta szybkość umożliwia płynne interakcje, ale wymaga solidnego przetwarzania w czasie rzeczywistym.

4. Dane do nauki: Co napędza ich trening

Agent: Trenuje na ogromnych zbiorach tekstów, instrukcjach, dokumentacji lub zestawach danych RAG (Retrieval-Augmented Generation). Uczy się z książek, kodu lub FAQ, doskonale radząc sobie z rozumowaniem na podstawie wiedzy strukturalnej.

Operator: Uczy się z demonstracji (np. filmów ludzi wykonujących zadania), logów teleoperacji lub sygnałów nagród. To jak nauka przez obserwację i praktykę, idealne do zadań, w których brakuje wyraźnych instrukcji.

5. Tryby awarii: Gdzie się psują

Agent: Skłonny do halucynacji (wymyślanie odpowiedzi) lub kruchych długoterminowych planów, które się rozpadają, jeśli jeden krok zawiedzie. To jak strateg, który zbytnio analizuje lub źle odczytuje sytuację.

Operator: Napotyka przesunięcie kowariancji (gdy dane treningowe nie odpowiadają warunkom rzeczywistym) lub kumulujące się błędy w kontroli (małe błędy narastają). To jak kierowca tracący kontrolę na nieznanej drodze.

6. Infra: Technologia stojąca za nimi

Agent: Polega na podpowiedzi/routerze, aby zdecydować, które narzędzia wywołać, rejestrze narzędzi dla dostępnych funkcji oraz pamięci/RAG dla kontekstu. To modułowa konfiguracja, jak centrum dowodzenia organizujące zadania.

Operator: Potrzebuje pipeline'ów do przetwarzania wideo, serwera akcji do kontroli w czasie rzeczywistym, osłony bezpieczeństwa, aby zapobiec szkodliwym działaniom, oraz bufora odtwarzania do przechowywania doświadczeń. To system wysokowydajny, zbudowany do dynamicznych środowisk.

7. Gdzie każdy błyszczy: Ich mocne strony

Agent: Dominuje w przepływach pracy z czystymi API (np. automatyzacja procesów biznesowych), rozumowaniem na podstawie dokumentów (np. podsumowywanie raportów) lub generowaniem kodu. To twój wybór do uporządkowanych, wysokopoziomowych zadań.

Operator: Doskonale radzi sobie w chaotycznych, pozbawionych API środowiskach, takich jak nawigowanie po nieporęcznych interfejsach użytkownika, kontrolowanie robotów lub podejmowanie zadań przypominających gry. Jeśli to wymaga interakcji w czasie rzeczywistym z nieprzewidywalnymi systemami, VLA jest królem.

8. Model mentalny: Planista + Wykonawca

Pomyśl o agencie LLM jako o planista: dzieli złożone zadania na jasne, logiczne cele.

Operator VLA to wykonawca, realizujący te cele poprzez bezpośrednią interakcję z pikselami lub systemami fizycznymi. Kontroler (inny system lub agent) monitoruje wyniki, aby zapewnić sukces.

$CODEC

18,3K

Codecflow Optr oferuje zintegrowane podejście do budowania agentów, którzy widzą, rozumują i działają w środowiskach cyfrowych i fizycznych. Niezależnie od tego, czy automatyzujesz przepływy pracy na komputerze, kontrolujesz ramiona robotów, czy testujesz w symulacji, używa tego samego modelu mentalnego i prymitywów.

Louround 🥂21 sie, 04:10

Spadki na rynku byka są przeznaczone do kupowania, szczególnie w projektach z dużymi katalizatorami.

Wszyscy wiemy, że AI jest narracją tego cyklu, rozpoczętą przez ai16z i Virtuals w zeszłym roku.

Moje zakłady są takie, że rynek skupi się na bardziej złożonych i zaawansowanych technologiach, takich jak VLAs, i pozwól, że ci powiem dlaczego.

LLM (Duże Modele Językowe) głównie czytają i piszą tekst: są świetne w wyjaśnianiu, planowaniu i generowaniu instrukcji, ale same w sobie nie kontrolują silników ani nie wchodzą w interakcje ze światem fizycznym (jak mogłeś doświadczyć z chatgpt).

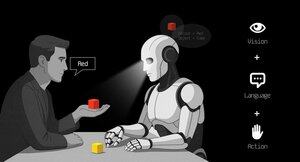

VLAs (Modele Akcji Językowej Wizji) różnią się od LLM, ponieważ są multimodalnymi systemami, które patrzą na rzeczy (wizja), rozumieją instrukcje (język) i bezpośrednio produkują działania. To jak powiedzenie robotowi, aby podniósł czerwony kubek, a następnie poruszenie jego ramieniem, aby to zrobić.

VLAs są trenowane na przykładach, które łączą obrazy/wideo + instrukcje + rzeczywiste ślady działań (jak robot faktycznie się poruszał), i muszą działać szybko i bezpiecznie w czasie rzeczywistym. LLM z kolei są trenowane na ogromnych zbiorach tekstów i koncentrują się na rozumowaniu i zadaniach językowych.

TL;DR LLM myślą i mówią, podczas gdy VLAs widzą, rozumują i działają.

Jak widać, VLAs są istotnym dodatkiem do LLM i znacząco umożliwią innowacje 0 do 1 w całej gospodarce, którą będą robotyka. Większość funduszy inwestycyjnych przeznacza dużą część swoich inwestycji na ten sektor, postrzegany jako następna logiczna ewolucja w branży AI.

Już wcześniej opublikowałem post na temat obecnego lidera na rynku kryptowalut, @codecopenflow, który nie pozyskał kapitału (uczciwe uruchomienie), a mimo to dostarcza nowoczesne produkty i obecnie ma wartość FDV na poziomie 23 milionów dolarów.

Dla informacji, inni konkurenci kryptowalutowi pozyskali 20 milionów dolarów ( @openmind_agi) przy tym, co prawdopodobnie jest wartością FDV od 200 do 300 milionów dolarów, podczas gdy żaden produkt ani społeczność nie zostały jeszcze zbudowane i dostarczone.

Co sprawia, że Codec jest wiodącym projektem w tym sektorze, to fakt, że zajmują się kluczowym wąskim gardłem w robotyce i AI, którym jest trudność w interakcji wszystkich narzędzi AI. Pozwól, że wyjaśnię.

Ich najnowsze wydanie, OPTR (operator), to zestaw narzędzi, który pomaga budować operatorów zdolnych do interakcji na wielu platformach, takich jak roboty, komputery stacjonarne, przeglądarki czy symulacje. Celem operatora jest widzieć, rozumieć i działać (VLA) zarówno w świecie cyfrowym (komputery), jak i fizycznym (roboty).

Ten zestaw narzędzi służy jako podstawowa infrastruktura dla zespołów robotycznych, które dążą do przetestowania swojego produktu i poprawy całego procesu, zapewniając jednolite doświadczenie zamiast oddzielnych dla przeglądarek internetowych, symulacji czy robotów. To zasadniczo sprawia, że operator jest adaptacyjny i autonomiczny, niezależnie od swojego środowiska.

Więc rozumiesz, to zaoszczędzi dużo czasu dla firm i deweloperów, którzy wcześniej musieli przechodzić przez każdy krok ręcznie, a tam, gdzie można zaoszczędzić czas, można zaoszczędzić pieniądze.

To również umożliwi Codec budowanie własnych projektów operatorów i szybkie wprowadzanie nowych możliwości na rynek, szczególnie poprzez ich rynek.

TL;DR: Prawdopodobnie widziałeś filmy z robotami składającymi chusteczki, sortującymi pudełka lub skaczącymi na różnych elementach. Wszystkie były trenowane do tego bardzo specyficznego przypadku użycia, a niestety jedna umiejętność nie może być użyta w innym środowisku, jak mógłby to zrobić człowiek. OPTR od Codec rozwiązuje to, czyniąc umiejętności przenośnymi między środowiskami i sytuacjami, co znacznie przyspiesza i obniża koszty szkolenia i rozwoju dla przedsiębiorstw.

Dlatego Codec jest tak interesujący w jednoczeniu świata cyfrowego z fizycznym.

$CODEC, Coded.

2,26K

Firma badawcza @epochbiz (od @ZoomerOracle) opublikowała szczegółowy artykuł badawczy na temat CodecFlow.

Nie przegap tego.

$CODEC

epoch_19 sie, 21:07

$CODEC przygotowuje się, aby stać się najlepszą opcją jako gra onchain dla Robotyki

Artykuł badawczy o @codecopenflow jest już dostępny na 🤖

3,52K

Zauważamy wzrost fałszywych kont, które twierdzą, że reprezentują CodecFlow.

Jedynymi oficjalnymi kontami na X/Twitterze są @codecopenflow i @RoboMove.

Wszystkie inne zweryfikowane kanały są wymienione na naszej stronie internetowej.

Jest tylko jeden token, $CODEC.

Bądź czujny i zgłaszaj wszelkie podejrzane konta.

Proszę, przekaż dalej i udostępnij, aby pomóc w rozpowszechnieniu informacji.

3,21K

RoboMove to pokazowy projekt zasilany w całości przez infrastrukturę CodecFlow.

Nie ma osobnego tokena. $CODEC to jedyny token w ekosystemie.

@RoboMove to tylko jeden przykład tego, co jest możliwe z Operatorami CodecFlow.

Wkrótce deweloperzy będą mogli budować własne zaawansowane systemy na CodecFlow, korzystając z naszego SDK i narzędzi.

Platforma jest celowo otwarta i rozszerzalna, co pozwala na nieskończoną liczbę zastosowań, od kontroli robotów po automatyzację GUI.

⚠️ Nie daj się nabrać na fałszywe tokeny lub naśladowców. Zawsze weryfikuj z oficjalnych źródeł.

3,73K

Cieszymy się, że chińska społeczność zauważa CodecFlow i kocha to, co budujemy.

欢迎你们. Dopiero zaczynamy. Wiele więcej przed nami.

0xFunky13 lip 2025

PUMP publiczna sprzedaż zakończona, pierwotnie również miałem dużą kwotę na Bybit, na łańcuchu tylko 1/2, ostatecznie tylko na łańcuchu udało się zrealizować, na szczęście nie zabezpieczyłem się wcześniej…

Mówiąc o tym, ostatnio w społeczności AI wiele osób dyskutuje o VLA (Vision‑Language‑Action).

Szczególnie zbadałem, czy na łańcuchu są projekty związane z VLA, zobaczyłem ten projekt CodecFlow @Codecopenflow i kupiłem trochę.

== Czym zajmuje się projekt CodecFlow ==

Krótko mówiąc o VLA, VLA to model, który pozwala AI nie tylko „mówić”, ale także „działać”.

Tradycyjne LLM (jak GPT) potrafią tylko rozumieć język, udzielać sugestii, ale nie potrafią działać, klikać na ekranie ani chwytać obiektów.

Model VLA oznacza zintegrowanie trzech głównych zdolności:

1. Vision (wzrok): rozumieć obrazy, zrzuty ekranu, dane z kamer lub czujników

2. Language (język): rozumieć naturalne polecenia w języku ludzkim

3. Action (działanie): generować wykonalne polecenia, takie jak kliknięcia myszką, wprowadzanie z klawiatury, kontrolowanie ramienia robota.

CodecFlow zajmuje się VLA na łańcuchu, wszystkie procesy operacyjne mogą być również zapisane na łańcuchu, co umożliwia audyt, weryfikację i rozliczenie.

Mówiąc prosto, to podstawowa infrastruktura „robota AI”.

== Dlaczego szczególnie zwracam uwagę na ten projekt? ==

Zauważyłem, że ich deweloperzy są kluczowymi współtwórcami najpopularniejszego projektu open source w dziedzinie VLA, LeRobot!

LeRobot to wiodąca baza do budowy modeli VLA w świecie open source, w tym SmolVLA, które mogą działać na laptopach.

To oznacza, że ten zespół naprawdę rozumie architekturę VLA i roboty.

Widzę, że nadal intensywnie pracują nad rozwojem, a cena monet stabilnie rośnie, osobiście bardzo wierzę w tor VLA, a z ogólnych trendów wynika, że VLA i roboty mają przyszłość na rynku.

• Giganci Web2 (Google, Meta, Tesla) obecnie w pełni angażują się w VLA i szkolenie robotów;

• Projekty Web3 rzadko mają aplikacje VLA, które mogą wykonywać zadania, co jest bardzo rzadkie.

• VLA ma szansę na ogromną wartość w scenariuszach takich jak DePIN, automatyzacja Web, wykonywanie zadań przez AI na łańcuchu.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Zawsze DYOR.

3,99K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi