Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Couche d’exécution pour les opérateurs d’IA et la robotique sur @Solana

CA :69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Les VLAs sont encore très nouveaux et beaucoup de gens ont du mal à comprendre la différence entre les VLAs et les LLMs.

Voici une plongée approfondie sur la façon dont ces systèmes d'IA diffèrent en matière de raisonnement, de perception et d'action. Partie 1.

Décomposons les distinctions clés et comment les agents d'IA entourés d'un LLM diffèrent des agents opérateurs qui utilisent des modèles VLA :

1. Perception : Comment ils perçoivent le monde

Agent (LLM) : Traite du texte ou des données structurées, par exemple JSON, APIs, et parfois des images. C'est comme un cerveau travaillant avec des entrées propres et abstraites. Pensez à lire un manuel ou à analyser un tableau. Excellent pour des environnements structurés mais limité par ce qui lui est fourni.

Opérateur (VLA) : Voit des pixels bruts en temps réel provenant de caméras, plus des données de capteurs (par exemple, toucher, position) et de la proprioception (conscience de soi du mouvement). C'est comme naviguer dans le monde avec des yeux et des sens, prospérant dans des environnements dynamiques et désordonnés comme les interfaces utilisateur ou les espaces physiques.

2. Action : Comment ils interagissent

Agent : Agit en appelant des fonctions, des outils ou des APIs. Imaginez-le comme un manager envoyant des instructions précises comme "réserver un vol via l'API Expedia". C'est délibéré mais repose sur des outils préconstruits et des interfaces claires.

Opérateur : Exécute des actions continues et de bas niveau, comme déplacer un curseur de souris, taper ou contrôler des articulations de robot. C'est comme un travailleur qualifié manipulant directement l'environnement, idéal pour des tâches nécessitant une précision en temps réel.

3. Contrôle : Comment ils prennent des décisions

Agent : Suit une boucle lente et réfléchie : planifier, appeler un outil, évaluer le résultat, répéter. Il est lié aux tokens (limité par le traitement du texte) et lié au réseau (attendant les réponses des APIs). Cela le rend méthodique mais lent pour les tâches en temps réel.

Opérateur : Fonctionne, prenant des décisions étape par étape dans une boucle de rétroaction serrée. Pensez à un joueur réagissant instantanément à ce qui est à l'écran. Cette rapidité permet une interaction fluide mais exige un traitement robuste en temps réel.

4. Données à apprendre : Ce qui alimente leur formation

Agent : Formé sur d'énormes corpus de texte, instructions, documentation ou ensembles de données RAG (Génération Augmentée par Récupération). Il apprend à partir de livres, de code ou de FAQ, excellant dans le raisonnement sur des connaissances structurées.

Opérateur : Apprend par démonstrations (par exemple, vidéos d'humains effectuant des tâches), journaux de téléopération ou signaux de récompense. C'est comme apprendre en regardant et en pratiquant, parfait pour des tâches où les instructions explicites sont rares.

5. Modes de défaillance : Où ils échouent

Agent : Sujet à l'hallucination (inventer des réponses) ou à des plans à long terme fragiles qui s'effondrent si une étape échoue. C'est comme un stratège qui réfléchit trop ou mal interprète la situation.

Opérateur : Fait face à un changement de covariables (lorsque les données d'entraînement ne correspondent pas aux conditions réelles) ou à des erreurs cumulatives dans le contrôle (de petites erreurs s'accumulent). C'est comme un conducteur perdant le contrôle sur une route inconnue.

6. Infra : La technologie derrière eux

Agent : Dépend d'un prompt/router pour décider quels outils appeler, d'un registre d'outils pour les fonctions disponibles, et de la mémoire/RAG pour le contexte. C'est une configuration modulaire, comme un centre de commandement orchestrant des tâches.

Opérateur : Nécessite des pipelines d'ingestion vidéo, un serveur d'action pour le contrôle en temps réel, un bouclier de sécurité pour prévenir les actions nuisibles, et un tampon de lecture pour stocker les expériences. C'est un système haute performance construit pour des environnements dynamiques.

7. Où chacun brille : Leurs points forts

Agent : Domine dans les flux de travail avec des APIs propres (par exemple, automatisation des processus commerciaux), raisonnement sur des documents (par exemple, résumer des rapports) ou génération de code. C'est votre référence pour des tâches structurées et de haut niveau.

Opérateur : Excelle dans des environnements désordonnés, sans API, comme naviguer dans des interfaces utilisateur encombrées, contrôler des robots ou s'attaquer à des tâches de type jeu. Si cela implique une interaction en temps réel avec des systèmes imprévisibles, le VLA est roi.

8. Modèle mental : Planificateur + Exécutant

Pensez à l'Agent LLM comme au planificateur : il décompose des tâches complexes en objectifs clairs et logiques.

L'Opérateur VLA est l'exécutant, réalisant ces objectifs en interagissant directement avec des pixels ou des systèmes physiques. Un vérificateur (un autre système ou agent) surveille les résultats pour garantir le succès.

$CODEC

18,4K

Codecflow Optr propose une approche unifiée pour construire des agents capables de voir, raisonner et agir dans des environnements numériques et physiques. Que ce soit pour automatiser des flux de travail sur bureau, contrôler des bras robotiques ou effectuer des tests en simulation, il utilise le même modèle mental et les mêmes primitives.

Louround 🥂21 août, 04:10

Les baisses dans un marché haussier sont faites pour être achetées, surtout sur des projets avec de grands catalyseurs.

Nous savons tous que l'IA est le récit de ce cycle, commencé par ai16z et Virtuals l'année dernière.

Mon pari est que le marché se concentrera sur des technologies plus complexes et sophistiquées telles que les VLAs, et laissez-moi vous dire pourquoi.

Les LLMs (Modèles de Langage de Grande Taille) lisent et écrivent principalement du texte : ils excellent à expliquer, planifier et générer des instructions, mais ils ne contrôlent pas eux-mêmes des moteurs ni n'interagissent avec le monde physique (comme vous avez pu le constater avec chatgpt).

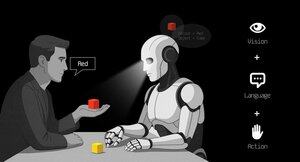

Les VLAs (Modèles Vision Langage Action) diffèrent des LLMs car ce sont des systèmes multimodaux qui regardent des choses (vision), comprennent des instructions (langage) et produisent directement des actions. C'est comme dire à un robot de prendre une tasse rouge et ensuite de bouger son bras pour le faire.

Les VLAs sont entraînés sur des exemples qui associent images/vidéos + instructions + traces d'actions réelles (comment un robot a réellement bougé), et ils doivent fonctionner rapidement et en toute sécurité en temps réel. Les LLMs, de leur côté, sont entraînés sur d'énormes collections de textes et se concentrent sur le raisonnement et les tâches linguistiques.

TL;DR : Les LLMs pensent et parlent tandis que les VLAs voient, raisonnent et agissent.

Comme vous pouvez le voir, les VLAs sont un ajout majeur aux LLMs et permettront notamment la prochaine innovation de 0 à 1 dans l'économie globale qui sera la robotique. Une majorité de fonds d'investissement alloue une grande partie de leurs investissements dans ce secteur, considéré comme la prochaine évolution logique de l'industrie de l'IA.

J'ai déjà fait un post il y a quelque temps sur le leader actuel du marché crypto, @codecopenflow, qui n'a pas levé de capital (lancement équitable) mais qui expédie des produits de pointe et qui est actuellement évalué à 23 millions de dollars FDV.

Pour information, d'autres concurrents crypto ont levé 20 millions de dollars ( @openmind_agi) à ce qui est probablement une évaluation de 200 millions à 300 millions de dollars ++ FDV alors qu'aucun produit ou communauté n'a encore été construit et expédié.

Ce qui fait de Codec un projet leader dans le secteur, c'est qu'ils s'attaquent à un goulot d'étranglement crucial dans la robotique et l'IA, qui est la difficulté d'avoir tous les outils d'IA interagir ensemble. Laissez-moi expliquer.

Leur dernière sortie, OPTR (opérateur), est un ensemble d'outils qui aide à construire des opérateurs capables d'interagir sur plusieurs plateformes telles que des robots, des ordinateurs de bureau, des navigateurs ou des simulations. L'objectif d'un opérateur est de voir, raisonner et agir (VLA) dans les mondes numériques (ordinateurs) et physiques (robots).

Cet ensemble d'outils sert d'infrastructure de base pour les équipes robotiques cherchant à tester leur produit et à améliorer l'ensemble du processus en fournissant une expérience unifiée au lieu de séparées pour les navigateurs web, les simulations ou les robots. Cela rend essentiellement l'opérateur adaptatif et autonome, quel que soit son environnement.

Donc vous comprenez, cela fera gagner beaucoup de temps aux entreprises et aux développeurs qui devaient auparavant passer par chaque étape manuellement et là où vous pouvez gagner du temps, vous pouvez économiser de l'argent.

Cela permettra également à Codec de construire ses propres projets d'opérateur et de lancer de nouvelles capacités relativement rapidement sur le marché, notamment via leur place de marché.

TL;DR : Vous avez probablement vu des vidéos de robots pliant des tissus, triant des boîtes ou sautant sur divers éléments. Ils ont tous été entraînés pour ce cas d'utilisation très spécifique, et malheureusement, une compétence ne peut pas être réutilisée dans un autre environnement comme un humain pourrait le faire. OPTR de Codec résout cela en rendant les compétences transférables entre environnements et situations, rendant l'entraînement et le développement beaucoup plus rapides et moins chers pour les entreprises.

C'est pourquoi Codec est si intéressant dans l'unification du monde numérique avec le monde physique.

$CODEC, Coded.

2,35K

La société de recherche @epochbiz (par @ZoomerOracle) a publié un article de recherche détaillé sur CodecFlow.

Ne le manquez pas.

$CODEC

epoch_19 août, 21:07

$CODEC se prépare à être la meilleure option en tant que jeu onchain pour la robotique

L'article de recherche sur @codecopenflow est maintenant en ligne sur 🤖

3,61K

Nous constatons une augmentation du nombre de faux comptes prétendant représenter CodecFlow.

Les seuls X/Twitter officiels sont @codecopenflow et @RoboMove.

Toutes les autres chaînes vérifiées sont répertoriées sur notre site Web.

Il n’y a qu’un seul jeton, $CODEC.

Restez vigilant et signalez tout compte suspect.

Veuillez republier et partager pour aider à faire passer le mot.

3,31K

RoboMove est une vitrine alimentée entièrement par l'infrastructure CodecFlow.

Il n'y a pas de jeton séparé. $CODEC est le seul jeton au sein de l'écosystème.

@RoboMove n'est qu'un exemple de ce qui est possible avec les opérateurs CodecFlow.

Bientôt, les développeurs pourront créer leurs propres systèmes avancés sur CodecFlow en utilisant notre SDK et nos outils.

La plateforme est intentionnellement ouverte et extensible, permettant d'innombrables cas d'utilisation allant du contrôle robotique à l'automatisation de l'interface graphique.

⚠️ Ne tombez pas dans le piège des faux jetons ou des imitateurs. Vérifiez toujours auprès de sources officielles.

3,83K

Nous sommes ravis de voir la communauté chinoise remarquer CodecFlow et aimer ce que nous construisons.

Bienvenue à vous. Nous ne faisons que commencer. Beaucoup plus à venir.

0xFunky13 juil. 2025

La vente publique de PUMP est terminée. Au départ, j'avais également investi une grosse somme sur Bybit, en ne laissant qu'1/2 sur la chaîne, et finalement, seule la transaction sur la chaîne a réussi. Heureusement, je n'ai pas fait de couverture prématurée...

Cela dit, récemment, beaucoup de gens dans la communauté AI discutent de VLA (Vision-Language-Action).

J'ai particulièrement étudié s'il y avait des projets sur la chaîne liés à VLA et j'ai vu ce projet CodecFlow @Codecopenflow, j'en ai acheté un peu.

== Que fait le projet CodecFlow ==

Pour faire simple, VLA est une architecture de modèle qui permet à l'IA non seulement de « parler », mais aussi de « faire ».

Les LLM traditionnels (comme GPT) ne peuvent que comprendre le langage et fournir des suggestions, mais ils ne peuvent pas agir, cliquer sur des écrans ou saisir des objets.

Le modèle VLA signifie qu'il intègre trois grandes capacités :

1. Vision : comprendre les images, les captures d'écran, les entrées de caméra ou les données des capteurs.

2. Langage : comprendre les instructions en langage naturel des humains.

3. Action : générer des instructions exécutables, comme des clics de souris, des saisies au clavier, ou contrôler un bras robotique.

CodecFlow travaille sur le VLA sur la chaîne, tous les processus opérationnels peuvent également être enregistrés sur la chaîne, audités, vérifiés et réglés.

En résumé, c'est l'infrastructure de base pour un "robot IA".

== Pourquoi je fais particulièrement attention à ce projet ? ==

J'ai découvert que leurs développeurs sont des contributeurs clés du projet open source LeRobot, qui est le projet open source le plus en vogue dans le domaine du VLA !

LeRobot est la base de premier plan pour construire des modèles VLA dans le monde open source, y compris SmolVLA, qui peut fonctionner sur un ordinateur portable.

Cela signifie que cette équipe comprend vraiment l'architecture VLA et les robots.

Je vois qu'ils continuent à construire, et le prix du jeton augmente de manière stable. Je suis très optimiste sur le secteur VLA, et d'un point de vue global, VLA et les robots représentent vraiment l'avenir sur le marché.

• Les géants du Web2 (Google, Meta, Tesla) se sont actuellement pleinement engagés dans la formation VLA et robotique ;

• Il y a très peu de projets Web3 capables d'exécuter des applications VLA, ce qui est encore très rare.

• VLA a la possibilité de créer une immense valeur dans des scénarios tels que DePIN, l'automatisation Web, et l'exécution d'agents AI sur la chaîne.

CA : 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Faites toujours vos propres recherches (DYOR).

4,09K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables