Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Ausführungsschicht für KI-Bediener und Robotik auf @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpumpe

VLAs sind noch sehr neu und viele Menschen finden es schwierig, den Unterschied zwischen VLAs und LLMs zu verstehen.

Hier ist ein tiefer Einblick, wie sich diese KI-Systeme in Bezug auf Denken, Wahrnehmung und Handeln unterscheiden. Teil 1.

Lass uns die wichtigsten Unterschiede aufschlüsseln und wie KI-Agenten, die um ein LLM gewickelt sind, sich von Operator-Agenten unterscheiden, die VLA-Modelle verwenden:

1. Wahrnehmung: Wie sie die Welt wahrnehmen

Agent (LLM): Verarbeitet Text oder strukturierte Daten, z.B. JSON, APIs und manchmal Bilder. Es ist wie ein Gehirn, das mit sauberen, abstrahierten Eingaben arbeitet. Denk an das Lesen eines Handbuchs oder das Parsen einer Tabelle. Großartig für strukturierte Umgebungen, aber begrenzt durch das, was ihm zugeführt wird.

Operator (VLA): Sieht rohe, Echtzeit-Pixel von Kameras, plus Sensordaten (z.B. Berührung, Position) und Propriozeption (Selbstwahrnehmung der Bewegung). Es ist wie das Navigieren in der Welt mit Augen und Sinnen, das in dynamischen, chaotischen Umgebungen wie UIs oder physischen Räumen gedeiht.

2. Handeln: Wie sie interagieren

Agent: Handelt, indem er Funktionen, Werkzeuge oder APIs aufruft. Stell dir vor, es ist ein Manager, der präzise Anweisungen gibt wie „Buche einen Flug über die Expedia-API.“ Es ist absichtlich, aber abhängig von vorgefertigten Werkzeugen und klaren Schnittstellen.

Operator: Führt kontinuierliche, niedrigstufige Aktionen aus, wie das Bewegen eines Mauszeigers, Tippen oder das Steuern von Robotergelenken. Es ist wie ein geschickter Arbeiter, der direkt mit der Umgebung interagiert, ideal für Aufgaben, die Echtzeit-Präzision erfordern.

3. Kontrolle: Wie sie Entscheidungen treffen

Agent: Folgt einem langsamen, reflektierenden Zyklus: planen, ein Werkzeug aufrufen, das Ergebnis bewerten, wiederholen. Es ist tokengebunden (begrenzt durch die Textverarbeitung) und netzwerkgebunden (wartet auf API-Antworten). Das macht es methodisch, aber träge für Echtzeitanwendungen.

Operator: Arbeitet, trifft schrittweise Entscheidungen in einem engen Feedback-Zyklus. Denk an einen Gamer, der sofort auf das reagiert, was auf dem Bildschirm zu sehen ist. Diese Geschwindigkeit ermöglicht flüssige Interaktionen, erfordert jedoch eine robuste Echtzeitverarbeitung.

4. Daten zum Lernen: Was ihr Training antreibt

Agent: Wird auf riesigen Textkorpora, Anleitungen, Dokumentationen oder RAG (Retrieval-Augmented Generation) Datensätzen trainiert. Er lernt aus Büchern, Code oder FAQs und glänzt im Denken über strukturiertes Wissen.

Operator: Lernt aus Demonstrationen (z.B. Videos von Menschen, die Aufgaben ausführen), Teleoperationsprotokollen oder Belohnungssignalen. Es ist wie Lernen durch Zuschauen und Üben, perfekt für Aufgaben, bei denen explizite Anweisungen rar sind.

5. Fehlermodi: Wo sie versagen

Agent: Neigt zu Halluzinationen (Antworten erfinden) oder brüchigen Langzeitplänen, die zusammenbrechen, wenn ein Schritt fehlschlägt. Es ist wie ein Stratege, der überdenkt oder die Situation falsch einschätzt.

Operator: Sieht sich einer Kovariatenverschiebung gegenüber (wenn die Trainingsdaten nicht mit den realen Bedingungen übereinstimmen) oder kumulierten Fehlern in der Steuerung (kleine Fehler summieren sich). Es ist wie ein Fahrer, der auf einer unbekannten Straße die Kontrolle verliert.

6. Infrastruktur: Die Technik dahinter

Agent: Vertraut auf einen Prompt/Router, um zu entscheiden, welche Werkzeuge aufgerufen werden, ein Werkzeugverzeichnis für verfügbare Funktionen und Speicher/RAG für den Kontext. Es ist ein modulares Setup, wie ein Kommandozentrum, das Aufgaben orchestriert.

Operator: Benötigt Videoeingabepipelines, einen Aktionsserver für die Echtzeitsteuerung, einen Sicherheitsmechanismus, um schädliche Aktionen zu verhindern, und einen Replay-Puffer, um Erfahrungen zu speichern. Es ist ein Hochleistungssystem, das für dynamische Umgebungen gebaut ist.

7. Wo jeder glänzt: Ihre Stärken

Agent: Dominierend in Workflows mit sauberen APIs (z.B. Automatisierung von Geschäftsprozessen), Denken über Dokumente (z.B. Zusammenfassen von Berichten) oder Code-Generierung. Es ist dein Ansprechpartner für strukturierte, hochrangige Aufgaben.

Operator: Exzellent in chaotischen, API-losen Umgebungen wie dem Navigieren durch unhandliche UIs, dem Steuern von Robotern oder dem Bewältigen von spielähnlichen Aufgaben. Wenn es um Echtzeitinteraktion mit unvorhersehbaren Systemen geht, ist VLA der König.

8. Mentales Modell: Planer + Macher

Denk an den LLM-Agenten als den Planer: Er zerlegt komplexe Aufgaben in klare, logische Ziele.

Der VLA-Operator ist der Macher, der diese Ziele umsetzt, indem er direkt mit Pixeln oder physischen Systemen interagiert. Ein Prüfer (ein anderes System oder ein Agent) überwacht die Ergebnisse, um den Erfolg sicherzustellen.

$CODEC

18,31K

Codecflow Optr bietet einen einheitlichen Ansatz zum Erstellen von Agenten, die in digitalen und physischen Umgebungen sehen, denken und handeln. Ob bei der Automatisierung von Desktop-Workflows, der Steuerung von Roboterarmen oder dem Testen in Simulationen, es verwendet dasselbe mentale Modell und dieselben Primitiven.

Louround 🥂21. Aug., 04:10

Dips in einem Bullenmarkt sind dazu da, gekauft zu werden, insbesondere bei Projekten mit großen Katalysatoren.

Wir alle wissen, dass KI die Erzählung dieses Zyklus ist, die letztes Jahr von ai16z und Virtuals gestartet wurde.

Meine Wette ist, dass der Markt sich auf komplexere und ausgeklügelte Technologien wie VLAs konzentrieren wird, und lass mich dir sagen, warum.

LLMs (Large Language Models) lesen und schreiben hauptsächlich Text: Sie sind großartig darin, zu erklären, zu planen und Anweisungen zu generieren, aber sie steuern nicht von sich aus Motoren oder interagieren mit der physischen Welt (wie du vielleicht mit chatgpt erfahren hast).

VLAs (Vision Language Action Modelle) unterscheiden sich von LLMs, da sie multimodale Systeme sind, die Dinge betrachten (Vision), Anweisungen verstehen (Sprache) und direkt Aktionen ausführen. Es ist, als würde man einem Roboter sagen, er solle einen roten Becher aufheben, und dann bewegt er seinen Arm, um es zu tun.

VLAs werden an Beispielen trainiert, die Bilder/Videos + Anweisungen + echte Aktionsspuren (wie sich ein Roboter tatsächlich bewegt hat) paaren, und sie müssen schnell und sicher in Echtzeit arbeiten. LLMs hingegen werden an riesigen Textsammlungen trainiert und konzentrieren sich auf Denk- und Sprachaufgaben.

TL;DR LLMs denken und sprechen, während VLAs sehen, denken und handeln.

Wie du sehen kannst, sind VLAs eine wesentliche Ergänzung zu LLMs und werden die nächste 0 zu 1 Innovation in der gesamten Wirtschaft ermöglichen, die Robotik sein wird. Eine Mehrheit der Investmentfonds investiert einen großen Teil ihrer Mittel in diesen Sektor, der als die nächste logische Evolution in der KI-Industrie angesehen wird.

Ich habe vor einiger Zeit einen Beitrag über den aktuellen Marktführer im Krypto-Markt, @codecopenflow, gemacht, der kein Kapital aufgenommen hat (fair launch), aber dennoch bahnbrechende Produkte liefert und derzeit bei 23 Millionen USD FDV sitzt.

Zur Information: Andere Krypto-Wettbewerber haben 20 Millionen USD (@openmind_agi) aufgenommen, bei einem wahrscheinlich 200 Millionen bis 300 Millionen ++ FDV, während noch kein Produkt oder keine Community aufgebaut und ausgeliefert wurde.

Was Codec zu einem führenden Projekt im Sektor macht, ist, dass sie ein entscheidendes Engpassproblem in der Robotik und KI angehen, nämlich die Schwierigkeit, alle KI-Tools miteinander interagieren zu lassen. Lass mich das erklären.

Ihr neuester Release, OPTR (Operator), ist ein Toolkit, das hilft, Operatoren zu erstellen, die auf mehreren Plattformen wie Robotern, Desktops, Browsern oder Simulationen interagieren können. Das Ziel eines Operators ist es, zu sehen, zu denken und zu handeln (VLA) in sowohl digitalen (Computern) als auch physischen (Robotern) Welten.

Dieses Toolkit dient als Kerninfrastruktur für Robotikteams, die ihr Produkt testen und den gesamten Prozess verbessern möchten, indem es eine einheitliche Erfahrung anstelle separater für Webbrowser, Simulationen oder Roboter bietet. Dies macht den Operator im Wesentlichen anpassungsfähig und autonom, unabhängig von seiner Umgebung.

Also verstehst du, es wird viel Zeit für Unternehmen und Entwickler sparen, die zuvor jeden Schritt manuell durchlaufen mussten, und wo man Zeit sparen kann, kann man Geld sparen.

Es wird auch Codec ermöglichen, ihre eigenen Operator-Projekte zu entwickeln und neue Kapazitäten relativ schnell auf den Markt zu bringen, insbesondere über ihren Marktplatz.

TL;DR: Du hast wahrscheinlich Videos von Robotern gesehen, die Taschentücher falten, Kisten sortieren oder auf verschiedenen Elementen springen. Sie wurden alle für diesen sehr spezifischen Anwendungsfall trainiert, und leider kann eine Fähigkeit nicht in einer anderen Umgebung wiederverwendet werden, wie es ein Mensch tun könnte. OPTR von Codec löst dies, indem es Fähigkeiten über Umgebungen und Situationen übertragbar macht, was das Training und die Entwicklung für Unternehmen viel schneller und günstiger macht.

Deshalb ist Codec so interessant, um die digitale Welt mit der physischen Welt zu vereinen.

$CODEC, Coded.

2,27K

Das Forschungsunternehmen @epochbiz (von @ZoomerOracle) hat ein detailliertes Forschungspapier zu CodecFlow veröffentlicht.

Verpassen Sie es nicht.

$CODEC

epoch_19. Aug., 21:07

$CODEC bereitet sich darauf vor, die beste Option als Onchain-Spiel für Robotik zu sein.

Der Forschungsartikel über @codecopenflow ist jetzt live auf 🤖

3,54K

Wir sehen einen Anstieg gefälschter Konten, die behaupten, CodecFlow zu vertreten.

Die einzigen offiziellen X/Twitter-Konten sind @codecopenflow und @RoboMove.

Alle anderen verifizierten Kanäle sind auf unserer Website aufgeführt.

Es gibt nur einen Token, $CODEC.

Bleiben Sie wachsam und melden Sie verdächtige Konten.

Bitte teilen und verbreiten Sie die Nachricht.

3,23K

RoboMove ist eine Präsentation, die vollständig von der CodecFlow-Infrastruktur betrieben wird.

Es gibt keinen separaten Token. $CODEC ist der einzige Token im Ökosystem.

@RoboMove ist nur ein Beispiel dafür, was mit CodecFlow-Betreibern möglich ist.

Bald werden Entwickler in der Lage sein, ihre eigenen fortschrittlichen Systeme auf CodecFlow mit unserem SDK und unseren Werkzeugen zu erstellen.

Die Plattform ist absichtlich offen und erweiterbar, was endlose Anwendungsfälle von der Robotersteuerung bis zur GUI-Automatisierung ermöglicht.

⚠️ Lassen Sie sich nicht von gefälschten Tokens oder Nachahmern täuschen. Überprüfen Sie immer die offiziellen Quellen.

3,75K

Wir freuen uns zu sehen, dass die chinesische Community CodecFlow bemerkt und liebt, was wir aufbauen.

欢迎你们. Wir fangen gerade erst an. Es kommt noch viel mehr.

0xFunky13. Juli 2025

PUMP Der öffentliche Verkauf ist beendet. Ursprünglich hatte ich auch einen großen Betrag bei Bybit, nur die Hälfte auf der Blockchain, am Ende hat nur die Blockchain-Transaktion funktioniert, zum Glück habe ich nicht vorzeitig abgesichert...

Übrigens diskutieren in letzter Zeit viele im AI-Community über VLA (Vision‑Language‑Action).

Ich habe speziell untersucht, ob es auf der Blockchain-Projekte gibt, die sich mit VLA beschäftigen, und habe das Projekt CodecFlow @Codecopenflow gesehen und ein wenig gekauft.

== Was macht das CodecFlow-Projekt? ==

Eine kurze Einführung in VLA: VLA ist eine Modellarchitektur, die es AI ermöglicht, nicht nur "reden" zu können, sondern auch "handeln" zu können.

Traditionelle LLMs (wie GPT) können nur Sprache verstehen und Vorschläge machen, aber sie können nicht selbst handeln, nicht auf dem Bildschirm klicken und keine Objekte greifen.

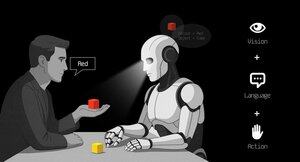

Das VLA-Modell bedeutet, dass drei Hauptfähigkeiten integriert sind:

1. Vision (Sicht): Verstehen von Bildern, Screenshots, Kameraeingaben oder Sensordaten.

2. Language (Sprache): Verstehen von natürlichen Sprachbefehlen der Menschen.

3. Action (Aktion): Erzeugen von ausführbaren Befehlen, wie Mausklicks, Tastatureingaben und Steuerung von Roboterarmen.

CodecFlow arbeitet an der Blockchain-VLA, alle Abläufe können auch auf der Blockchain gespeichert werden, sind prüfbar, verifizierbar und abgerechnet.

Kurz gesagt, es ist die grundlegende Infrastruktur für "AI-Roboter".

== Warum achte ich besonders auf dieses Projekt? ==

Ich habe festgestellt, dass ihre Entwickler die Hauptbeiträger des heißesten Open-Source-Projekts im VLA-Bereich, LeRobot, sind!

LeRobot ist die Top-Basis in der Open-Source-Welt für den Aufbau von VLA-Modellen, einschließlich SmolVLA, das auf Laptops läuft.

Das bedeutet, dass dieses Team wirklich die VLA-Architektur und Roboter versteht.

Ich sehe, dass sie weiterhin aufbauen, der Preis der Münze stabil steigt, ich persönlich bin sehr optimistisch über den VLA-Sektor, und insgesamt gesehen ist VLA zusammen mit Robotern in der Marktlandschaft definitiv die Zukunft.

• Web2-Giganten (Google, Meta, Tesla) haben derzeit alle Ressourcen in VLA & Roboterschulung investiert;

• Web3-Projekte, die in der Lage sind, Aufgaben auszuführen, sind im VLA-Anwendungsbereich noch sehr rar.

• VLA hat die Möglichkeit, in Szenarien wie DePIN, Web-Automatisierung und Blockchain-AI-Agenten enorme Werte zu schaffen.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Immer DYOR.

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten