Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Camada de execução para operadores de IA e robótica no @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

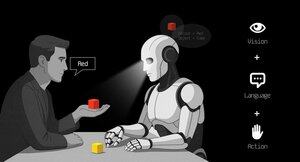

Os VLAs ainda são muito novos e muitas pessoas acham difícil entender a diferença entre VLAs e LLMs.

Aqui está um mergulho profundo em como esses sistemas de IA diferem em raciocínio, detecção e ação. Parte 1.

Vamos detalhar as principais distinções e como os agentes de IA envolvidos em um LLM diferem dos agentes operadores que usam modelos VLA:

1. Sentido: como eles percebem o mundo

Agente (LLM): processa texto ou dados estruturados, por exemplo, JSON, APIs e, às vezes, imagens. É como um cérebro trabalhando com entradas limpas e abstratas. Pense em ler um manual ou analisar uma planilha. Ótimo para ambientes estruturados, mas limitado pelo que é alimentado a ele.

Operador (VLA): Vê pixels brutos e em tempo real das câmeras, além de dados do sensor (por exemplo, toque, posição) e propriocepção (autoconsciência do movimento). É como navegar pelo mundo com olhos e sentidos, prosperando em ambientes dinâmicos e confusos, como interfaces de usuário ou espaços físicos.

2. Agir: como eles interagem

Agente: atua chamando funções, ferramentas ou APIs. Imagine isso como um gerente enviando instruções precisas como "reserve um voo via API da Expedia". É deliberado, mas depende de ferramentas pré-construídas e interfaces claras.

Operador: Executa ações contínuas e de baixo nível, como mover o cursor do mouse, digitar ou controlar as articulações do robô. É como um trabalhador qualificado manipulando diretamente o ambiente, ideal para tarefas que exigem precisão em tempo real.

3. Controle: como eles tomam decisões

Agente: Segue um ciclo lento e reflexivo: planejar, chamar uma ferramenta, avaliar o resultado, repetir. É vinculado a token (limitado por processamento de texto) e vinculado à rede (aguardando respostas da API). Isso o torna metódico, mas lento para tarefas em tempo real.

Operador: Opera, tomando decisões passo a passo em um ciclo de feedback apertado. Pense nisso como um jogador reagindo instantaneamente ao que está na tela. Essa velocidade permite a interação fluida, mas exige processamento robusto em tempo real.

4. Dados para aprender: o que alimenta seu treinamento

Agente: treinado em vastos corpora de texto, instruções, documentação ou conjuntos de dados RAG (Retrieval-Augmented Generation). Ele aprende com livros, códigos ou perguntas frequentes, destacando-se no raciocínio sobre o conhecimento estruturado.

Operador: Aprende com demonstrações (por exemplo, vídeos de humanos realizando tarefas), registros de teleoperação ou sinais de recompensa. É como aprender observando e praticando, perfeito para tarefas em que instruções explícitas são escassas.

5. Modos de falha: onde eles quebram

Agente: Propenso a alucinações (inventar respostas) ou planos frágeis de longo prazo que desmoronam se uma etapa falhar. É como um estrategista que pensa demais ou interpreta mal a situação.

Operador: enfrenta mudança de covariável (quando os dados de treinamento não correspondem às condições do mundo real) ou erros compostos no controle (pequenos erros bola de neve). É como um motorista perdendo o controle em uma estrada desconhecida.

6. Infra: A tecnologia por trás deles

Agente: depende de um prompt/roteador para decidir quais ferramentas chamar, um registro de ferramentas para funções disponíveis e memória/RAG para contexto. É uma configuração modular, como um centro de comando orquestrando tarefas.

Operador: precisa de pipelines de ingestão de vídeo, um servidor de ação para controle em tempo real, um escudo de segurança para evitar ações prejudiciais e um buffer de reprodução para armazenar experiências. É um sistema de alto desempenho criado para ambientes dinâmicos.

7. Onde cada um brilha: seus pontos ideais

Agente: domina fluxos de trabalho com APIs limpas (por exemplo, automatizando processos de negócios), raciocínio sobre documentos (por exemplo, resumindo relatórios) ou geração de código. É a sua escolha para tarefas estruturadas e de alto nível.

Operador: Destaca-se em ambientes confusos e sem API, como navegar em interfaces de usuário desajeitadas, controlar robôs ou lidar com tarefas semelhantes a jogos. Se envolver interação em tempo real com sistemas imprevisíveis, o VLA é rei.

8. Modelo Mental: Planejador + Fazedor

Pense no Agente LLM como o planejador: ele divide tarefas complexas em metas claras e lógicas.

O Operador VLA é o executor, executando essas metas interagindo diretamente com pixels ou sistemas físicos. Um verificador (outro sistema ou agente) monitora os resultados para garantir o sucesso.

$CODEC

21,71K

O Codecflow Optr oferece uma abordagem unificada para criar agentes que veem, raciocinam e agem em ambientes digitais e físicos. Seja automatizando fluxos de trabalho de desktop, controlando braços robóticos ou testando em simulação, ele usa o mesmo modelo mental e primitivos.

Louround 🥂21 de ago., 04:10

Quedas em um mercado em alta devem ser compradas, especialmente em projetos com grandes catalisadores

Todos sabemos que a IA é a narrativa deste ciclo, iniciado por ai16z e Virtuals no ano passado.

Minha aposta é que o mercado se concentrará em tecnologias mais complexas e sofisticadas, como VLAs, e deixe-me dizer por quê.

Os LLMs (Large Language Models) leem e escrevem principalmente texto: eles são ótimos para explicar, planejar e gerar instruções, mas não controlam por si só os motores ou interagem com o mundo físico (como você pode ter experimentado com o chatgpt).

Os VLAs (modelos de ação de linguagem de visão) diferem dos LLMs, pois são sistemas multimodais que olham para as coisas (visão), entendem instruções (linguagem) e produzem ações diretamente. É como dizer a um robô para pegar um copo vermelho e depois mover o braço para fazê-lo.

Os VLAs são treinados em exemplos que combinam imagens/vídeo + instruções + traços de ação real (como um robô realmente se moveu) e devem ser executados com rapidez e segurança em tempo real. Os LLMs, por sua vez, são treinados em enormes coleções de texto e se concentram em tarefas de raciocínio e linguagem.

TL; Os LLMs de DR pensam e falam enquanto os VLAs veem, raciocinam e agem.

Como você pode ver, os VLAs são uma grande adição aos LLMs e permitirão notavelmente a próxima inovação de 0 para 1 na economia geral que será a robótica. A maioria dos fundos de investimento está alocando grande parte de seus investimentos neste setor, visto como a próxima evolução lógica na indústria de IA.

Já fiz um post há algum tempo sobre o atual líder do mercado de criptomoedas, @codecopenflow, que não levantou capital (lançamento justo), mas está enviando produtos de ponta e atualmente está com US$ 23 milhões de FDV.

Para obter informações, outros concorrentes de criptomoedas levantaram US$ 20 milhões (@openmind_agi) no que provavelmente é um $ 200 milhões a US$ 300 milhões ++ FDV, embora nenhum produto ou comunidade tenha sido construído e enviado ainda.

O que torna o Codec um projeto líder no setor é que eles abordam um gargalo crucial na robótica e na IA, que é a dificuldade de fazer com que todas as ferramentas de IA interajam juntas. Deixe-me explicar.

Sua versão mais recente, OPTR (operador), é um kit de ferramentas que ajuda a criar operadores capazes de interagir em várias plataformas, como robôs, desktops, navegadores ou simulações. O objetivo de um operador é ver, raciocinar e agir (VLA) nos mundos digital (computadores) e físico (robôs).

Esse kit de ferramentas serve como infraestrutura central para equipes robóticas que desejam testar seus produtos e aprimorar o processo geral, fornecendo uma experiência unificada em vez de uma experiência separada para navegadores da Web, simulações ou robôs. Isso essencialmente torna o operador adaptável e autônomo, independentemente de seu ambiente.

Então você entende, economizará muito tempo para empresas e desenvolvedores que anteriormente tinham que passar por cada etapa manualmente e onde você pode economizar tempo, você pode economizar dinheiro.

Também permitirá que a Codec construa seus próprios projetos de operadoras e lance novas capacidades relativamente rápido no mercado, principalmente por meio de seu mercado.

TL; DR: Você provavelmente já viu vídeos de robôs dobrando lenços, classificando caixas ou pulando em vários elementos. Todos eles foram treinados para este caso de uso muito específico e, infelizmente, uma habilidade não pode ser reutilizada em outro ambiente como um humano poderia fazer. O OPTR da Codec resolve isso tornando as habilidades transferíveis entre ambientes e situações, tornando o treinamento e o desenvolvimento muito mais rápidos e baratos para as empresas.

É por isso que o Codec é tão interessante em unificar o mundo digital com o mundo físico.

$CODEC, codificado.

2,59K

A empresa de pesquisa @epochbiz (por @ZoomerOracle) publicou uma pesquisa detalhada sobre o CodecFlow.

Não perca.

$CODEC

epoch_19 de ago., 21:07

$CODEC está se configurando para ser a melhor opção como jogo onchain para robótica

Artigo de pesquisa sobre @codecopenflow já está disponível em 🤖

3,64K

Estamos vendo um aumento nas contas falsas que afirmam representar o CodecFlow.

O único X / Twitter oficial é @codecopenflow e @RoboMove.

Todos os outros canais verificados estão listados em nosso site.

Existe apenas um token, $CODEC.

Fique atento e denuncie quaisquer contas suspeitas.

Por favor, reposte e compartilhe para ajudar a espalhar a palavra.

3,33K

RoboMove é uma vitrine alimentada inteiramente pela infraestrutura CodecFlow.

Não há token separado. $CODEC é o único token dentro do ecossistema.

@RoboMove é apenas um exemplo do que é possível com os operadores CodecFlow.

Em breve, os desenvolvedores poderão criar seus próprios sistemas avançados no CodecFlow usando nosso SDK e ferramentas.

A plataforma é intencionalmente aberta e extensível, permitindo casos de uso infinitos, desde controle robótico até automação de GUI.

⚠️ Não caia em tokens falsos ou imitadores. Sempre verifique de fontes oficiais.

3,85K

Estamos felizes em ver a comunidade chinesa percebendo o CodecFlow e amando o que estamos construindo.

Bem-vindo. Estamos apenas começando. Muito mais por vir.

0xFunky13 de jul. de 2025

A venda pública da PUMP acabou, originalmente eu também era uma grande quantia na Bybit, apenas 1/2 na cadeia, e no final, apenas a cadeia foi bem-sucedida, felizmente não houve hedge antecipado...

Recentemente, tem havido muita discussão na comunidade de IA sobre VLA (Visão-Linguagem-Ação)

Em particular, fui pesquisar se havia alguém fazendo projetos relacionados ao VLA na rede, e vi esse CodecFlow@Codecopenflow projeto e comprei um pouco.

== O que o CodecFlow está fazendo ==

Uma breve introdução ao VLA, uma arquitetura de modelo que permite que a IA não apenas "fale", mas "faça".

Os LLMs tradicionais (como o GPT) só podem entender a linguagem e dar sugestões, mas não podem fazer hands-on, clicar em telas ou pegar objetos.

O modelo VLA significa que ele integra três recursos:

1. Visão: entenda imagens, capturas de tela, entradas de câmera ou dados do sensor

2. Linguagem: Entenda as instruções de linguagem natural humana

3. Ação: Gere comandos executáveis, como cliques do mouse, entrada de teclado e controle do braço robótico

O CodecFlow está fazendo o VLA na cadeia, e todos os processos também podem ser carregados na cadeia, que podem ser auditados, verificados e liquidados.

Em termos simples, é a infraestrutura de um "bot de IA".

== Por que estou prestando atenção especial a este item? ==

Descobri que seus desenvolvedores são os principais colaboradores do LeRobot, o projeto de código aberto mais quente no espaço VLA!

A LeRobot é a principal base para a construção de modelos de VLA no mundo de código aberto, incluindo VLAs leves que podem ser executados em laptops como o SmolVLA.

Isso significa que essa equipe realmente entende a arquitetura VlA e o Robot.

Vejo que eles também continuam a crescer, e o preço da moeda também está subindo de forma constante, estou muito otimista sobre a faixa do VLA e, pela tendência geral, o VLA e os robôs são de fato o futuro no mercado.

• Os gigantes da Web2 (Google, Meta, Tesla) agora estão totalmente comprometidos com o VLA e o treinamento de bots;

• Projetos Web3 são escassos em termos de aplicativos VLA que podem executar tarefas

• O VLA tem a oportunidade de desempenhar um papel importante em cenários como DePIN, automação da Web e execução de agentes de IA on-chain.

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Sempre DYOR。

4,11K

Melhores

Classificação

Favoritos

Em alta on-chain

Em alta no X

Principais fundos da atualidade

Mais notável